OpenClaw 支持 12 种以上 LLM 服务商,包括用于本地隐私保护的 Ollama、追求顶级性能的 OpenAI 和 Anthropic,以及提供多模型访问的 OpenRouter。运行 openclaw onboard 即可启动交互式配置向导,选择你的服务商,五分钟内你的 AI 代理就能投入使用。本指南覆盖所有服务商的配置路径,帮助你将模型与硬件和预算精准匹配,揭示如何完全免费使用 OpenClaw,并提供最常见配置错误的逐步修复方案。

OpenClaw 是什么以及为什么 LLM 选择至关重要

OpenClaw 是一个开源 AI 代理框架,截至 2026 年 2 月在 GitHub 上拥有超过 145,000 颗星,它能将大型语言模型转变为自主编程助手、DevOps 工具和通用代理。该项目由 Peter Steinberger 创建,前身先后为 Moltbot 和 Clawdbot,现已发展为生态系统中维护最活跃的代理框架之一。与简单的聊天封装工具不同,OpenClaw 赋予 LLM 执行 Shell 命令、编辑文件、浏览网页以及编排复杂多步骤工作流的能力——这意味着你选择的模型直接决定了代理能完成什么任务以及运行成本。

你在配置过程中选择的 LLM 服务商不仅仅是一个技术选项。它决定了三件会直接影响你日常使用 OpenClaw 体验的事情。首先,它设定了代理的智能上限:像 Qwen2.5 7B 这样的小型本地模型能处理简单的文件编辑,但面对 Claude Sonnet 4.5 或 GPT-5.2 轻松应对的多文件重构任务时就会力不从心。其次,它控制着你的运营成本:云端 API 按 token 计费,如果你运行复杂的代理循环,一个活跃的 OpenClaw 会话每天可能消耗数百万个 token。第三,它决定了数据隐私:你发送给云端服务商的每一条提示都会离开你的机器,如果你处理的是专有代码或敏感配置文件,这一点尤其重要。

OpenClaw 目前支持 12 个官方服务商:Ollama、OpenAI、Anthropic、OpenRouter、Amazon Bedrock、Vercel AI Gateway、Moonshot AI、MiniMax、OpenCode Zen、GLM Models、Z.AI 和 Synthetic。每个服务商各有优势。官方文档中指出 GLM Models "在编程和工具调用方面表现更好",而 MiniMax 则"更擅长写作和创意内容"(docs.openclaw.ai,2026 年 2 月)。这种多样性是一种优势——但也意味着你需要在运行 openclaw onboard 之前有一个清晰的决策框架。本指南的后续内容恰好提供了这个框架,从如何选择合适的服务商开始,然后逐步介绍每个主要选项的配置方法,最后讲解成本优化和问题排查。

如何选择合适的 LLM 服务商

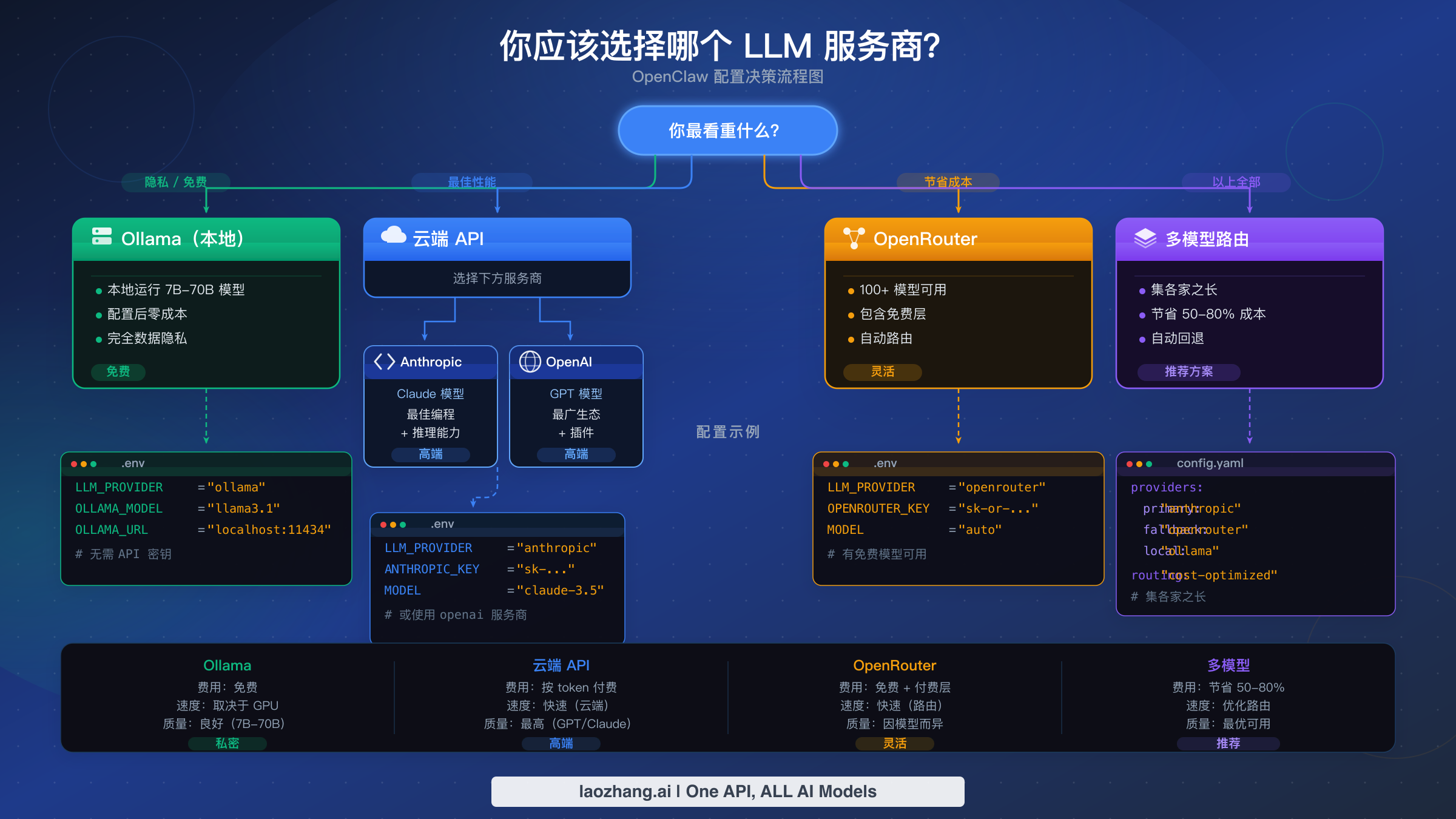

为 OpenClaw 选择合适的 LLM 服务商归结为四个因素:你的预算、你的硬件条件、你的隐私需求以及你计划运行的任务复杂度。本节不会罗列每个服务商让你自己去研究,而是根据你最看重的因素给出具体的决策路径。上方的流程图总结了四条主要路径,下方的决策表将常见场景映射到具体推荐方案。

| 优先级 | 推荐服务商 | 最佳模型 | 月成本 | 配置难度 |

|---|---|---|---|---|

| 隐私 + 免费 | Ollama(本地) | Qwen2.5-Coder 7B | $0 | 中等 |

| 最佳性能 | Anthropic | Claude Sonnet 4.5 | $50-200 | 简单 |

| 经济云端 | OpenRouter | DeepSeek V3.2 | $5-30 | 简单 |

| 最大灵活性 | OpenRouter + Ollama | 混合使用 | $10-50 | 中等 |

| 企业级 | Amazon Bedrock | Claude via Bedrock | 按需定价 | 较难 |

如果隐私是你的首要考量,Ollama 是唯一的答案。所有提示数据都留在你的机器上,无需 API 密钥,除了电费之外成本为零。代价是能力受限:在大多数消费级硬件上,本地模型的参数量上限大约在 32B 左右,这意味着它们能很好地处理单文件任务,但在复杂的多步推理方面会比较吃力。如果你的机器拥有 64GB 或更多内存,可以运行 30-32B 参数的模型如 DeepSeek-Coder-V2,在 Apple M4 芯片上大约能达到每秒 10-15 个 token 的速度(marc0.dev 基准测试,2026 年 1 月),在许多编程任务上已经能与云端模型相媲美。

如果你追求最佳的代理性能,Anthropic 的 Claude Sonnet 4.5 以每百万输入/输出 token $3/$15 的价格(haimaker.ai,2026 年 1 月)提供了能力、工具调用可靠性和成本之间的最佳平衡。对于需要更深层推理的任务——架构决策、复杂调试、大规模重构——Claude Opus 4.5 以每百万 token $15/$75 的价格是高端选择。你可以查看我们的 Claude Opus 与 Sonnet 详细对比,了解什么情况下值得支付额外费用。OpenAI 的 GPT-5.2 在类似价位上也是一个强有力的替代选择,特别是如果你已经深度使用 OpenAI 生态系统。

如果你想在使用云端模型的同时最小化成本,OpenRouter 是最佳起点。它充当连接数十个不同服务商模型的网关,并提供免费层模型供你零成本使用。DeepSeek V3.2 每百万 token 仅 $0.53,Xiaomi MiMo-V2-Flash 每百万 token 仅 $0.40(velvetshark.com,2026 年 2 月),以高端模型定价的一小部分提供了令人惊喜的编程性能。OpenRouter 还支持下文成本优化章节中介绍的多模型路由策略。

如果你追求最大灵活性,可以将 Ollama 用于本地隐私保护与 OpenRouter 用于云端备选相结合。这让你兼得两方优势:敏感任务在本地处理,复杂任务升级到更强大的云端模型,即使某个服务商出现故障你的代理也能继续运行。这种方案的配置方法在多模型路由章节中有详细说明。

使用 Ollama 配置本地模型

Ollama 是 OpenClaw 最流行的本地 LLM 运行时,原因充分:它免费、所有数据留在本地、无需 API 密钥。配置过程分为三个阶段——安装 Ollama、拉取模型、连接到 OpenClaw。在网络连接良好的现代机器上,整个过程不到十分钟。

安装 Ollama 在三大主流平台上都很简单。在 macOS 上,从 ollama.com 下载安装程序或使用 Homebrew。在 Linux 上,官方安装脚本会处理一切。在 Windows 上,Ollama 提供了原生安装程序。

bashbrew install ollama # Linux (official script) curl -fsSL https://ollama.com/install.sh | sh # Windows: download from ollama.com/download

安装完成后,启动 Ollama 服务器。在 macOS 和 Windows 上,桌面应用会自动启动服务。在 Linux 上,你可能需要手动运行 ollama serve 来启动服务。服务器默认监听 http://127.0.0.1:11434——这就 是 OpenClaw 将要连接的端点。

拉取合适的模型完全取决于你的可用内存。这是大多数用户犯的第一个错误:他们试图在 16GB 笔记本上拉取一个 70B 参数的模型,然后困惑为什么一切都卡住了。经验法则是,对于量化模型,每十亿个参数大约需要 1GB 内存,还要为操作系统和 OpenClaw 本身留出额外空间。

| 可用内存 | 推荐模型 | 参数量 | 预期速度 | 适用场景 |

|---|---|---|---|---|

| 8GB | qwen2.5-coder:3b | 3B | 25-35 tok/s | 轻量编辑、简单脚本 |

| 16GB | qwen2.5-coder:7b | 7B | 15-20 tok/s | 单文件编程、调试 |

| 32GB | deepseek-coder-v2:16b | 16B | 12-18 tok/s | 多文件任务、中等推理 |

| 64GB+ | deepseek-coder-v2:33b | 33B | 10-15 tok/s | 复杂重构、架构设计 |

用一条命令拉取你选择的模型:

bash# For 16GB machines (most common) ollama pull qwen2.5-coder:7b # Verify the model is available ollama list

将 Ollama 连接到 OpenClaw 通过配置向导完成。运行 openclaw onboard 并选择 Ollama 作为服务商。向导会检测你已经拉取的模型并让你选择。在后台,它会将配置写入 OpenClaw 设置文件中的 agents.defaults.model.primary 键。

bash# Start the setup wizard openclaw onboard # Or configure manually via CLI openclaw models set ollama/qwen2.5-coder:7b

如果你更倾向于手动配置,关键的环境变量是 OLLAMA_API_KEY。尽管名字中包含"KEY",Ollama 实际上并不需要认证——设置为任意非空字符串如 ollama-local 即可满足 OpenClaw 的验证要求:

bashexport OLLAMA_API_KEY="ollama-local"

官方文档中有一个重要细节:OpenClaw 默认禁用了 Ollama 的流式输出。这意味着你会看到完整的响应一次性出现,而不是逐 token 显示。对于大多数代理工作流来说这没有问题,但如果你更喜欢流式输出,可以在服务商配置中启用。

验证配置是否正确 是很多教程跳过的关键步骤。将 Ollama 连接到 OpenClaw 后,发送一个简单的测试提示来确认一切端到端正常工作。如果代理能返回连贯的输出并执行基本的工具调用(比如列出目录中的文件),说明你的本地 LLM 已正确配置,所有 token 都在你自己的硬件上处理。如果你看到乱码输出或代理拒绝使用工具,可能是模型缺乏足够的工具调用能力——在这种情况下,切换到 Qwen2.5-Coder 或 DeepSeek-Coder-V2,它们在 2026 年 2 月时拥有最强的本地工具调用支持。

本地模型的性能调优 会在日常使用中带来明显差异。如果响应感觉很慢,用 ollama ps 检查 Ollama 在内存中加载了多少个模型。Ollama 会将最近使用的模型保留在内存中,同时加载多个大型模型会降低性能。使用 ollama stop MODEL_NAME 卸载你不再使用的模型。在 Apple Silicon Mac 上,确保 Ollama 使用了 GPU 加速——这通常自动发生,但你可以在 Ollama 日志中验证。对于使用 NVIDIA GPU 的 Linux 用户,安装相应驱动后 Ollama 支持 CUDA 加速,与纯 CPU 推理相比可以将推理速度提升 3-5 倍。

配置云端 LLM 服务商

云端服务商让你的 OpenClaw 代理能够访问当前最强大的模型,代价是将提示通过互联网发送并按 token 付费。最常用的三个云端服务商是 OpenAI、Anthropic 和 OpenRouter。每个都需要 API 密钥,通过 openclaw onboard 的配置过程几乎相同——主要区别在于从哪里获取密钥以及可以使用哪些模型。

OpenAI 配置需要从 platform.openai.com 获取 API 密钥。创建账户后,导航到 API Keys 页面并生成新密钥。然后通过配置向导传入或设置为环境变量:

bashexport OPENAI_API_KEY="sk-proj-..." # Run the setup wizard openclaw onboard # Select OpenAI → paste your key → choose a model

OpenAI 让你可以使用 GPT 系列模型。对于 OpenClaw 代理工作,GPT-5.2 提供了能力和成本的最佳平衡。OpenAI 的关键优势在于其广泛的生态系统——如果你已经设置了计费和团队 API 访问权限,添加 OpenClaw 配置非常简单。

Anthropic 配置遵循同样的模式。从 console.anthropic.com 获取 API 密钥,然后进行配置:

bashexport ANTHROPIC_API_KEY="sk-ant-..." openclaw onboard # Select Anthropic → paste your key → choose Claude Sonnet 4.5 or Opus 4.5

Claude 模型被广泛认为是代理编程任务中最强的,特别是在工具调用和多步骤工作流方面。Claude Sonnet 4.5 以每百万 token $3/$15 的价格是日常使用的最佳选择,而 Opus 4.5 以每百万 token $15/$75 的价格则用于最具挑战性的任务。如果你在配置过程中遇到问题,我们的 Anthropic API 密钥配置问题指南涵盖了最常见的陷阱,包括密钥格式验证和区域限制。

OpenRouter 配置略有不同,因为 OpenRouter 本身不是模型提供商——它是一个将请求路由到数十个不同服务商模型的网关。这意味着一个 OpenRouter API 密钥就能让你访问 Claude、GPT、Gemini、Llama、Mistral、DeepSeek 等众多模型。从 openrouter.ai/keys 获取密钥:

bashexport OPENROUTER_API_KEY="sk-or-..." openclaw onboard # Select OpenRouter → paste your key → browse available models

OpenRouter 的独特优势在于模型多样性。你可以在不更改 OpenClaw 配置的情况下在服务商之间切换——只需更改模型名称。这也使得下文介绍的成本优化策略成为可能,即将简单任务路由到便宜的模型,将复杂任务路由到高端模型。

如果你需要一个能路由到多个 AI 模型的统一 API 端点,并且希望简化计费和保持稳定运行,laozhang.ai 等 API 聚合平台通过单一 API 密钥提供对 OpenAI、Anthropic 等多个服务商的统一访问。当你想使用多个云端服务商但不想为每个分别管理账户和计费时,这可以大大简化你的配置流程。

使用免费模型运行 OpenClaw

OpenClaw 一个鲜为人知的特性是你可以零 API 成本运行它。有两条免费使用路径:通过 Ollama 使用本地模型(上文已介绍)和通过 OpenRouter 使用免费云端模型。第二条路径特别有趣,因为它让你无需花费一分钱就能获得云端级别的推理能力。

OpenClaw 内置了一个模型扫描器,可以发现 OpenRouter 上可用的免费模型。运行 openclaw models scan 会查询 OpenRouter API 并返回零定价的模型列表——这些是服务商免费提供的模型,通常是为了推动采用或作为社区贡献。可用模型会随时间变化,但在任何时刻通常都有 10-20 个免费模型可供选择。

bash# Discover free models openclaw models scan # Example output (availability varies): # ✓ meta-llama/llama-3.2-8b-instruct (free) # ✓ google/gemma-2-9b-it (free) # ✓ mistralai/mistral-7b-instruct (free) # ✓ qwen/qwen-2.5-7b-instruct (free)

要使用免费模型,在 openclaw onboard 时选择它或直接设置:

bashopenclaw models set openrouter/meta-llama/llama-3.2-8b-instruct

使用免费模型的真实取舍是:它们通常较小(7-9B 参数),与付费模型相比可能有速率限制或更高的延迟。对于学习 OpenClaw、试验代理工作流或处理文件整理和基础代码生成等简单任务,免费模型确实很有用。对于生产级编程辅助或复杂多步骤任务,你最终会想要升级到付费模型——但从免费模型开始意味着你可以在没有任何财务承诺的情况下学习整个 OpenClaw 工作流程。

你还可以利用多模型路由策略组合使用免费和付费模型。将免费模型配置为简单任务的默认选项,付费模型作为复杂任务的备选。这样大部分交互都是零成本的,只有当任务确实需要更强大的模型时你才付费。这种方案的配置方法在下一节中有详细说明。

另一条零成本使用 OpenClaw 的路径是利用服务商的免费额度。OpenAI、Anthropic 和 Google 都为新账户提供有限的免费 API 访问。这些免费额度通常足够你在承诺付费使用之前充分试验 OpenClaw。请查看每个服务商当前的免费额度条款,因为它们经常变化。

使用免费模型的战略方法是将其作为你的学习环境。当你初次配置 OpenClaw、试验不同的代理提示或测试新工作流时,没有理由在 Claude Opus 或 GPT-5.2 上消耗昂贵的 token。从免费模型开始,调整好工作流,然后只在确认免费模型确实是瓶颈时才升级到付费模型。许多用户发现,配置得当的代理搭配 7B 参数模型能够令人满意地处理 60-70% 的日常任务——他们只在剩余需要更强推理能力或更大上下文窗口的复杂交互中才需要云端模型。

成本优化与多模型路由

使用云端模型运行 OpenClaw 的费用可能迅速攀升。一个活跃的代理会话根据任务复杂度和代理需要维护的上下文量,每小时可能消耗 50 万到 200 万个 token。以 Claude Sonnet 4.5 的费率(每百万输入/输出 token $3/$15)计算,繁忙的一天使用费用很容易达到 $20-50。多模型路由是降低这些成本的最有效策略,正确配置的用户报告了 50-80% 的实际节省(velvetshark.com,2026 年 2 月)。

多模型路由背后的核心思想很简单:并非与代理的每次交互都需要最昂贵的模型。当 OpenClaw 提出一个澄清问题、生成一个简单文件或执行一个常规命令时,每百万 token $0.40 的 Xiaomi MiMo-V2-Flash 与每百万输出 token $75 的 Claude Opus 表现一样好。通过将简单任务路由到便宜模型、将昂贵模型保留给复杂推理,你可以在不显著影响质量的情况下大幅降低每次交互的平均成本。

OpenClaw 通过 agents.defaults.model.fallbacks 中的回退链配置来支持这一功能。主模型首先处理每个请求,如果失败、遇到速率限制或不可用,代理会自动回退到链中的下一个模型。你可以将此构建为成本优化策略,让最便宜但够用的模型作为主模型,最强大的模型作为备选:

yaml# Cost-optimized configuration example agents: defaults: model: primary: "openrouter/deepseek/deepseek-v3.2" # \$0.53/M - daily driver fallbacks: - "openrouter/anthropic/claude-sonnet-4.5" # \$3/\$15/M - complex tasks - "ollama/qwen2.5-coder:7b" # \$0 - offline fallback

这个配置意味着你的代理在大多数交互中使用 DeepSeek V3.2,每百万 token 仅 $0.53。当任务需要更强的推理能力时,你通过 OpenClaw 界面中的 /model 命令手动切换到 Claude Sonnet。如果两个云端服务商都宕机了,代理会回退到你的本地 Ollama 模型——确保它永远不会完全停止工作。

对于更精细的成本控制,你可以通过 http://127.0.0.1:18789/ 的 OpenClaw 仪表板跟踪 token 使用量,并通过服务商的计费仪表板设置消费提醒。OpenRouter 在这方面特别有用,因为它提供跨所有模型的统一计费,让你清楚地看到钱花在了哪里。关于管理 API 支出的全面策略,我们的token 管理与成本优化策略指南深入介绍了预算规划、使用模式和警报配置。

laozhang.ai 等 API 聚合服务通过单一端点提供多个模型服务商的访问,定价具有竞争力,可以进一步简化你的成本管理。你可以在 docs.laozhang.ai 查看其 API 文档了解集成详情。

回退链同时也是一种可靠性机制。如果 Anthropic 出现服务中断,你的代理会自动切换到下一个可用模型,而不是完全停止工作。对于依赖 OpenClaw 进行生产工作流的团队,强烈建议在回退链中至少配置两个服务商——几分钟的配置时间在关键任务中某个服务商宕机时就能回本。

为了用具体数字说明节省效果,考虑一个典型开发者每天使用 OpenClaw 进行 4 小时的活跃编程。如果 Claude Sonnet 4.5 是唯一模型,那大约是每天 200-400 万个 token,混合平均成本约 $9/M token,每天花费 $18-36 或每月 $400-800。使用多模型路由——70% 的交互使用 DeepSeek V3.2($0.53/M),剩余 30% 使用 Claude Sonnet——同样的使用模式降至每天约 $5-12 或每月 $100-260。这是 55-67% 的成本降低,对输出质量的影响很小,因为大多数代理交互(文件读取、简单编辑、命令执行、状态检查)并不需要高端模型的推理能力。

OpenClaw LLM 常见问题排查

每个 OpenClaw 用户在配置过程中都会遇到这些错误中的至少一个。这种挫败感是真实的——你花了时间配置一切,然后一个晦涩的错误消息挡住了去路。本节涵盖十个最常见的 LLM 相关错误,包含它们的确切错误信息和经过验证的解决方案,让你能在几分钟而不是几小时内恢复正常工作。

错误 1:"Connection refused"(连接被拒绝)使用 Ollama 时。 这意味着 OpenClaw 无法连接到 http://127.0.0.1:11434 上的 Ollama 服务器。修复方法几乎总是因为 Ollama 服务器未运行。在 macOS 上,打开 Ollama 桌面应用。在 Linux 上,在单独的终端中运行 ollama serve。用 curl http://127.0.0.1:11434/api/tags 验证服务器是否可访问——如果你得到一个列出模型的 JSON 响应,说明服务器正在运行,问题可能是防火墙或代理配置阻止了 localhost 连接。

bash# Check if Ollama is running curl http://127.0.0.1:11434/api/tags # Start Ollama server (Linux) ollama serve # If using a custom port, update OpenClaw config export OLLAMA_BASE_URL="http://127.0.0.1:YOUR_PORT"

错误 2:"Model not allowed"(模型不允许)或"Model not found"(未找到模型)。 当你请求的模型在服务商上不存在或你的 API 层级不可用时会出现此错误。对于 Ollama,这意味着你还没有拉取该模型——运行 ollama pull MODEL_NAME。对于云端服务商,仔细检查模型标识符:OpenClaw 使用 provider/model-name 格式,任何一部分的拼写错误都会触发此错误。使用 openclaw models list 查看所有已配置服务商的可用模型。

错误 3:"Invalid API key"(无效 API 密钥)或认证失败。 API 密钥缺失、格式不正确或已过期。Anthropic 的密钥以 sk-ant- 开头,OpenAI 的密钥以 sk-proj-(新格式)或 sk-(旧格式)开头,OpenRouter 的密钥以 sk-or- 开头。检查你是否设置了正确的环境变量(ANTHROPIC_API_KEY、OPENAI_API_KEY 或 OPENROUTER_API_KEY),并确保密钥中没有尾随空格或换行符。一个常见错误是从密码管理器中复制密钥时带入了不可见字符。

错误 4:"Rate limit exceeded"(超出速率限制)(HTTP 429)。 你发送请求的速度太快了。这在具有较低速率限制的免费层 API 账户中特别常见。临时修复方法是等待 30-60 秒后重试。长期解决方案是配置带有回退的多模型路由,这样当一个服务商对你进行速率限制时,代理会自动切换到另一个。对于持续的速率限制问题,我们的速率限制超出错误详细指南涵盖了各服务商的具体限制和缓解策略。

错误 5:"Out of memory"(内存不足)运行本地模型时。 你试图运行的模型超出了可用内存。修复方法很简单:切换到更小的模型。如果你有 16GB 内存却拉取了 30B 参数的模型,切换到 7B 版本。使用 ollama list 查看已安装的模型,参考上方 Ollama 配置部分的硬件-模型对照表来找到适合你机器的模型。

错误 6:"Tool calling not supported"(不支持工具调用)或代理无法执行命令。 一些模型——特别是较小的开源模型——不支持函数调用,而 OpenClaw 的代理动作(如文件编辑和命令执行)依赖这一功能。修复方法是切换到支持工具调用的模型。云端方面,Claude Sonnet 4.5、GPT-5.2 和 Gemini 3 Pro 都具有稳健的工具调用支持。本地模型方面,Qwen2.5-Coder 和 DeepSeek-Coder-V2 包含工具调用能力。

错误 7:"Invalid beta flag"(无效 beta 标志)错误。 这是一个版本相关的问题,当 OpenClaw 发送服务商无法识别的 API 头信息时会出现。最常见的原因是运行了过时版本的 OpenClaw。使用 npm install -g openclaw@latest(需要 Node.js v24+)更新到最新版本。关于这个特定错误的详细说明,请参阅我们的 invalid beta flag 错误修复指南。

错误 8:上下文窗口超限。 长对话或大文件可能使总 token 数超过模型的上下文窗口。症状包括截断的响应或关于最大上下文长度的错误。使用 /clear 开始新对话,或切换到具有更大上下文窗口的模型。Claude Sonnet 4.5 支持 200K token,对大多数代理工作流来说已经足够。

错误 9:本地模型响应速度慢。 如果本地模型能响应但每次需要 30 秒以上,你可能运行了对你硬件来说过大的模型。用 ollama ps 检查当前模型内存使用情况,并参考硬件对照表来选择合适的模型。同时确保使用 OpenClaw 搭配本地模型时没有其他占用大量内存的应用在运行。

错误 10:配置后 OpenClaw 未识别服务商。 运行 openclaw onboard 后,代理仍然默认使用错误的服务商。使用 openclaw models status 检查当前配置,使用 openclaw models set PROVIDER/MODEL 明确设置你需要的模型。在活跃的 OpenClaw 会话中使用 /model 命令也可以即时切换模型而无需重启。

配置完成后的下一步——提升生产力

LLM 服务商配置并验证完成后,你就可以开始将 OpenClaw 作为真正的生产力工具来使用,而不仅仅是一个实验玩具。那些从 OpenClaw 中获得真正价值的用户和那些一周后就放弃的用户之间的区别,通常归结为你现在就应该养成的三个习惯——趁配置还新鲜的时候。

首先,用一个真实任务来测试你的配置,而不是"hello world"提示。让 OpenClaw 分析你当前项目中的一个文件、重构一个函数或为现有代码编写测试。这能立即验证工具调用是否正常工作、模型是否有足够的能力胜任你的工作、响应时间是否可接受。如果任何方面感觉不对——响应太慢、代码不完整或工具调用失败——重新审视服务商选择部分,考虑是否有更合适的模型。

其次,即使你对主模型很满意,也要配置回退链。服务商中断会发生,关键时刻会遇到速率限制,拥有备选意味着你的工作流永远不会完全中断。至少添加一个云端替代方案和一个本地模型到你的回退配置中。你现在花的五分钟将在不可避免的服务商宕机时为你节省数小时的挫败。

最后,如果你使用的是云端模型,建立成本监控习惯。每周检查你的 API 使用仪表板,在你能接受的阈值处设置计费警报,跟踪你的实际支出是否符合预算预期。如果成本高于预期,上一节的多模型路由策略是你最有效的杠杆——将日常任务路由到更便宜的模型,将高端模型保留给真正需要更强推理能力的复杂工作。

OpenClaw 是一个回报配置投入的工具。获得最大价值的用户是那些将初始配置不视为一次性任务,而是视为不断演进的工作流基础的人。随着你的需求变化和新模型的发布,你的模型选择、回退链和成本策略也会改变。openclaw onboard 向导和 /model 命令让你能轻松适应——关键是保持迭代,而不是满足于一个"够用"的配置。

OpenClaw 生态系统正在快速发展。新的模型服务商定期增加,随着竞争加剧价格不断变化,本地模型能力也在每一代中提升。收藏本指南,每当你考虑更改配置时重新审视服务商决策框架。核心原则——将模型能力匹配到任务复杂度、配置回退以确保可靠性、主动监控成本——即使具体的模型推荐不断演变,这些原则也始终不变。你最初五分钟的配置只是一个开始,随着数周和数月的日常使用,你的工作流将会越来越强大。

常见问题解答

OpenClaw 能同时使用多个 LLM 服务商吗?

可以。OpenClaw 的 agents.defaults.model.fallbacks 回退链配置支持多个服务商。主模型优先处理请求,如果失败或被速率限制,代理会自动尝试链中的下一个模型。你也可以在会话中使用 /model 命令切换服务商。许多用户将本地 Ollama 模型配置为最终回退,确保即使所有云端服务商都不可达时代理仍能工作。

运行 OpenClaw 搭配本地 LLM 的最低硬件要求是什么?

最低要求是 8GB 内存,可以在可用速度下运行 3B 参数模型。要获得本地模型的高效使用体验,16GB 内存运行 7B 参数模型如 Qwen2.5-Coder 是实际的起点。你还需要 Node.js v24 或更高版本以及足够的磁盘空间来存储模型文件(通常每个模型 4-8GB)。配备统一内存的 Apple Silicon Mac 提供了性价比最高的本地推理性能。

如何在不重启 OpenClaw 的情况下切换模型?

在活跃的 OpenClaw 会话中使用 /model 命令。输入 /model 加上服务商和模型名称(例如 /model anthropic/claude-sonnet-4.5),下次交互即刻生效。你也可以在终端中使用 openclaw models set 来更改所有未来会话的默认模型。使用 openclaw models list 查看所有已配置服务商的可用模型。

使用云端 LLM 服务商时我的数据安全吗?

使用云端服务商(OpenAI、Anthropic、OpenRouter)时,你的提示和代码上下文会被发送到服务商的服务器进行处理。每个服务商都有自己的数据保留和隐私政策。如果数据隐私是硬性要求,请使用 Ollama——所有推理在本地进行,没有数据离开你的机器。折中方案是,通过多模型路由系统配置本地模型处理敏感任务、云端模型处理非敏感工作。

使用云端模型运行 OpenClaw 的费用是多少?

费用根据使用强度和模型选择差异很大。使用 Claude Sonnet 4.5 的轻度使用(每天几次交互)每月花费 $5-15。重度使用(持续代理会话)使用高端模型每天可达 $20-50。通过 OpenRouter 使用经济模型(DeepSeek V3.2 每百万 token $0.53,MiMo-V2-Flash 每百万 token $0.40)与高端模型相比可降低 80-90% 的成本。配置成本优化回退链的多模型路由是在保持质量的同时控制支出的最有效方式。