当你使用 AWS Bedrock 或 Google Vertex AI 作为 Claude 提供商时,OpenClaw 的 "invalid beta flag" 错误会让你的 AI 助手完全停止工作。修复方法很简单:在 ~/.openclaw/openclaw.json 配置文件中设置 "beta_features": []。这会禁用 SDK 自动注入的 beta 头,而这些头是托管服务不支持的。对于大多数用户来说,这一个修改就能立即解决问题——但如果你需要 beta 功能或有特殊需求,本指南详细介绍了全部 5 种解决方案。

要点速览

在深入细节之前,先了解关键信息:"invalid beta flag" 错误发生是因为 Anthropic SDK 自动附加了 AWS Bedrock 和 Google Vertex AI 会拒绝的 beta 头。最快的修复方法是在 OpenClaw 配置中添加 "beta_features": []。如果你需要 computer-use 或扩展上下文等 beta 功能,则需要切换到直接 Anthropic API 访问。对于寻求成本节约或稳定中国访问的用户,laozhang.ai 等 OpenAI 兼容代理提供了一条完全绕过此问题的替代路径。

识别 Invalid Beta Flag 错误

"invalid beta flag" 错误根据你的设置以不同方式表现,但核心症状是明确的。你的 OpenClaw AI 助手完全无响应——通过 WhatsApp、Telegram 或其他连接平台发送的消息返回空白或显示 "(no output)" 响应。网关日志揭示了根本原因,错误消息直接指向 beta flag 问题。

通过 openclaw logs --follow 检查日志时,你会遇到以下错误模式之一。AWS Bedrock 用户通常在响应体中看到 "ValidationException: invalid beta flag"。Google Vertex AI 用户遇到 "400 Bad Request: invalid beta flag",症状类似。JSON 格式的错误响应如下:

json{ "type": "error", "error": { "type": "invalid_request_error", "message": "invalid beta flag" } }

此错误专门影响将 AWS Bedrock 或 Google Vertex AI 配置为 Claude 模型提供商的用户。如果你使用直接 Anthropic API 访问,不会遇到此问题——这些端点完全支持所有 beta 功能。问题专门出现在 OpenClaw 和这些托管云服务之间的转换层。

要确认你处理的是这个特定错误而不是一般配置问题,首先运行 openclaw doctor。这个诊断命令验证你的整体设置,可以区分身份验证问题、网络问题和 beta flag 错误。如果 doctor 报告健康状态但 Claude 相关请求仍然失败,你几乎肯定面临 beta flag 不兼容问题。

快速修复(从这里开始)

解决此错误最快的方法是修改 OpenClaw 配置以禁用 beta 功能。这种方法对大约 80% 的用户有效,因为大多数部署实际上不需要触发错误的实验性功能。打开 ~/.openclaw/openclaw.json 配置文件,在 agents defaults 下添加 beta_features 设置。

以下是你需要做的确切配置更改:

json{ "agents": { "defaults": { "model": { "primary": "anthropic/claude-sonnet-4", "options": { "beta_features": [] } } } } }

保存文件后,重启 OpenClaw 网关以应用更改。openclaw restart 命令可以干净地处理这个操作。如果你将 OpenClaw 作为 systemd 服务或 Docker 容器运行,请使用适合你部署的重启机制。

要验证修复是否有效,通过你首选的渠道发送测试消息——WhatsApp、Telegram 或 Web 界面。你应该在几秒钟内收到 Claude 的正常响应。此外,在发送测试消息时使用 openclaw logs --follow 检查日志。你应该不再在输出中看到 "invalid beta flag" 错误。

如果快速修复没有解决你的问题,你有一个边缘情况需要以下部分介绍的替代解决方案之一。简单修复可能不起作用的常见原因包括:配置文件有语法错误、你有多个相互覆盖的配置源,或者你的特定部署使用不同的配置路径。运行 openclaw config --show 显示你的活动配置并帮助识别任何冲突。

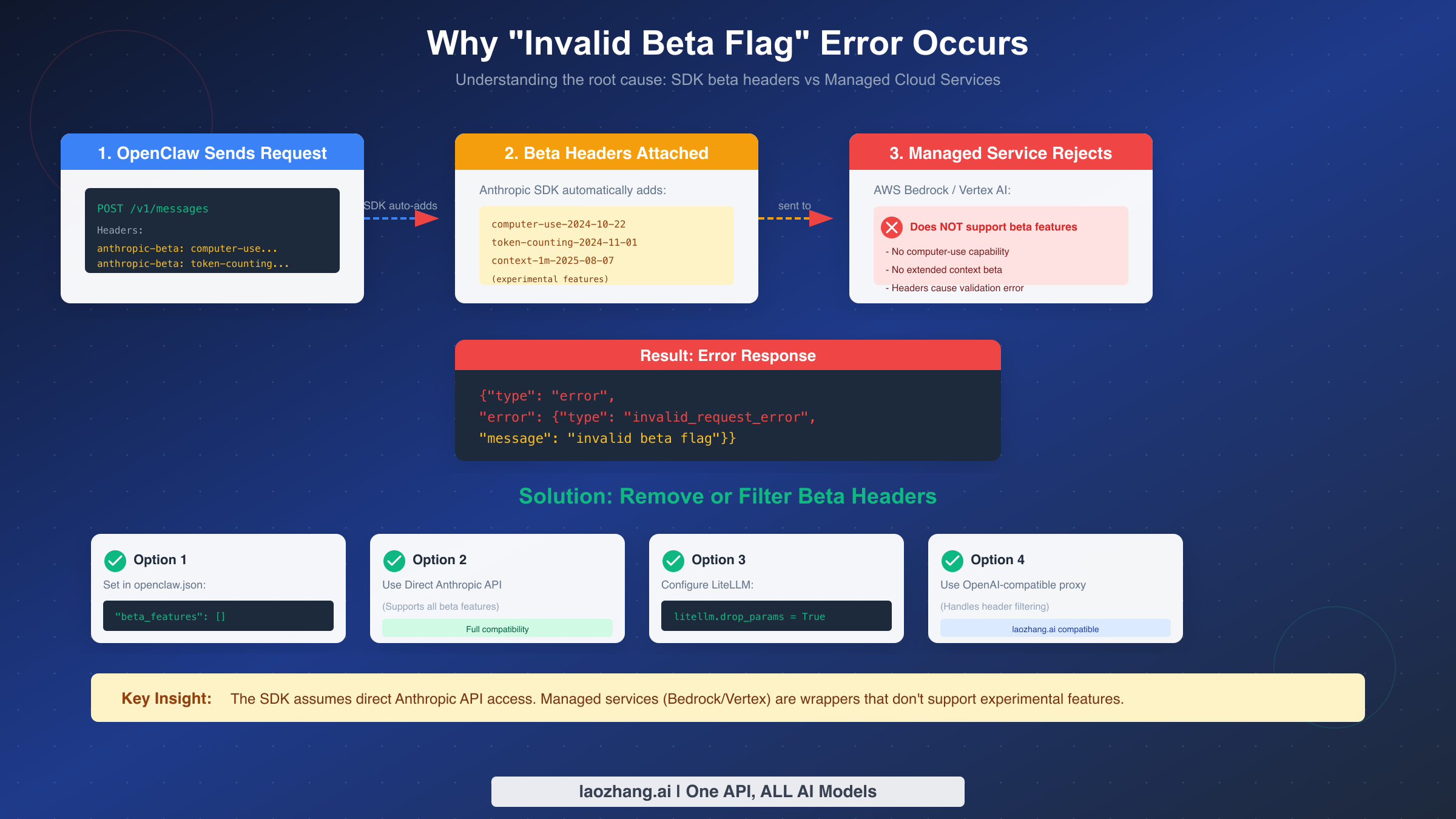

理解此错误发生的原因

此错误的根本原因在于 Anthropic SDK 期望的内容与托管云服务支持的内容之间的根本不匹配。当 OpenClaw 向 Claude 模型发送请求时,底层 SDK 自动附加 beta 头以启用实验性功能。这些头告诉 API 服务器客户端想要使用哪些预览功能。

SDK 默认注入几个 beta 头,包括用于自动浏览器控制的 computer-use-2024-10-22、用于精确使用跟踪的 token-counting-2024-11-01,以及用于扩展上下文窗口的 context-1m-2025-08-07。这些功能对高级用例很有价值,但需要直接 Anthropic API 基础设施才能运行。

AWS Bedrock 和 Google Vertex AI 作为底层 Claude 模型的托管包装器运行。它们提供企业级功能,如 IAM 集成、VPC 端点和合规认证,但通过标准化 API 表面来实现这一点。因此,这些服务会剥离或拒绝任何它们不明确支持的头——包括 Anthropic 的 beta 功能标志。

当 Bedrock 或 Vertex AI 代理收到包含这些不支持的 beta 头的请求时,它没有机制优雅地处理它们。唯一的选择是完全拒绝请求并返回 "invalid beta flag" 验证错误。此错误消息来自云提供商的验证层,而不是 Claude 本身。

理解这种架构解释了为什么修复有效:通过显式将 beta_features 设置为空数组,你告诉 SDK 首先不要附加任何 beta 头。请求干净地通过,因为没有什么可以让托管服务拒绝。然而,这也意味着你失去了对这些实验性功能的访问——这对某些用例来说是一个权衡。

OpenClaw 用于提供商抽象的 LiteLLM 库有配置选项可以在代理级别过滤头,这为想要头过滤但不直接修改 OpenClaw 配置的用户提供了替代解决方案。这种方法在 LiteLLM 用户的解决方案部分中介绍。

全部 5 种解决方案详解

每种解决方案从不同角度解决 beta flag 错误。你的选择取决于你的具体需求、部署约束以及是否需要访问 beta 功能。

解决方案 1:在 OpenClaw 配置中禁用 Beta 功能

这是大多数用户的推荐方法。编辑 ~/.openclaw/openclaw.json 并添加如前所示的 beta_features 配置。关键是确保设置出现在配置结构中的正确位置。如果你使用自定义配置路径,请相应调整。

验证时,发送测试请求并检查日志:

bashopenclaw logs --follow

查找没有 "invalid beta flag" 错误的成功完成。响应应该显示正常的 Claude 输出。

解决方案 2:使用直接 Anthropic API

如果你需要 computer-use 用于浏览器自动化或扩展上下文窗口等 beta 功能,直接 API 访问是你唯一的选择。将 OpenClaw 提供商配置切换为直接使用 Anthropic:

bashexport ANTHROPIC_API_KEY="your-anthropic-api-key"

然后更新你的 models 配置以使用 anthropic 提供商:

json{ "models": { "providers": { "anthropic": { "baseUrl": "https://api.anthropic.com", "auth": "api-key" } } } }

这种方法让你完全访问所有 Claude 功能,包括 beta 功能。权衡是失去 Bedrock 和 Vertex AI 提供的企业功能,如 AWS IAM 身份验证、VPC 端点和这些平台特定的合规认证。

解决方案 3:配置 LiteLLM 头过滤

如果你使用 LiteLLM 作为代理层(在复杂部署中很常见),你可以配置它在头到达云提供商之前过滤掉有问题的头。在 LiteLLM 配置中添加这些设置:

pythonimport litellm litellm.drop_params = True litellm.modify_params = True

对于基于配置文件的设置,添加等效的 YAML:

yamllitellm_settings: drop_params: true

这种方法保持现有的提供商配置不变,同时在代理级别解决 beta 头问题。它对于多个应用程序共享公共 LiteLLM 代理的部署特别有用。

解决方案 4:禁用提示缓存

在某些情况下,beta flag 错误专门由提示缓存功能触发。如果你已经尝试了解决方案 1 但仍然遇到问题,尝试显式禁用缓存:

json{ "agents": { "defaults": { "model": { "cache": { "enabled": false } } } } }

这是一个更有针对性的修复,保留其他模型选项的同时解决特定的缓存相关 beta 头。然而,禁用缓存可能会影响重复工作负载的性能,在这些情况下缓存响应提供延迟优势。

解决方案 5:切换到 OpenAI 兼容代理

对于想要完全避免提供商特定问题的用户,OpenAI 兼容代理服务提供了替代路径。这些服务处理 OpenAI API 格式和 Claude 原生 API 之间的转换,在过程中过滤掉不兼容的头。

配置 OpenClaw 使用 OpenAI 兼容端点:

json{ "models": { "providers": [ { "name": "proxy", "type": "openai", "baseURL": "https://api.laozhang.ai/v1", "models": ["claude-sonnet-4", "claude-opus-4-5"] } ] } }

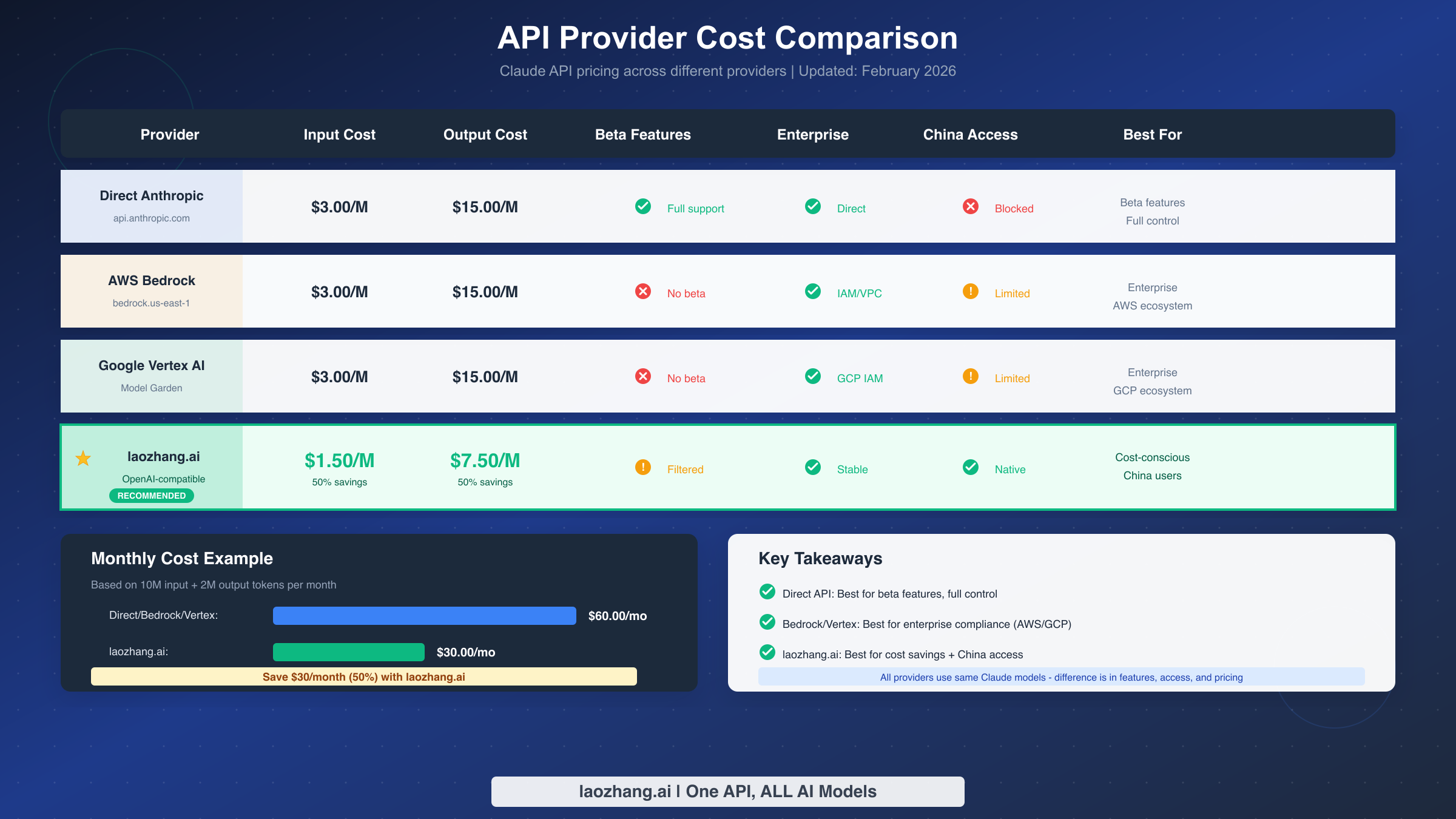

这种方法提供稳定的访问,无需担心 beta 头兼容性。laozhang.ai 等服务还为直接 Anthropic API 访问可能不可靠的地区的用户提供成本优势和可靠访问。

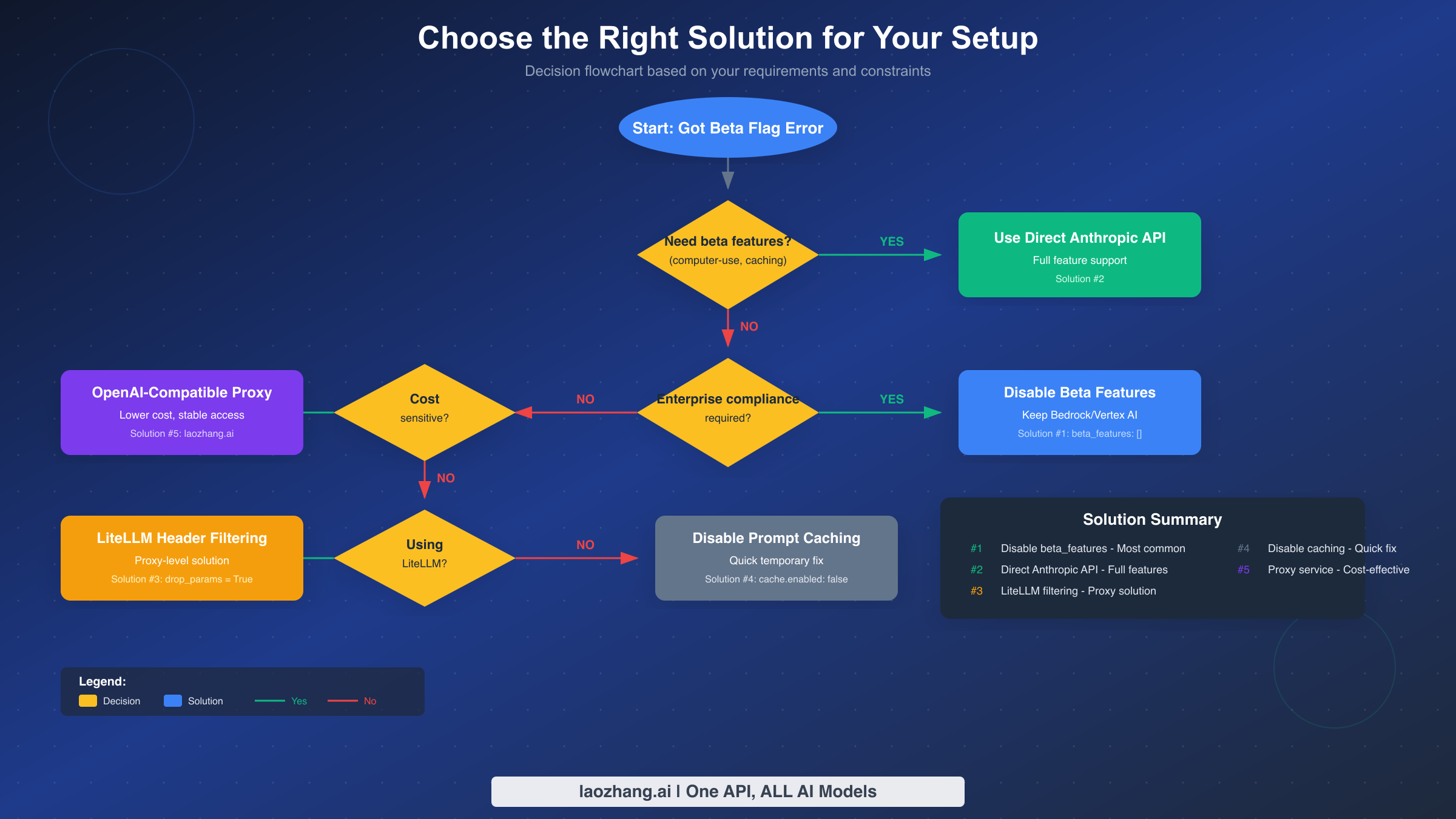

选择正确的解决方案

选择适当的解决方案取决于回答关于你需求的几个关键问题。上面的决策流程图提供了可视化指南,但这里是详细的逻辑。

你需要 beta 功能吗? 如果是,解决方案 2(直接 Anthropic API)是你唯一的选择。computer-use、令牌计数和扩展上下文等 beta 功能是直接 API 访问独有的。如果你不需要这些功能——大多数 OpenClaw 部署不需要——任何其他解决方案都可以。

需要企业合规吗? 如果你专门为了合规、数据驻留或 IAM 集成选择了 AWS Bedrock 或 Google Vertex AI,请坚持使用这些提供商并使用解决方案 1 或解决方案 3。这些解决方案在修复兼容性问题的同时保留你的企业设置。

你对成本敏感吗? 如果降低 API 成本比使用特定提供商更重要,带代理服务的解决方案 5 提供显著节省。下面的成本比较显示了跨提供商的差异。

你在使用 LiteLLM 吗? 如果你的部署已经包含 LiteLLM 作为代理层,解决方案 3 提供最干净的集成。你可以在代理级别解决问题而无需修改 OpenClaw 配置。

需要中国访问吗? 对于中国或对直接 Anthropic 或云提供商端点有连接问题的地区的用户,带 laozhang.ai 等代理服务的解决方案 5 提供更可靠的访问。这些服务通常具有针对区域连接优化的基础设施。

对于大多数用户,建议很简单:从解决方案 1(禁用 beta_features)开始。这是最简单的修复,适用于绝大多数部署。只有在你有解决方案 1 无法解决的特定需求时才探索替代方案。

企业部署考虑

企业部署通常有个人用户没有的约束。合规要求、数据驻留法规和安全策略可能决定哪些解决方案是可接受的。了解这些因素有助于你为你的组织做出正确选择。

AWS Bedrock 提供了几个对受监管行业重要的企业功能。IAM 集成提供细粒度访问控制。VPC 端点将流量保持在你的 AWS 网络内。CloudTrail 日志记录为合规创建审计跟踪。如果你专门为这些功能选择了 Bedrock,解决方案 1(禁用 beta 功能)在修复错误的同时保留你的安全态势。

Google Vertex AI 在 GCP 生态系统内提供类似的企业功能。数据驻留选项、VPC 服务控制以及与 Google Cloud IAM 系统的集成使其对已经投资 GCP 的组织具有吸引力。同样,解决方案 1 在这里工作而不会损害你的企业配置。

对于由于集中式 IT 策略而无法修改云提供商设置的组织,解决方案 3(LiteLLM 过滤)可能更合适。这种方法在代理层解决问题,而不触及你的 IT 团队管理的提供商特定配置。

数据驻留值得特别关注。如果法规要求你的 AI 处理在特定地理区域内进行,Bedrock 和 Vertex AI 都支持区域部署。直接 Anthropic API 可能不符合这些要求,具体取决于你的管辖范围。代理服务的数据处理实践各不相同——在受监管环境中使用它们之前,请查看其文档和合规认证。

在比较适合你用例的 Claude 模型时,考虑企业部署通常受益于托管服务的一致性,即使有 beta 功能的权衡。可靠性、合规认证以及与现有基础设施的集成通常超过实验性功能的损失。

预防:从一开始正确设置 OpenClaw

从一开始避免 beta flag 错误可以节省故障排除时间。在使用 AWS Bedrock 或 Google Vertex AI 设置 OpenClaw 时,遵循这些最佳实践以在问题发生之前预防它。

步骤 1:有目的地规划你的提供商选择。 在安装之前,决定你是否需要企业功能(Bedrock/Vertex)还是 beta 功能(直接 API)。你不能同时拥有两者。如果不确定,从直接 API 访问开始——以后迁移到托管服务比失去你依赖的功能更容易。

步骤 2:主动配置 beta_features。 创建初始 openclaw.json 时,从一开始就包含 beta_features 设置:

json{ "agents": { "defaults": { "model": { "primary": "anthropic/claude-sonnet-4", "options": { "beta_features": [] } } } } }

这可以防止错误出现,即使未来的 OpenClaw 更新改变默认行为。

步骤 3:上线前验证。 配置后,运行 openclaw doctor 检查你的设置。通过每个连接的渠道发送测试消息以验证端到端功能。在测试期间检查日志以捕获任何静默失败。

步骤 4:记录你的配置。 记录你使用的提供商及原因。注明驱动决策的任何企业合规要求。此文档有助于未来团队成员在需要修改时理解约束。

步骤 5:关注提供商支持更新。 AWS 和 Google 偶尔会更新其 Claude 产品。监控发布说明以了解 beta 功能支持的公告。情况可能会改变,可能启用以前不可用的功能。

对于大规模部署 OpenClaw 的团队,考虑使用配置管理工具在实例间强制一致设置。Ansible playbooks、Terraform 模块或 Kubernetes ConfigMaps 可以确保新部署中始终存在 beta_features 设置。

故障排除技巧和常见问题

即使应用了正确的解决方案,边缘情况也可能使解决变得复杂。这些故障排除技巧解决了不遵循标准模式的常见场景。

问:我应用了修复但仍然看到错误。出了什么问题?

多个配置源可以相互覆盖。运行 openclaw config --show 查看你的活动配置。查找可能来自环境变量、命令行参数或其他配置文件的 beta_features 设置。OpenClaw 从多个源合并配置,错误的可能优先。

问:OpenClaw 更新后出现了错误。有什么变化吗?

更新偶尔会修改默认行为。检查新版本的发布说明。如果更新中默认启用了 beta 功能,你需要再次显式禁用它们。更新期间不会覆盖你的配置文件,但新默认值可能以不同方式合并。

问:我可以使用一些 beta 功能但不使用其他功能吗?

是的,beta_features 数组接受特定功能名称。你可以只列出你想要的功能,而不是空数组:

json{ "beta_features": ["token-counting-2024-11-01"] }

然而,每个功能必须被你的提供商支持。单独测试每个功能以找出哪些与 Bedrock 或 Vertex AI 兼容。

问:为什么我朋友的设置不需要这些更改就能工作?

他们可能使用直接 Anthropic API 或 OpenAI 兼容代理,这两者都没有这个限制。beta flag 错误特定于 AWS Bedrock 和 Google Vertex AI。不同的提供商有不同的兼容性特征。

问:这是 OpenClaw 或 SDK 的 bug 吗?

这是兼容性差距而不是 bug。Anthropic SDK 设计用于 beta 功能工作的直接 API 访问。托管服务故意限制功能以实现标准化。OpenClaw 处于中间位置,与你配置的任何提供商一起工作。"修复"实际上是这些组件之间的配置对齐。

问:这个问题会在未来版本中修复吗?

可能,但不能保证。底层约束是托管服务不支持 beta 功能。未来的 OpenClaw 版本可能会自动检测提供商类型并调整头行为,但这需要多方协调。目前,显式配置是可靠的方法。

问:如何知道我是否在不知情的情况下使用 beta 功能?

常见的 beta 功能包括提示缓存、computer-use 自动化、令牌计数 API 和扩展上下文窗口。如果你没有在 OpenClaw 技能或代理中显式使用这些功能,你可能不需要它们。默认的 OpenClaw 安装不需要任何 beta 功能即可实现基本功能。

对于持续存在的问题,GitHub Discussions 上的 OpenClaw 社区和项目的 FAQ 文档提供了额外资源。这个错误有良好的文档记录,社区成员经常分享不寻常配置的解决方案。

"invalid beta flag" 错误虽然令人沮丧,但一旦理解了根本原因,就有简单的解决方案。无论你禁用 beta 功能、切换提供商还是使用代理服务,通往正常工作的 OpenClaw 部署的路径是清晰的。选择符合你需求的解决方案,应用配置,你的 AI 助手将重新上线。

![解决 OpenClaw Invalid Beta Flag 错误:完整指南 [2026]](/posts/zh/openclaw-invalid-beta-flag/img/cover.png)