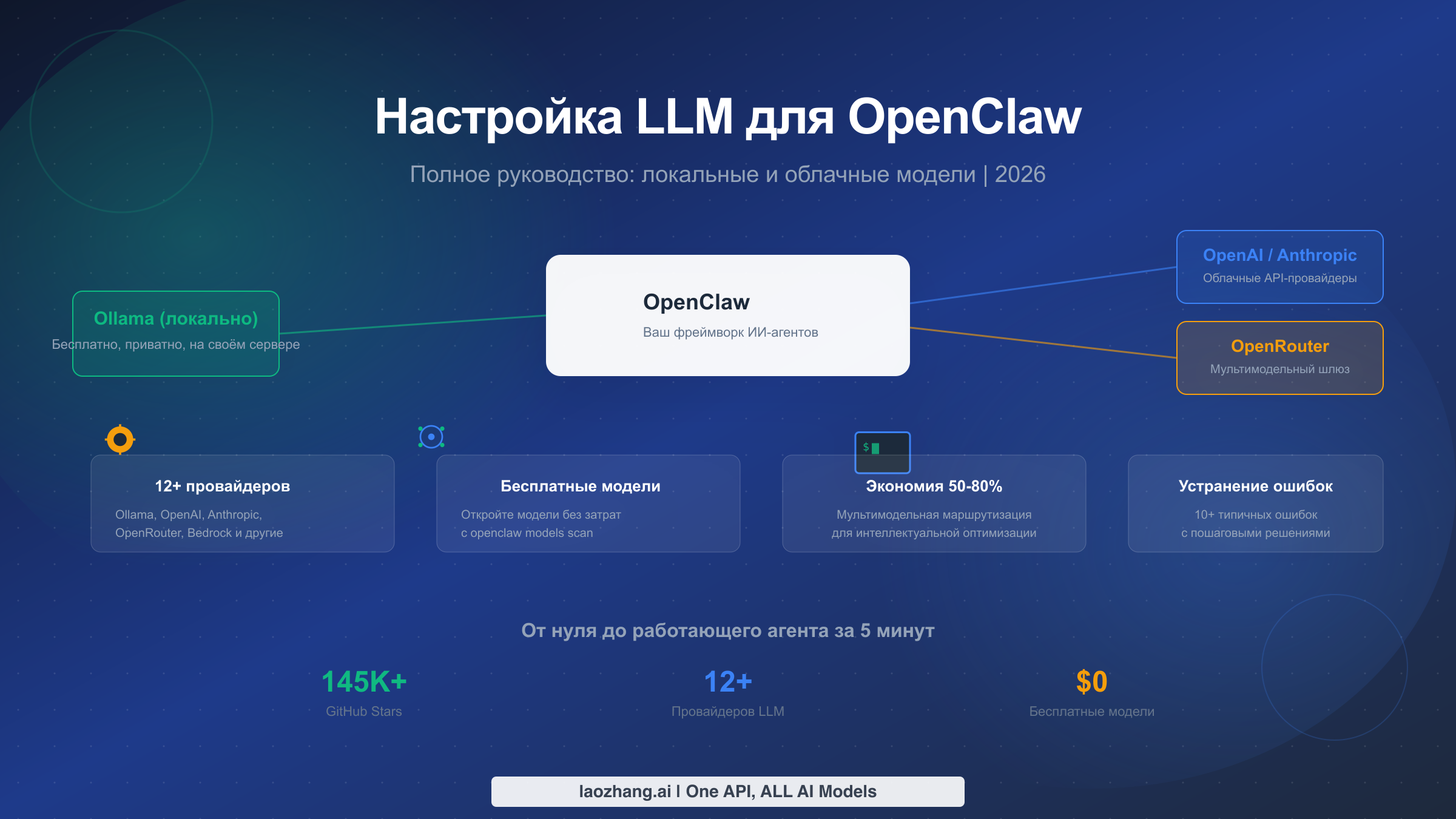

OpenClaw поддерживает более 12 провайдеров LLM, включая Ollama для локальной конфиденциальности, OpenAI и Anthropic для максимальной производительности, а также OpenRouter для мультимодельного доступа. Запустите openclaw onboard, чтобы открыть интерактивный мастер настройки, выберите провайдера — и ваш ИИ-агент будет готов к работе менее чем за пять минут. Это руководство охватывает все доступные варианты провайдеров, помогает подобрать модели под ваше оборудование и бюджет, раскрывает возможности полностью бесплатного использования OpenClaw, а также содержит пошаговые инструкции по устранению наиболее распространённых ошибок при настройке.

Что такое OpenClaw и почему выбор LLM имеет значение

OpenClaw — это фреймворк для ИИ-агентов с открытым исходным кодом, набравший более 145 000 звёзд на GitHub (по состоянию на февраль 2026 года), который превращает большие языковые модели в автономных ассистентов для написания кода, помощников по DevOps и универсальных агентов. Проект был создан Питером Штайнбергером и ранее был известен под названиями Moltbot и Clawdbot, а сейчас стал одним из наиболее активно поддерживаемых фреймворков для агентов в экосистеме. В отличие от простых чат-обёрток, OpenClaw предоставляет LLM возможность выполнять команды оболочки, редактировать файлы, просматривать веб-страницы и организовывать сложные многошаговые рабочие процессы — а это означает, что выбранная вами модель напрямую определяет, что сможет делать ваш агент и сколько это будет стоить.

Провайдер LLM, который вы настраиваете в процессе установки, — это не просто техническая галочка. Он определяет три аспекта, которые будут формировать ваш повседневный опыт работы с OpenClaw. Во-первых, он задаёт потолок интеллекта вашего агента: небольшая локальная модель вроде Qwen2.5 7B справляется с простым редактированием файлов, но будет испытывать трудности при многофайловом рефакторинге, с которым Claude Sonnet 4.5 или GPT-5.2 справляются без усилий. Во-вторых, он контролирует ваши операционные расходы: облачные API тарифицируются за токен, и активная сессия OpenClaw может потреблять миллионы токенов в день, если вы выполняете сложные агентные циклы. В-третьих, он определяет конфиденциальность данных: каждый промпт, отправленный облачному провайдеру, покидает вашу машину, что имеет значение при работе с проприетарным кодом или конфиденциальными конфигурациями.

В настоящее время OpenClaw поддерживает 12 официальных провайдеров: Ollama, OpenAI, Anthropic, OpenRouter, Amazon Bedrock, Vercel AI Gateway, Moonshot AI, MiniMax, OpenCode Zen, GLM Models, Z.AI и Synthetic. Каждый провайдер имеет свои преимущества. Модели GLM описаны в официальной документации как «немного лучше для кодирования и вызова инструментов», тогда как MiniMax отмечается как «лучше для написания текстов и создания атмосферы» (docs.openclaw.ai, февраль 2026). Такое разнообразие — безусловное преимущество, но оно также означает, что вам нужна чёткая система принятия решений перед запуском openclaw onboard. Оставшаяся часть руководства предоставляет именно такую систему, начиная с выбора подходящего провайдера, затем пошагового описания настройки каждого основного варианта, и заканчивая оптимизацией затрат и устранением неполадок.

Как выбрать подходящего провайдера LLM

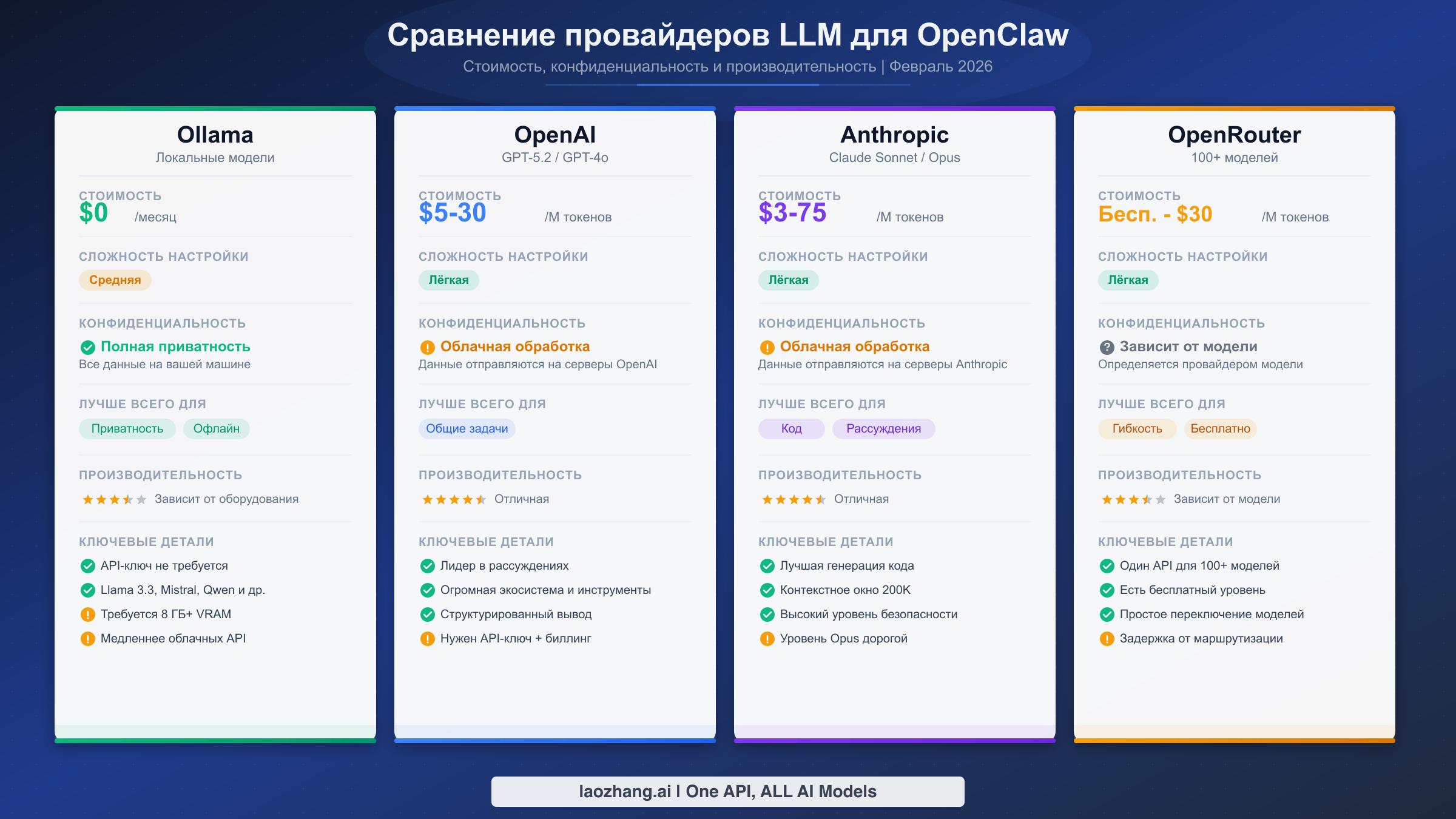

Выбор правильного провайдера LLM для OpenClaw зависит от четырёх факторов: вашего бюджета, оборудования, требований к конфиденциальности и сложности задач, которые вы планируете выполнять. Вместо того чтобы перечислять каждого провайдера и оставлять вас разбираться самостоятельно, этот раздел предлагает конкретный путь принятия решения, основанный на том, что для вас важнее всего. Блок-схема выше обобщает четыре основных пути, а таблица решений ниже сопоставляет типичные сценарии с конкретными рекомендациями.

| Приоритет | Рекомендуемый провайдер | Лучшая модель | Ежемесячная стоимость | Сложность настройки |

|---|---|---|---|---|

| Конфиденциальность + бесплатно | Ollama (локально) | Qwen2.5-Coder 7B | $0 | Средняя |

| Лучшая производительность | Anthropic | Claude Sonnet 4.5 | $50-200 | Лёгкая |

| Бюджетное облако | OpenRouter | DeepSeek V3.2 | $5-30 | Лёгкая |

| Максимальная гибкость | OpenRouter + Ollama | Смешанные | $10-50 | Средняя |

| Корпоративный | Amazon Bedrock | Claude через Bedrock | Варьируется | Сложная |

Если конфиденциальность — ваш главный приоритет, Ollama является единственным ответом. Каждый промпт остаётся на вашей машине, API-ключ не нужен, а стоимость равна нулю за исключением электроэнергии. Компромисс заключается в возможностях: локальные модели ограничены примерно 32 миллиардами параметров на большинстве потребительского оборудования, что означает хорошую работу с задачами на уровне одного файла, но трудности со сложными многошаговыми рассуждениями. Если у вас машина с 64 ГБ оперативной памяти или более, вы можете запускать модели с 30-32 миллиардами параметров, такие как DeepSeek-Coder-V2, со скоростью примерно 10-15 токенов в секунду на чипе Apple M4 (бенчмарк marc0.dev, январь 2026), что является реально конкурентоспособным показателем по сравнению с облачными моделями для многих задач программирования.

Если вам нужна наилучшая производительность агента, Claude Sonnet 4.5 от Anthropic по цене $3/$15 за миллион входных/выходных токенов (haimaker.ai, январь 2026) предлагает оптимальный баланс возможностей, надёжности вызова инструментов и стоимости. Для задач, требующих более глубоких рассуждений — архитектурные решения, сложная отладка, масштабный рефакторинг — Claude Opus 4.5 по цене $15/$75 за миллион токенов является премиальным уровнем. Вы можете ознакомиться с подробным сравнением Claude Opus и Sonnet, где разобрано, когда разница в цене оправдана. GPT-5.2 от OpenAI — достойная альтернатива в аналогичном ценовом диапазоне, особенно если вы уже работаете в экосистеме OpenAI.

Если вы хотите минимизировать расходы, но при этом использовать облачные модели, OpenRouter — лучшая отправная точка. Он выступает в роли шлюза к десяткам моделей разных провайдеров и предоставляет доступ к бесплатным моделям, которые можно использовать с нулевыми расходами. Модели вроде DeepSeek V3.2 по цене $0,53 за миллион токенов и Xiaomi MiMo-V2-Flash по цене $0,40 за миллион токенов (velvetshark.com, февраль 2026) обеспечивают удивительно высокую производительность программирования за малую долю стоимости премиальных моделей. OpenRouter также позволяет реализовать стратегию мультимодельной маршрутизации, рассмотренную в разделе оптимизации затрат ниже.

Если вам нужна максимальная гибкость, совместите Ollama для локальной конфиденциальности с OpenRouter для облачного резерва. Это даёт лучшее из обоих миров: конфиденциальные задачи выполняются локально, сложные задачи перенаправляются на более мощные облачные модели, а ваш агент продолжает работать даже при сбое одного из провайдеров. Конфигурация для этого подхода описана в разделе мультимодельной маршрутизации.

Настройка локальных моделей с помощью Ollama

Ollama — это самая популярная локальная среда выполнения LLM для OpenClaw, и на то есть веские причины: она бесплатна, хранит все данные на вашей машине и не требует API-ключей. Процесс настройки состоит из трёх этапов — установка Ollama, загрузка модели и подключение к OpenClaw. Весь процесс занимает менее десяти минут на современной машине с приличным интернет-подключением.

Установка Ollama проста на всех трёх основных платформах. На macOS можно загрузить установщик с ollama.com или использовать Homebrew. На Linux официальный установочный скрипт справляется со всем автоматически. На Windows Ollama теперь предоставляет нативный установщик.

bashbrew install ollama # Linux (official script) curl -fsSL https://ollama.com/install.sh | sh # Windows: download from ollama.com/download

После установки запустите сервер Ollama. На macOS и Windows десктопное приложение запускает его автоматически. На Linux может потребоваться запустить сервис вручную командой ollama serve. По умолчанию сервер слушает на http://127.0.0.1:11434 — это эндпоинт, к которому OpenClaw будет подключаться.

Выбор правильной модели полностью зависит от доступной оперативной памяти. Именно здесь большинство пользователей совершают первую ошибку: они пытаются загрузить модель с 70 миллиардами параметров на ноутбуке с 16 ГБ памяти и удивляются, почему всё зависает. Правило такое: вам нужно примерно 1 ГБ оперативной памяти на миллиард параметров для квантизированных моделей, плюс запас для операционной системы и самого OpenClaw.

| Доступная ОЗУ | Рекомендуемая модель | Параметры | Ожидаемая скорость | Применение |

|---|---|---|---|---|

| 8 ГБ | qwen2.5-coder:3b | 3B | 25-35 ток/с | Лёгкое редактирование, простые скрипты |

| 16 ГБ | qwen2.5-coder:7b | 7B | 15-20 ток/с | Работа с одним файлом, отладка |

| 32 ГБ | deepseek-coder-v2:16b | 16B | 12-18 ток/с | Многофайловые задачи, умеренные рассуждения |

| 64 ГБ+ | deepseek-coder-v2:33b | 33B | 10-15 ток/с | Сложный рефакторинг, архитектура |

Загрузите выбранную модель одной командой:

bash# For 16GB machines (most common) ollama pull qwen2.5-coder:7b # Verify the model is available ollama list

Подключение Ollama к OpenClaw происходит через мастер настройки. Запустите openclaw onboard и выберите Ollama в качестве провайдера. Мастер обнаружит модели, которые вы уже загрузили, и позволит выбрать нужную. Под капотом он записывает конфигурацию в файл настроек OpenClaw с ключом agents.defaults.model.primary.

bash# Start the setup wizard openclaw onboard # Or configure manually via CLI openclaw models set ollama/qwen2.5-coder:7b

Если вы предпочитаете настроить всё вручную, ключевая переменная окружения — OLLAMA_API_KEY. Несмотря на название, Ollama фактически не требует аутентификации — установите любую непустую строку вроде ollama-local, чтобы пройти валидацию OpenClaw:

bashexport OLLAMA_API_KEY="ollama-local"

Важная деталь из официальной документации: потоковая передача (streaming) для Ollama по умолчанию отключена в OpenClaw. Это означает, что вы увидите полный ответ сразу, а не токен за токеном. Для большинства агентных рабочих процессов это нормально, но если вы предпочитаете потоковый вывод, его можно включить в конфигурации провайдера.

Проверка настройки — критически важный шаг, который пропускают многие руководства. После подключения Ollama к OpenClaw отправьте простой тестовый промпт, чтобы убедиться, что всё работает от начала до конца. Если агент отвечает связным текстом и может выполнять базовые вызовы инструментов (например, вывести список файлов в директории), ваш локальный LLM настроен правильно и каждый токен обрабатывается на вашем собственном оборудовании. Если вы видите искажённый вывод или агент отказывается использовать инструменты, возможно, модель не обладает достаточной способностью вызова инструментов — в этом случае переключитесь на Qwen2.5-Coder или DeepSeek-Coder-V2, которые имеют самую сильную поддержку вызова инструментов среди локальных моделей по состоянию на февраль 2026 года.

Оптимизация производительности локальных моделей ощутимо влияет на повседневное использование. Если ответы кажутся медленными, проверьте, сколько моделей Ollama загружены в память с помощью ollama ps. Ollama хранит недавно использованные модели в памяти, и одновременная загрузка нескольких крупных моделей снижает производительность. Используйте ollama stop MODEL_NAME, чтобы выгрузить модели, которые вы не используете в данный момент. На компьютерах Mac с чипами Apple Silicon убедитесь, что Ollama использует GPU-ускорение — это происходит автоматически, но можно проверить в логах Ollama. Для пользователей Linux с GPU NVIDIA Ollama поддерживает ускорение через CUDA при установленных соответствующих драйверах, что может увеличить скорость инференса в 3-5 раз по сравнению с выполнением только на CPU.

Настройка облачных провайдеров LLM

Облачные провайдеры дают вашему агенту OpenClaw доступ к самым мощным из доступных моделей — ценой отправки ваших промптов через интернет и оплаты за каждый токен. Три наиболее часто используемых облачных провайдера — OpenAI, Anthropic и OpenRouter. Каждый требует API-ключ, и процесс настройки через openclaw onboard практически идентичен для всех трёх — основные различия заключаются в том, где вы получаете ключ и какие модели становятся доступны.

Настройка OpenAI требует API-ключа с platform.openai.com. Создайте учётную запись, перейдите в раздел API Keys и сгенерируйте новый ключ. Затем передайте его через мастер настройки или установите как переменную окружения:

bashexport OPENAI_API_KEY="sk-proj-..." # Run the setup wizard openclaw onboard # Select OpenAI → paste your key → choose a model

OpenAI даёт доступ к семейству моделей GPT. Для работы агента OpenClaw GPT-5.2 предлагает лучший баланс возможностей и стоимости. Ключевое преимущество OpenAI — его обширная экосистема: если у вас уже настроен биллинг и командный доступ к API, добавление OpenClaw не составит труда.

Настройка Anthropic следует тому же принципу. Получите API-ключ на console.anthropic.com, затем настройте его:

bashexport ANTHROPIC_API_KEY="sk-ant-..." openclaw onboard # Select Anthropic → paste your key → choose Claude Sonnet 4.5 or Opus 4.5

Модели Claude широко признаны как наиболее сильные для агентных задач программирования, особенно для вызова инструментов и многошаговых рабочих процессов. Claude Sonnet 4.5 по цене $3/$15 за миллион токенов является оптимальным выбором для повседневного использования, тогда как Opus 4.5 по цене $15/$75 за миллион токенов предназначен для самых требовательных задач. Если вы столкнулись с проблемами при настройке, наше руководство по ошибкам конфигурации API-ключа Anthropic охватывает наиболее распространённые подводные камни, включая проблемы с форматом ключа и региональные ограничения.

Настройка OpenRouter немного отличается, потому что OpenRouter сам по себе не является провайдером моделей — это шлюз, который маршрутизирует ваши запросы к моделям от десятков различных провайдеров. Это означает, что один API-ключ OpenRouter даёт доступ к Claude, GPT, Gemini, Llama, Mistral, DeepSeek и многим другим. Получите ключ на openrouter.ai/keys:

bashexport OPENROUTER_API_KEY="sk-or-..." openclaw onboard # Select OpenRouter → paste your key → browse available models

Уникальное преимущество OpenRouter — разнообразие моделей. Вы можете переключаться между провайдерами без изменения конфигурации OpenClaw — достаточно сменить название модели. Это также позволяет реализовать стратегию оптимизации затрат, описанную в следующих разделах, где простые задачи направляются на дешёвые модели, а сложные — на премиальные.

Если вам нужна единая точка доступа к API, которая маршрутизирует запросы к нескольким ИИ-моделям с упрощённым биллингом и надёжным аптаймом, платформы агрегации API, такие как laozhang.ai, предоставляют унифицированный доступ к OpenAI, Anthropic и другим провайдерам через один API-ключ. Это может упростить вашу настройку, когда вы хотите использовать несколько облачных провайдеров без необходимости управлять отдельными учётными записями и биллингом для каждого.

Использование бесплатных моделей с OpenClaw

Одна из наименее известных функций OpenClaw заключается в том, что его можно использовать с нулевыми затратами на API. Существуют два пути бесплатного использования: локальные модели через Ollama (которые мы рассмотрели выше) и бесплатные облачные модели через OpenRouter. Второй путь особенно интересен, потому что он даёт доступ к облачному инференсу без каких-либо затрат.

OpenClaw включает встроенный сканер моделей, который обнаруживает бесплатные модели, доступные на OpenRouter. Запуск openclaw models scan запрашивает API OpenRouter и возвращает список моделей с нулевой стоимостью — это модели, которые провайдеры предлагают бесплатно, обычно для привлечения пользователей или как вклад в сообщество. Доступность меняется со временем, но стабильно доступны 10-20 бесплатных моделей в любой момент времени.

bash# Discover free models openclaw models scan # Example output (availability varies): # ✓ meta-llama/llama-3.2-8b-instruct (free) # ✓ google/gemma-2-9b-it (free) # ✓ mistralai/mistral-7b-instruct (free) # ✓ qwen/qwen-2.5-7b-instruct (free)

Чтобы использовать бесплатную модель, выберите её во время openclaw onboard или установите напрямую:

bashopenclaw models set openrouter/meta-llama/llama-3.2-8b-instruct

Честный компромисс бесплатных моделей заключается в том, что они обычно меньше (7-9 миллиардов параметров) и могут иметь ограничения по частоте запросов или более высокую задержку по сравнению с платными моделями. Для изучения OpenClaw, экспериментов с рабочими процессами агента или решения простых задач — таких как организация файлов и базовая генерация кода — бесплатные модели действительно полезны. Для продуктивной помощи в программировании или сложных многошаговых задач вам рано или поздно захочется перейти на платную модель, но начало работы с бесплатными моделями означает, что вы можете освоить весь рабочий процесс OpenClaw без каких-либо финансовых обязательств.

Вы также можете комбинировать бесплатные и платные модели с помощью стратегии мультимодельной маршрутизации. Настройте бесплатную модель как основную для простых задач, а платную — как резервную для сложных. Таким образом, большинство ваших взаимодействий ничего не стоят, и вы платите только тогда, когда задача действительно требует более мощной модели. Конфигурация для этого подхода описана в следующем разделе.

Ещё один путь к бесплатному использованию OpenClaw — это бесплатные уровни самих провайдеров. OpenAI, Anthropic и Google предоставляют ограниченный бесплатный доступ к API для новых учётных записей. Эти бесплатные уровни обычно включают достаточно токенов для обширных экспериментов с OpenClaw перед переходом на платное использование. Уточните текущие условия бесплатного уровня каждого провайдера, поскольку они часто меняются.

Стратегический подход к бесплатным моделям — использовать их как среду обучения. Когда вы впервые настраиваете OpenClaw, экспериментируете с различными промптами для агента или тестируете новые рабочие процессы, нет причин тратить дорогие токены на Claude Opus или GPT-5.2. Начните с бесплатной модели, отладьте рабочий процесс, а затем переходите на платную модель только тогда, когда убедитесь, что именно бесплатная модель является узким местом. Многие пользователи обнаруживают, что хорошо настроенный агент с моделью на 7 миллиардов параметров приемлемо справляется с 60-70% их повседневных задач — облачные модели им нужны лишь для оставшихся сложных взаимодействий, требующих более сильных рассуждений или большего контекстного окна.

Оптимизация затрат и мультимодельная маршрутизация

Работа OpenClaw с облачными моделями может быстро стать дорогостоящей. Активная агентная сессия может потреблять от 500 000 до 2 000 000 токенов в час в зависимости от сложности задачи и объёма контекста, который необходимо поддерживать. При тарифах Claude Sonnet 4.5 в $3/$15 за миллион входных/выходных токенов интенсивный день использования может легко достигать $20-50. Мультимодельная маршрутизация — это единственная наиболее эффективная стратегия снижения этих затрат, с реальной экономией 50-80%, о которой сообщают пользователи, правильно её настроившие (velvetshark.com, февраль 2026).

Основная идея мультимодельной маршрутизации проста: не каждое взаимодействие с агентом требует самой дорогой модели. Когда OpenClaw задаёт уточняющий вопрос, генерирует простой файл или выполняет рутинную команду, модель за $0,40/M токенов вроде Xiaomi MiMo-V2-Flash работает так же хорошо, как Claude Opus за $75/M выходных токенов. Направляя простые задачи на дешёвые модели и резервируя дорогие модели для сложных рассуждений, вы радикально снижаете среднюю стоимость взаимодействия без существенного ущерба для качества.

OpenClaw поддерживает это через конфигурацию цепочки резервных моделей в agents.defaults.model.fallbacks. Основная модель обрабатывает каждый запрос первой, и если она терпит неудачу, достигает лимита запросов или недоступна, агент автоматически переключается на следующую модель в цепочке. Вы можете выстроить это как стратегию оптимизации затрат, сделав самую дешёвую подходящую модель основной, а самую мощную — резервной:

yaml# Cost-optimized configuration example agents: defaults: model: primary: "openrouter/deepseek/deepseek-v3.2" # \$0.53/M - daily driver fallbacks: - "openrouter/anthropic/claude-sonnet-4.5" # \$3/\$15/M - complex tasks - "ollama/qwen2.5-coder:7b" # \$0 - offline fallback

Эта конфигурация означает, что ваш агент использует DeepSeek V3.2 для большинства взаимодействий по цене $0,53 за миллион токенов. Когда задача требует более сильных рассуждений, вы вручную переключаетесь на Claude Sonnet с помощью команды /model в интерфейсе OpenClaw. А если оба облачных провайдера недоступны, агент переключается на вашу локальную модель Ollama — гарантируя, что работа не остановится полностью.

Для более точного контроля затрат вы можете отслеживать потребление токенов через панель управления OpenClaw по адресу http://127.0.0.1:18789/ и настроить оповещения о расходах через панель биллинга вашего провайдера. OpenRouter особенно полезен в этом отношении, поскольку предоставляет единый биллинг по всем моделям, что позволяет легко видеть, куда именно уходят деньги. Для комплексных стратегий управления расходами на API наше руководство по управлению токенами и стратегиям оптимизации затрат углубляется в бюджетирование, паттерны использования и настройку оповещений.

Некоторые сервисы агрегации API, такие как laozhang.ai, предлагают доступ к нескольким провайдерам моделей через единый эндпоинт с конкурентными ценами, что может ещё больше упростить управление затратами. Документацию по API можно найти на docs.laozhang.ai для подробностей интеграции.

Цепочка резервных моделей также служит механизмом обеспечения надёжности. Если у Anthropic произошёл сбой, ваш агент автоматически переключается на следующую доступную модель, вместо того чтобы полностью остановиться. Для команд, которые зависят от OpenClaw в продуктивных рабочих процессах, настройка как минимум двух провайдеров в цепочке резервных моделей настоятельно рекомендуется — несколько минут на настройку окупаются при первом же сбое провайдера во время критической задачи.

Чтобы представить экономию в конкретных цифрах, рассмотрим типичного разработчика, использующего OpenClaw 4 часа активного программирования в день. С Claude Sonnet 4.5 в качестве единственной модели это примерно 2-4 миллиона токенов в день при средней смешанной стоимости около $9/M токенов, что составляет $18-36 в день или $400-800 в месяц. С мультимодельной маршрутизацией — используя DeepSeek V3.2 по цене $0,53/M для 70% взаимодействий и Claude Sonnet для оставшихся 30% — тот же паттерн использования снижается примерно до $5-12 в день или $100-260 в месяц. Это снижение затрат на 55-67% с минимальным влиянием на качество, потому что большинство взаимодействий агента (чтение файлов, простое редактирование, выполнение команд, проверки статуса) не получают преимуществ от расширенных возможностей рассуждения премиальной модели.

Устранение распространённых ошибок OpenClaw LLM

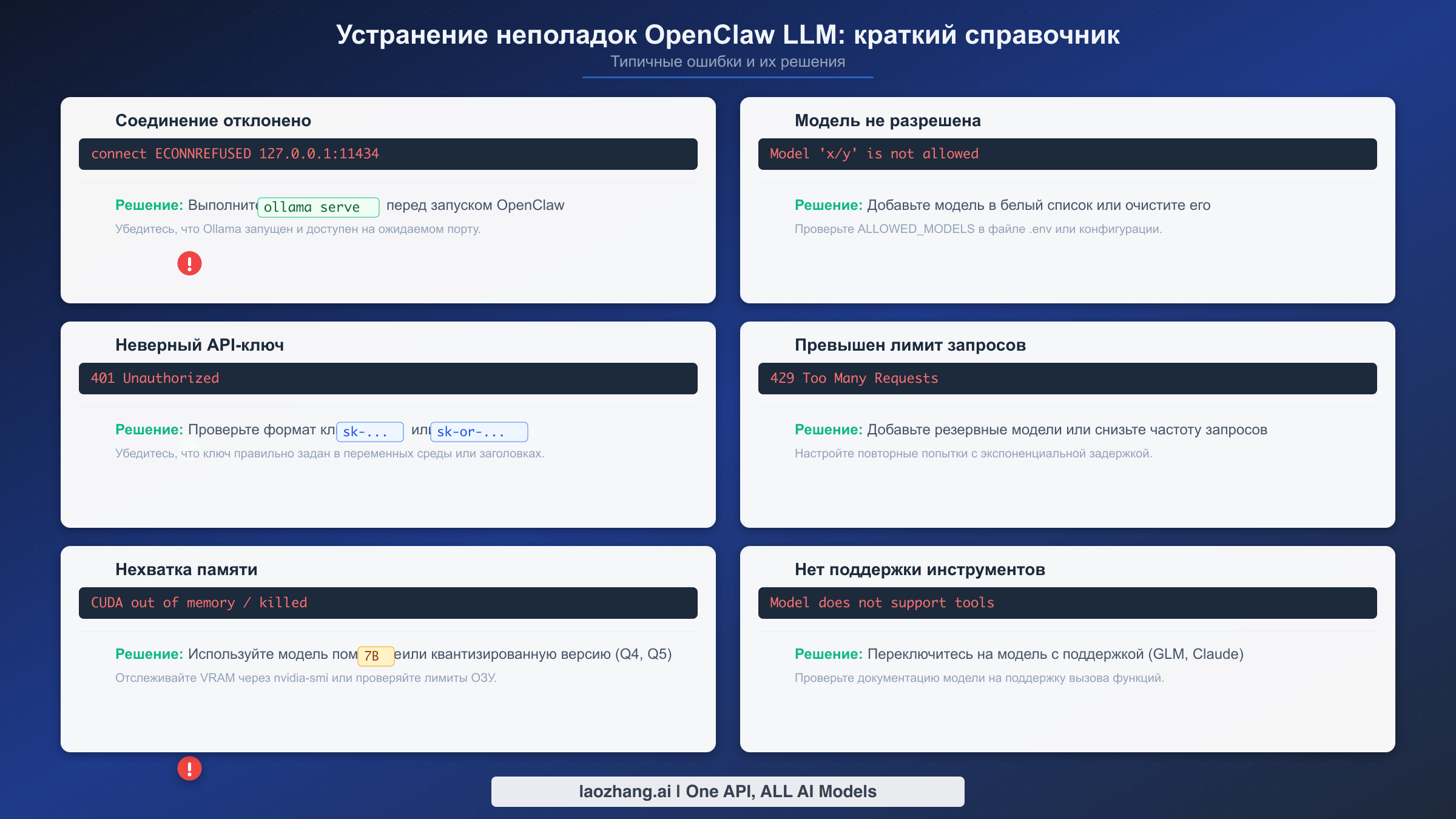

Каждый пользователь OpenClaw сталкивается хотя бы с одной из этих ошибок при настройке. Разочарование вполне реальное — вы потратили время на конфигурацию, и тут загадочное сообщение об ошибке блокирует дальнейшую работу. Этот раздел охватывает десять наиболее распространённых ошибок, связанных с LLM, с их точными сообщениями и проверенными решениями, чтобы вы могли вернуться к продуктивной работе за минуты, а не за часы.

Ошибка 1: «Connection refused» при использовании Ollama. Это означает, что OpenClaw не может достичь сервера Ollama по адресу http://127.0.0.1:11434. Исправление почти всегда заключается в том, что сервер Ollama не запущен. На macOS откройте десктопное приложение Ollama. На Linux выполните ollama serve в отдельном терминале. Проверьте доступность сервера командой curl http://127.0.0.1:11434/api/tags — если вы получаете JSON-ответ со списком моделей, сервер работает корректно, и проблема, вероятно, в конфигурации файрвола или прокси, блокирующей соединения через localhost.

bash# Check if Ollama is running curl http://127.0.0.1:11434/api/tags # Start Ollama server (Linux) ollama serve # If using a custom port, update OpenClaw config export OLLAMA_BASE_URL="http://127.0.0.1:YOUR_PORT"

Ошибка 2: «Model not allowed» или «Model not found». Это возникает, когда вы запрашиваете модель, которая либо не существует у вашего провайдера, либо недоступна для вашего уровня API. Для Ollama это означает, что вы ещё не загрузили модель — выполните ollama pull MODEL_NAME. Для облачных провайдеров дважды проверьте точный идентификатор модели: OpenClaw использует формат provider/model-name, и опечатка в любой части вызовет эту ошибку. Используйте openclaw models list для просмотра всех доступных моделей для ваших настроенных провайдеров.

Ошибка 3: «Invalid API key» или ошибки аутентификации. API-ключ отсутствует, неправильно сформирован или просрочен. Для Anthropic ключи начинаются с sk-ant-. Для OpenAI — с sk-proj- (новый формат) или sk- (устаревший формат). Для OpenRouter — с sk-or-. Убедитесь, что вы установили правильную переменную окружения (ANTHROPIC_API_KEY, OPENAI_API_KEY или OPENROUTER_API_KEY) и что она не содержит концевых пробелов или символов переноса строки. Распространённая ошибка — копирование ключа с невидимыми символами из менеджера паролей.

Ошибка 4: «Rate limit exceeded» (HTTP 429). Вы отправляете слишком много запросов слишком быстро. Это особенно часто встречается с бесплатными уровнями API, где установлены низкие лимиты частоты запросов. Немедленное решение — подождать 30-60 секунд и повторить попытку. Долгосрочное решение — настроить мультимодельную маршрутизацию с резервными моделями, чтобы при достижении лимита у одного провайдера агент автоматически переключался на другой. Для постоянных проблем с лимитами запросов наше подробное руководство по ошибкам превышения лимита запросов охватывает специфические лимиты провайдеров и стратегии их смягчения.

Ошибка 5: «Out of memory» при запуске локальных моделей. Вы пытаетесь запустить модель, которая превышает доступную оперативную память. Решение простое: переключитесь на модель меньшего размера. Если у вас 16 ГБ оперативной памяти и вы загрузили модель с 30 миллиардами параметров, переключитесь на вариант с 7 миллиардами. Используйте ollama list для просмотра установленных моделей и обратитесь к таблице соответствия оборудования и моделей в разделе настройки Ollama выше, чтобы найти подходящий вариант для вашей машины.

Ошибка 6: «Tool calling not supported» или агент не может выполнять команды. Некоторые модели — особенно небольшие модели с открытым исходным кодом — не поддерживают вызов функций, на который полагается OpenClaw для действий агента, таких как редактирование файлов и выполнение команд. Решение — переключиться на модель с поддержкой вызова инструментов. Среди облачных моделей Claude Sonnet 4.5, GPT-5.2 и Gemini 3 Pro имеют надёжную поддержку вызова инструментов. Для локальных моделей Qwen2.5-Coder и DeepSeek-Coder-V2 включают такие возможности.

Ошибка 7: Ошибки «Invalid beta flag». Это проблема, связанная с версией, которая возникает, когда OpenClaw отправляет заголовки API, которые провайдер не распознаёт. Наиболее частая причина — устаревшая версия OpenClaw. Обновитесь до последней версии командой npm install -g openclaw@latest (требуется Node.js v24+). Для подробного разбора этой конкретной ошибки смотрите наше руководство по ошибке invalid beta flag и способам её устранения.

Ошибка 8: Превышение контекстного окна. Длинные беседы или большие файлы могут привести к тому, что общее количество токенов превысит контекстное окно модели. Симптомы включают обрезанные ответы или ошибки о максимальной длине контекста. Начните новую беседу командой /clear или переключитесь на модель с большим контекстным окном. Claude Sonnet 4.5 поддерживает 200K токенов, чего достаточно для большинства рабочих процессов агента.

Ошибка 9: Медленные ответы при использовании локальных моделей. Если локальная модель отвечает, но каждый ответ занимает 30+ секунд, скорее всего, вы используете модель слишком большую для вашего оборудования. Проверьте текущее использование памяти модели командой ollama ps и обратитесь к таблице оборудования для правильного подбора размера модели. Также убедитесь, что никакие другие ресурсоёмкие приложения не запущены одновременно с OpenClaw при использовании локальных моделей.

Ошибка 10: OpenClaw не распознаёт провайдера после настройки. После запуска openclaw onboard агент по-прежнему использует неправильного провайдера по умолчанию. Используйте openclaw models status для проверки текущей конфигурации и openclaw models set PROVIDER/MODEL для явной установки нужной модели. Команда /model в активной сессии OpenClaw также позволяет переключать модели на лету без перезапуска.

Что делать после настройки — переход к продуктивной работе

После настройки и проверки провайдера LLM вы готовы начать использовать OpenClaw как полноценный инструмент повышения производительности, а не как игрушку для экспериментов. Разница между пользователями, которые получают реальную пользу от OpenClaw, и теми, кто бросает его через неделю, обычно сводится к трём привычкам, которые стоит выработать прямо сейчас, пока настройка ещё свежа в памяти.

Начните с тестирования конфигурации на реальной задаче, а не на промпте «привет, мир». Попросите OpenClaw проанализировать файл в вашем текущем проекте, провести рефакторинг функции или написать тест для существующего кода. Это немедленно подтвердит, что вызов инструментов работает корректно, что модель обладает достаточными возможностями для вашей работы и что время отклика приемлемо. Если что-то не так — медленные ответы, неполный код или сбои вызова инструментов — вернитесь к разделу выбора провайдера и подумайте, не подошла бы вам другая модель лучше.

Затем настройте цепочку резервных моделей, даже если вы довольны основной моделью. Сбои провайдеров случаются, лимиты запросов достигаются в самый неподходящий момент, и наличие резервной модели означает, что ваш рабочий процесс никогда не остановится полностью. Как минимум добавьте одну облачную альтернативу и одну локальную модель в конфигурацию резервных моделей. Пять минут, потраченных сейчас, сэкономят вам часы разочарования при неизбежном простое провайдера.

Наконец, установите практику регулярного мониторинга затрат, если вы используете облачные модели. Проверяйте панель использования API еженедельно, настройте оповещения о биллинге на комфортных для вас пороговых значениях и отслеживайте, соответствуют ли фактические расходы вашим бюджетным ожиданиям. Если расходы выше ожидаемых, стратегия мультимодельной маршрутизации из предыдущего раздела — ваш наиболее эффективный рычаг: направляйте рутинные задачи на более дешёвые модели и резервируйте премиальные модели для сложной работы, которая действительно выигрывает от более сильных рассуждений.

OpenClaw — это инструмент, который вознаграждает вложения в конфигурацию. Наибольшую пользу получают те пользователи, которые рассматривают первоначальную настройку не как одноразовую задачу, а как фундамент для постоянно развивающегося рабочего процесса. Ваш выбор модели, цепочка резервных моделей и стратегия управления затратами будут меняться по мере развития ваших потребностей и появления новых моделей. Мастер openclaw onboard и команда /model делают адаптацию простой — ключ в том, чтобы продолжать итерации, а не останавливаться на конфигурации, которая работает «достаточно хорошо».

Экосистема OpenClaw стремительно развивается. Новые провайдеры моделей добавляются регулярно, ценообразование меняется по мере усиления конкуренции, а возможности локальных моделей улучшаются с каждым поколением. Сохраните это руководство в закладках и возвращайтесь к системе принятия решений по выбору провайдера всякий раз, когда задумаетесь об изменении настройки. Принципы — соответствие возможностей модели сложности задачи, настройка резервных моделей для надёжности и активный мониторинг затрат — остаются постоянными, даже когда конкретные рекомендации по моделям эволюционируют. Ваши первоначальные пять минут настройки — это лишь начало рабочего процесса, который будет становиться мощнее по мере совершенствования на протяжении недель и месяцев ежедневного использования.

Часто задаваемые вопросы

Можно ли использовать несколько провайдеров LLM одновременно с OpenClaw?

Да. Конфигурация цепочки резервных моделей OpenClaw в agents.defaults.model.fallbacks поддерживает несколько провайдеров. Основная модель обрабатывает запросы первой, и если она терпит неудачу или достигает лимита, агент автоматически переходит к следующей модели в цепочке. Вы также можете переключать провайдеров прямо в ходе сессии с помощью команды /model. Многие пользователи настраивают локальную модель Ollama в качестве последнего резерва, чтобы гарантировать работу агента даже тогда, когда все облачные провайдеры недоступны.

Какие минимальные требования к оборудованию для запуска OpenClaw с локальным LLM?

Абсолютный минимум — 8 ГБ оперативной памяти, что позволяет запускать модели с 3 миллиардами параметров на приемлемой скорости. Для продуктивной работы с локальными моделями рекомендуется 16 ГБ ОЗУ и модель с 7 миллиардами параметров, такая как Qwen2.5-Coder. Также потребуется Node.js версии 24 или новее и достаточно дискового пространства для файлов моделей (обычно 4-8 ГБ на модель). Компьютеры Mac на базе Apple Silicon с унифицированной памятью предлагают лучшую производительность локального инференса в пересчёте на доллар.

Как переключить модель без перезапуска OpenClaw?

Используйте команду /model в активной сессии OpenClaw. Введите /model, а затем имя провайдера и модели (например, /model anthropic/claude-sonnet-4.5). Это вступает в силу немедленно для следующего взаимодействия. Вы также можете использовать openclaw models set из терминала, чтобы изменить модель по умолчанию для всех будущих сессий. Используйте openclaw models list для просмотра всех доступных моделей для ваших настроенных провайдеров.

Безопасны ли мои данные при использовании облачных провайдеров LLM с OpenClaw?

При использовании облачных провайдеров (OpenAI, Anthropic, OpenRouter) ваши промпты и контекст кода отправляются на серверы провайдера для обработки. У каждого провайдера своя политика хранения данных и конфиденциальности. Если конфиденциальность данных — обязательное требование, используйте Ollama — весь инференс происходит локально, и никакие данные не покидают вашу машину. В качестве компромисса рассмотрите использование локальных моделей для конфиденциальных задач и облачных моделей для неконфиденциальной работы, настроив их через систему мультимодельной маршрутизации.

Сколько стоит использование OpenClaw с облачными моделями?

Расходы существенно варьируются в зависимости от интенсивности использования и выбора модели. Лёгкое использование (несколько взаимодействий в день) с Claude Sonnet 4.5 обходится в $5-15 в месяц. Интенсивное использование (непрерывные агентные сессии) может достигать $20-50 в день с премиальными моделями. Бюджетные модели через OpenRouter (DeepSeek V3.2 по $0,53/M токенов, MiMo-V2-Flash по $0,40/M) снижают расходы на 80-90% по сравнению с премиальными моделями. Мультимодельная маршрутизация с оптимизированной по стоимости цепочкой резервных моделей — наиболее эффективный способ контролировать расходы при сохранении качества.