Google 于 2026 年 2 月 19 日发布的最新前沿推理模型 Gemini 3.1 Pro Preview,可以在 Google AI Studio 中免费试用,但不提供免费 API 额度。Gemini API 对 Gemini 3.1 Pro Preview 的收费标准为每百万输入 token 2.00 美元、每百万输出 token 12.00 美元。该模型在 ARC-AGI-2 基准测试中取得了 77.1% 的成绩,是其前代产品 31.1% 分数的两倍多。本指南涵盖访问 3.1 Pro 的所有方式——从免费的 AI Studio 测试到付费 API 设置,再到能够将费用降低 50% 以上的成本优化策略。

要点速览

- 免费访问存在但有限制:你可以在 Google AI Studio 的浏览器端 Playground 中免费测试 Gemini 3.1 Pro Preview,无需信用卡,但没有编程 API 访问权限。

- API 定价:每百万输入 token 2.00 美元,每百万输出 token 12.00 美元(包含思考 token)。该模型没有免费 API 额度。

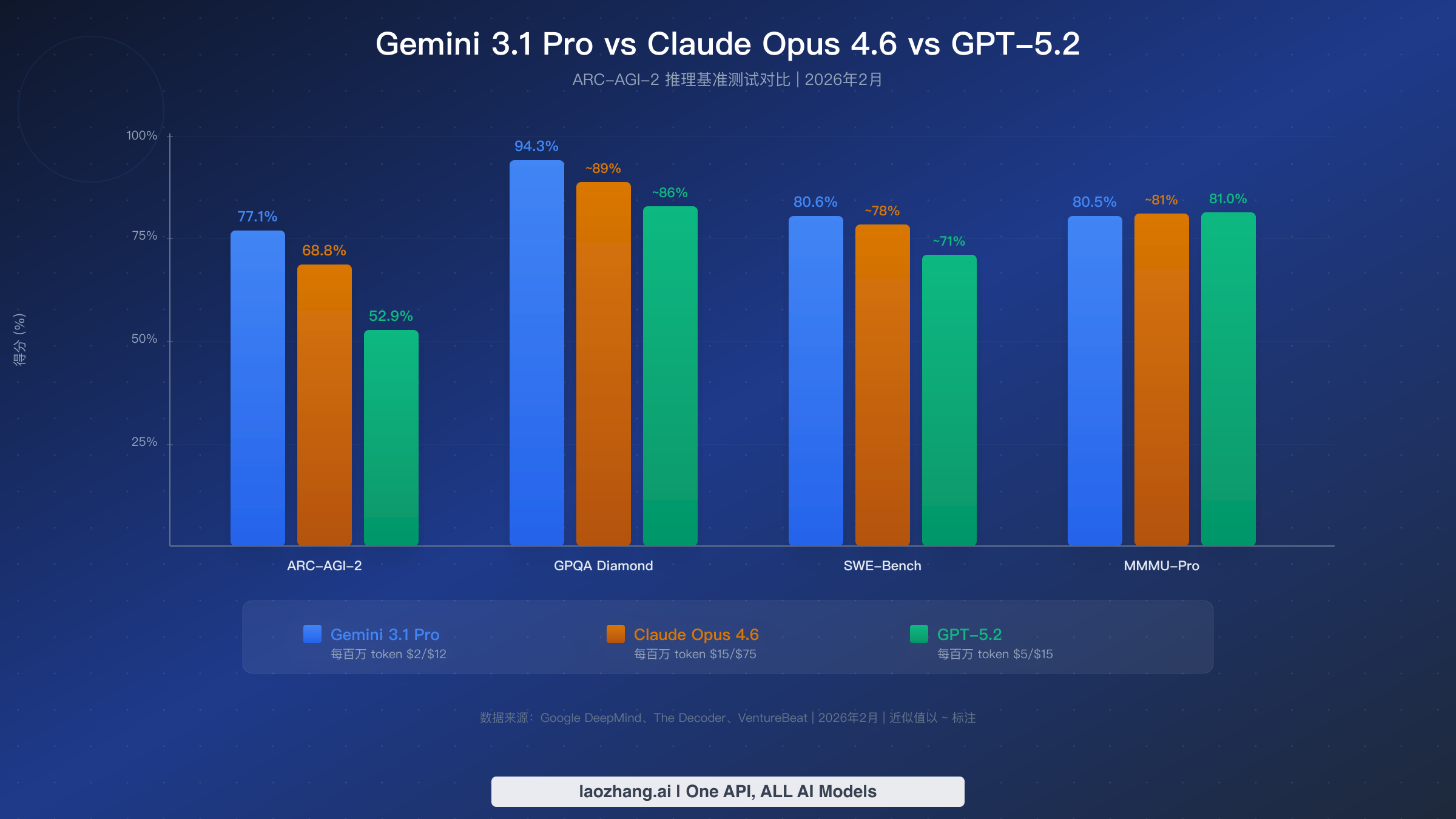

- 性能领先:ARC-AGI-2 得分 77.1%,超越 Claude Opus 4.6(68.8%)和 GPT-5.2(52.9%)。GPQA Diamond 得分 94.3%,SWE-Bench Verified 得分 80.6%。

- 成本优化:使用 Batch API 可享 5 折优惠,上下文缓存可节省高达 90%,思考预算控制可管理输出 token 成本。

- 多种访问方式:Google AI Studio(免费)、Gemini API(付费)、Vertex AI(企业级)、OpenRouter(聚合平台)以及第三方代理服务。

Gemini 3.1 Pro Preview 是什么?为什么开发者如此兴奋

Google DeepMind 于 2026 年 2 月 19 日发布了 Gemini 3.1 Pro Preview,将其定位为 Gemini 家族中最强大的推理模型。这次发布立即在开发者社区引起了广泛关注,主要原因是该模型在 ARC-AGI-2 基准测试中取得了 77.1% 的分数——这是一项专门用于衡量 AI 系统通用推理能力的测试。为了更直观地理解这个数字,Gemini 3 Pro 在同一基准测试上仅获得 31.1%,这意味着 3.1 版本在 Google 所称的"单代飞跃"中,将前代的性能提升了一倍多。这种幅度的提升在 AI 开发领域是极为罕见的,因为基准测试的进步通常以个位数百分点来衡量。

ARC-AGI-2 的成绩之所以重要,是因为它使 Gemini 3.1 Pro Preview 超越了两个主要竞争对手。Anthropic 的旗舰推理模型 Claude Opus 4.6 在同一测试中得分 68.8%,而 OpenAI 的 GPT-5.2 仅取得 52.9%(据 The Decoder,2026 年 2 月)。除推理能力外,该模型在科学知识方面同样表现出色,GPQA Diamond 得分 94.3%,在软件工程方面 SWE-Bench Verified 得分 80.6%(Google DeepMind 模型卡片,2026 年 2 月)。这些数据表明,这不仅是一个理论上强大的模型,而且在实际开发工作流中具有实用价值,包括代码生成、调试和技术分析等场景。

从实用角度来看,Gemini 3.1 Pro Preview 特别引人注目的是其性能与上下文容量的结合。该模型支持 1,048,576 token 的上下文窗口——大约相当于处理一整个代码库、一本 700 页的书籍或数小时的音频。输出上限为 65,536 token,模型接受多模态输入,包括文本、图片、视频、音频和 PDF 文档(ai.google.dev,2026 年 2 月)。对于经常处理大型文档集合或需要分析庞大代码库的开发者来说,这个上下文窗口消除了其他模型所需的复杂分块策略。该模型还具备"思考"模式,在生成回答之前逐步推理,类似于 Claude 和 OpenAI o 系列模型所采用的方法,不过 Google 的实现允许开发者设置明确的思考预算来控制成本。

Gemini 3.1 Pro Preview 的发布时机在 AI 行业的大背景下也值得关注。在 OpenAI 的 GPT-5.2 发布和 Anthropic 的 Claude Opus 4.6 更新周期之后仅数周便推出,这代表了 Google 在前沿模型能力方面重夺技术领先地位的积极举措。模型名称中的"Preview"标识表明这还不是最终的正式生产版本——Google 通常使用此标签来标记功能完整但在被指定为稳定版之前可能会接受进一步优化的模型。对于开发者而言,这意味着该模型今天已经完全可以用于生产环境,但你应该关注 Google 的模型弃用公告,并准备好在稳定版发布时更新模型标识符。根据 Google 以往的经验,从预览版到稳定版的过渡通常需要 2-4 个月,通常只涉及模型 ID 的变更,不会有 API 层面的破坏性更改。

如何在 Google AI Studio 中免费试用 Gemini 3.1 Pro Preview

开发者最常问的问题是 Gemini 3.1 Pro Preview 是否可以免费使用。坦率的回答需要做一个大多数文章未能清楚说明的区分:你可以通过 Google AI Studio 的网页端 Playground 免费与模型交互,但没有用于编程访问的免费 API 额度。在你投入时间制定任何集成方案之前,理解这一区别至关重要。Google AI Studio(aistudio.google.com)提供了一个聊天界面,你可以在其中输入提示词、上传图片并测试模型的能力,而无需创建计费账户或输入信用卡。这个 Playground 环境在提示工程、比较不同配置下的模型行为,以及在决定付费之前亲身体验模型的推理能力等方面确实非常有用。

要开始免费使用 Google AI Studio,请访问网站并用任意 Google 账户登录。从模型下拉菜单中选择"Gemini 3.1 Pro Preview"——自 2026 年 2 月 19 日起它应该显示为可用模型。你可以立即开始测试提示词、调整系统指令、尝试 temperature 和 top-p 设置。Playground 支持多模态输入,因此你可以上传图片、文档甚至音频文件来测试模型的理解能力。你还可以将提示词导出为 Python、JavaScript 或 cURL 格式的代码片段,为你转向付费 API 时提供便利。免费 Playground 还包含一个"获取代码"按钮,可根据你当前的提示配置生成可直接使用的 API 调用代码。

然而,免费的 AI Studio 访问存在一些需要了解的实质性限制。免费层级的响应受到速率限制,可能比付费 API 调用慢,尤其是在模型刚发布后的高需求时段。更重要的是,Google 的服务条款声明,通过免费 AI Studio Playground 提交的数据可能被用于改进 Google 产品,这意味着你绝不应该通过此渠道输入敏感、专有或机密信息。免费层级没有编程 API 访问——你无法向模型发起 HTTP 调用或将其集成到你的应用程序中,除非切换到付费的 Gemini API。对于需要Gemini API 免费额度选项的开发者,请注意虽然 Gemini 2.5 Flash 等旧模型仍提供限速的免费 API 访问,但 3.1 Pro Preview 模型仅通过付费方案提供。如果你的目标是生产集成、自动化工作流或任何需要 API 调用的场景,你都需要设置计费。

许多开发者采用的一个实用工作流程是:先在 AI Studio 中进行提示工程和评估,验证方案可行后再过渡到付费 API。AI Studio 允许你保存和组织提示模板、比较不同 temperature 设置下的响应、将可用配置导出为代码——所有这些都不需要花一分钱。这种"免费测试、付费部署"的方法特别有效,因为你可以在 Playground 环境中迭代系统提示和少样本示例,减少开发期间所需的付费 API 调用次数。AI Studio 中的"获取代码"功能会生成包含你精确提示配置的完整 Python 或 JavaScript 代码片段,使从免费测试到付费集成的过渡几乎无缝衔接。

设置 Gemini 3.1 Pro Preview API——开发者快速入门

开始使用付费的 Gemini 3.1 Pro Preview API 需要三样东西:一个 Google Cloud 或 AI Studio API 密钥、开发环境中安装的 Google Generative AI SDK,以及连接到 Google Cloud 项目的计费账户。对于熟悉 API 集成的开发者来说,设置过程简单直接,通常在五分钟内即可完成。首先访问 aistudio.google.com,点击顶部导航栏中的"获取 API 密钥",然后创建新的 API 密钥或选择现有的 Google Cloud 项目。确保你的计费账户已激活——与某些提供免费层级的 Gemini 模型不同,Gemini 3.1 Pro Preview 从第一次 API 调用起就需要计费。

对于 Python 开发者,使用 pip install google-genai 安装官方 SDK,然后用以下代码设置你的第一个 API 调用。这个示例演示了使用启用思考功能的 Gemini 3.1 Pro Preview 模型进行基本文本生成请求:

pythonfrom google import genai client = genai.Client(api_key="YOUR_API_KEY") response = client.models.generate_content( model="gemini-3.1-pro-preview", contents="Explain the key differences between TCP and UDP protocols, including when to use each one.", config={ "thinking_config": {"thinking_budget": 2048} } ) print(response.text)

对于 JavaScript 和 Node.js 开发者,使用 npm install @google/genai 安装 SDK,然后使用以下等效设置。JavaScript SDK 遵循类似的模式,如果你在多语言环境中工作,可以方便地在语言之间切换:

javascriptimport { GoogleGenAI } from "@google/genai"; const ai = new GoogleGenAI({ apiKey: "YOUR_API_KEY" }); async function main() { const response = await ai.models.generateContent({ model: "gemini-3.1-pro-preview", contents: "Explain the key differences between TCP and UDP protocols, including when to use each one.", config: { thinkingConfig: { thinkingBudget: 2048 } } }); console.log(response.text); } main();

使用 API 时,有几个值得了解的实际细节。thinking_budget 参数控制模型在生成响应之前可以用于内部推理的 token 数量——设置过低可能会降低推理质量,而设置过高会增加输出 token 成本,因为思考 token 与输出 token 的计费费率相同(每百万 12.00 美元,ai.google.dev 定价页面,2026 年 2 月)。对于简单问题,一个合理的起点是 2,048 token,对于复杂推理任务则应设置为 8,192 或更高。你还应该了解 3.1 Pro Preview 模型的速率限制和配额,由于模型的预览状态,这些限制可能与其他 Gemini 模型不同。在错误处理方面,请将 API 调用包装在 try-catch 块中,并对 429(速率限制)和 503(服务不可用)错误实现指数退避,这些错误在模型发布后的高流量时段很常见。

除了基本的文本生成之外,API 还支持通过 JSON 模式进行结构化输出,这对于构建可靠的应用程序至关重要。通过在请求配置中指定 JSON Schema,你可以强制模型以可预测的格式返回响应——使得以编程方式解析输出变得简单直接,无需使用脆弱的正则表达式或字符串操作。API 还支持函数调用(Function Calling),你可以定义一组模型在生成响应过程中可以调用的工具(函数)。这使你能够构建可以搜索数据库、调用外部 API 或在推理过程中执行计算的智能体。对于构建生产应用的开发者来说,这些功能将 Gemini 3.1 Pro Preview 从一个简单的文本生成器转变为一个可编程的推理引擎,能够集成到复杂的工作流中。gemini-3.1-pro-preview-customtools 变体专门为函数调用场景优化,与标准模型 ID 相比可能提供更好的工具选择准确性。

Gemini 3.1 Pro 与 Claude Opus 4.6 和 GPT-5.2——性能与价值对比

在 2026 年 2 月选择三个领先的前沿模型时,需要超越单一基准分数,综合考量完整的图景:不同任务类型的性能、定价结构和性价比。Gemini 3.1 Pro Preview 在通用推理(ARC-AGI-2 77.1%)、科学知识(GPQA Diamond 94.3%)和软件工程(SWE-Bench Verified 80.6%)方面领先。Claude Opus 4.6 在 Humanity's Last Exam 上以 53.1% 对 Gemini 的 44.4% 领先,表明在极高难度的跨领域问题上有更强的表现。GPT-5.2 在 MMMU-Pro 上领先(81.0% 对 Gemini 的 80.5%),显示在多模态理解任务上略有优势。在某些基准测试上的差异足够小,以至于实际表现可能因你的具体用例和提示工程方法而异。

定价对比揭示了更为清晰的价值图景。Gemini 3.1 Pro Preview 的收费标准为每百万输入 token 2.00 美元、每百万输出 token 12.00 美元(ai.google.dev,2026 年 2 月)。Claude Opus 4.6 的价格为每百万输入 token 15.00 美元、每百万输出 token 75.00 美元——输入贵 7.5 倍,输出贵 6.25 倍。GPT-5.2 居中,为每百万输入 token 5.00 美元、每百万输出 token 15.00 美元。当你使用 ARC-AGI-2 分数计算性价比指标时,Gemini 3.1 Pro 的每个百分点成本约为 0.18 美元(以输出定价为主要成本计算),而 Claude Opus 4.6 的每个百分点成本约为 1.09 美元——在推理任务上以更低的基准性能付出了超过 6 倍的价格。对于每天运行数千次 API 调用的团队来说,这种成本差异意味着在不牺牲质量的情况下实现可观的节省。

| 特性 | Gemini 3.1 Pro Preview | Claude Opus 4.6 | GPT-5.2 |

|---|---|---|---|

| ARC-AGI-2 | 77.1% | 68.8% | 52.9% |

| GPQA Diamond | 94.3% | ~89% | ~86% |

| SWE-Bench Verified | 80.6% | ~78% | ~71% |

| MMMU-Pro | 80.5% | ~81% | 81.0% |

| 输入成本 / 百万 | $2.00 | $15.00 | $5.00 |

| 输出成本 / 百万 | $12.00 | $75.00 | $15.00 |

| 上下文窗口 | 100 万 token | 20 万 token | 12.8 万 token |

| 最大输出 | 6.5 万 token | 3.2 万 token | 1.6 万 token |

| Batch API | 5 折优惠 | 不可用 | 5 折优惠 |

话虽如此,基准测试并不能说明全部情况。Claude Opus 4.6 在指令遵循精度、细致的安全行为以及智能体编码工作流的一致性方面仍然备受推崇。GPT-5.2 则得益于 OpenAI 成熟的生态系统,拥有广泛的第三方工具集成和庞大的开发者社区。你的选择应该取决于具体需求:如果原始推理性能和成本效率最为重要,Gemini 3.1 Pro Preview 在 2026 年 2 月提供了最佳价值。如果你需要特定的能力,例如 Claude 在复杂智能体任务中的可靠性或 GPT 的生态系统优势,那么更高的价格可能是合理的。许多开发者正在采用多模型策略,将 Gemini 用于成本敏感的批量处理,将竞品模型用于专门任务。要了解 Gemini 3 系列模型的完整对比(包括 Flash 变体),请参阅我们的专门对比指南。

如何将 Gemini 3.1 Pro API 费用降低 50% 以上

虽然 Gemini 3.1 Pro Preview 已经是最实惠的前沿推理模型,但你可以通过三种官方优化策略大幅降低成本:Batch API、上下文缓存和思考预算管理。这些技术可以组合使用,一个优化良好的管道与标准定价相比可以降低 60-80% 的有效成本——使 3.1 Pro Preview 在按任务计算的基础上与 Gemini Flash 等中端模型具有竞争力。

Batch API 是最简单的优化实现方式。你不需要同步发送请求并获取即时响应,而是将多个提示批量打包成一个异步任务,并在 24 小时内收到结果。Google 以 50% 的折扣奖励这种耐心等待——这意味着你的有效价格降至每百万输入 token 1.00 美元、每百万输出 token 6.00 美元(ai.google.dev,2026 年 2 月)。Batch API 适用于任何不需要实时响应的工作负载:文档分析管道、批量内容生成、数据集标注、大型代码库的代码审查以及夜间处理任务。实现只需最少的代码改动——你准备一个包含请求的 JSONL 文件,提交到批处理端点,然后轮询完成状态即可。对于许多团队来说,将 40-60% 的工作负载转移到批处理后,每月账单几乎减半,而且没有任何质量损失。

上下文缓存在重复性工作负载中代表着更大的成本削减机会。当你在多个 API 调用中发送相同的大型系统提示、文档或参考材料时,上下文缓存允许你存储一次该内容,然后在后续请求中引用它。缓存的输入 token 成本为每百万 0.20 美元(相比标准价格 2.00 美元)——节省 90%(ai.google.dev 定价,2026 年 2 月)。缓存的存储成本为每百万 token 每小时 4.50 美元,因此当你在短时间窗口内针对相同上下文进行频繁调用时,经济效益最好。例如,如果你正在构建一个引用 100 页产品手册的客服机器人,缓存该手册并进行 1,000 次查询的每次查询缓存上下文成本约为 0.02 美元,而不缓存则为 0.20 美元——仅在输入方面就节省了 10 倍。

第三个也是最容易被忽视的优化是思考预算管理。由于 Gemini 3.1 Pro Preview 的输出定价(每百万 token 12.00 美元)包含思考 token,模型执行的内部推理量直接影响你的账单。默认情况下,模型即使对简单问题也可能使用数千个思考 token。设置 thinking_budget 参数允许你控制这一点:对于格式化或翻译等简单任务使用 1,024-2,048 token,中等推理使用 4,096-8,192 token,仅对复杂的多步骤问题使用 16,384+。实际上,大多数查询不会从超过 4,096 个思考 token 中获益,降低默认值可以在典型工作负载上将输出成本减少 30-50%。你还可以将这三种策略结合起来:带有缓存上下文和受控思考预算的批处理可以将有效的每次查询成本降低 70-80%,使 Gemini 3.1 Pro Preview 对于大规模应用极具成本效益。

为了将这些优化以具体案例呈现,假设一家公司每月通过 Gemini 3.1 Pro Preview 处理 100,000 个客服工单。按标准定价计算,平均每个工单 800 个输入 token 和 2,000 个输出 token(包括思考 token),月成本约为输入 160.00 美元加输出 2,400.00 美元,合计 2,560.00 美元。对 60% 的非紧急工单使用批处理可节省 768.00 美元。为所有工单共享的产品文档添加上下文缓存可在输入成本上再节省 120.00 美元。将 40% 简单分类任务的思考预算从默认值降至 2,048 token,可在输出成本上节省约 480.00 美元。组合优化后的成本降至约 1,192.00 美元——比原始估算减少了 53%。对于扩展到数百万次 API 调用的团队,这些优化将 Gemini 3.1 Pro Preview 从"昂贵的前沿模型"转变为"与中端替代方案具有成本竞争力的选择"。

访问 Gemini 3.1 Pro Preview API 的其他方式

除了 Google 的直接 API 之外,还有多种替代途径可以访问 Gemini 3.1 Pro Preview,每种在定价、隐私、设置复杂度和功能支持方面有不同的权衡。你的选择取决于具体情况——是否需要多模型灵活性、企业合规性、区域访问或简化计费。了解这些选项可以确保你选择最符合技术需求和组织约束的访问方式。

Google AI Studio 和 Gemini API(直接访问)是大多数个人开发者和小型团队推荐的起点。你可以获得官方 SDK、包括思考模式和上下文缓存在内的完整功能支持、官方速率限制,以及通过付费 API 访问时数据不会被用于训练的保证。设置不到 5 分钟即可完成,你按照公布的定价支付,没有任何加价。主要限制是你被锁定在单一提供商——如果你之后想比较 Gemini 与 Claude 或 GPT 的输出,需要为每个提供商分别集成 API。

Vertex AI(通过 Google Cloud)是企业级路径。它以相同的基础定价提供相同的模型,但增加了企业功能:SLA 保证、VPC-SC 数据隔离、基于 IAM 的访问控制、CMEK 加密以及 SOC 2 / ISO 27001 合规认证。代价是设置复杂度——你需要一个 Google Cloud 项目、正确的 IAM 配置以及对 Vertex AI SDK 的熟悉。对于需要合规文档、数据驻留保证或与其他 Google Cloud 服务(BigQuery、Cloud Storage、Cloud Functions)集成的组织,Vertex AI 是合适的选择。对于初次接触 Google Cloud 的人,设置通常需要 30 分钟到一小时。

OpenRouter 是一个多模型聚合平台,通过统一的 API 提供对数十个 AI 模型的访问,包括 Gemini 3.1 Pro Preview。定价通常与 Google 直接定价相同或非常接近(约每百万 token 2/12 美元),OpenRouter 收取少量差价或按成本传递。主要优势是开发者体验:单一 API 密钥、单一 SDK,以及跨所有支持模型的一致请求/响应格式。这使得在应用代码中只需更改模型参数就能在 Gemini、Claude 和 GPT 之间切换变得轻而易举。对于评估多个模型或构建需要备用提供商的应用的团队,OpenRouter 消除了维护多个 SDK 集成的需要。

多模型聚合服务如 laozhang.ai 提供了另一种选择,特别适合需要通过单一统一 API 端点访问多个 AI 模型的开发者。这些服务可以提供有竞争力的价格和简化的计费,同时支持包括 Gemini 3.1 Pro Preview 在内的数十个模型。对于寻找实惠的 Gemini 图片 API 和文本模型的开发者,聚合平台通常将两种功能捆绑在一起。使用任何第三方服务时的关键考量是验证其数据处理政策、正常运行时间保证,以及是否传递完整的模型功能(思考模式、上下文缓存、流式传输)或以精简的功能集运行。有关可用模型和集成示例的详细文档,请查阅 API 文档。

在这些访问方式之间做选择时,决策通常归结为三个因素:你需要多少个模型、有什么合规要求,以及你愿意管理多少运营开销。对于构建个人项目的独立开发者,Google 的直接 API 是最简单的选择——一个 API 密钥、官方文档和简单直接的计费。对于在正式选定模型前评估多个模型的初创公司,OpenRouter 等聚合平台通过为所有提供商提供单一 API 界面来节省大量集成时间。对于有监管要求的企业,Vertex AI 是唯一能提供法律团队所需的合规认证和数据隔离保证的选项。好消息是,无论你通过 Google 直接访问、Vertex AI 还是第三方聚合平台,Gemini 3.1 Pro Preview 模型本身都是完全相同的——你获得的 ARC-AGI-2 77.1% 的性能不受访问方式影响。

Gemini 3.1 Pro Preview API 定价——完整明细

要全面理解 Gemini 3.1 Pro Preview 的定价结构,需要超越 2/12 美元这个标题数字。该模型使用基于上下文长度的分层定价系统,对标准 token 和缓存 token 有不同的费率,围绕思考 token 也有重要的细微差别,这些都会显著影响你的实际成本。以下所有定价数据均于 2026 年 2 月 20 日在 Google AI 官方定价页面上验证。

| 定价类别 | 标准(≤20 万上下文) | 长上下文(>20 万) |

|---|---|---|

| 输入 token | $2.00 / 百万 | $4.00 / 百万 |

| 输出 token(含思考) | $12.00 / 百万 | $18.00 / 百万 |

| 缓存输入 token | $0.20 / 百万 | $0.40 / 百万 |

| 缓存存储 | $4.50 / 百万 token / 小时 | $4.50 / 百万 token / 小时 |

| Batch API 输入 | $1.00 / 百万 | $2.00 / 百万 |

| Batch API 输出 | $6.00 / 百万 | $9.00 / 百万 |

| 搜索接地 | 每月 5,000 次免费,之后 $14/千次 | 相同 |

分层上下文定价意味着超过 200,000 token 的提示成本翻倍——每百万输入 token 4.00 美元、每百万输出 token 18.00 美元。这个阈值对于规划很重要:如果你的用例涉及处理超过 20 万 token 的非常大的文档或代码库,你的有效成本将高于标题数字。大多数典型的 API 使用每次请求都在 20 万 token 以下,但使用 Gemini 完整 100 万上下文窗口的开发者应相应做好预算。一个实用的策略是在处理大文档时积极使用上下文缓存——即使存储成本为每百万 token 每小时 4.50 美元,缓存 token 每百万 0.20-0.40 美元的价格也远低于每次请求以每百万 2.00-4.00 美元重新处理相同内容。

为了说明实际成本,考虑三个涵盖不同规模和用例的常见使用场景。一个每天处理 10,000 次对话的聊天机器人,平均每次对话 500 个输入 token 和 1,000 个输出 token(包括思考 token),输入成本约为 10.00 美元($2.00 x 500 万 token),输出成本约为 120.00 美元($12.00 x 1,000 万 token),合计每天约 130.00 美元,或每月约 3,900 美元。使用 Batch API 处理非实时对话可将此降至每月约 1,950 美元。一个每天处理 500 个文件的代码审查管道,每个文件 2,000 个输入 token 和 3,000 个输出 token,输入约 2.00 美元加输出约 18.00 美元,合计每天约 20.00 美元或每月 600 美元——对于大多数开发团队来说完全在预算范围内。一个每天处理 50 个大型 PDF(每个 50,000 token)并使用缓存上下文的文档分析系统,在结合上下文缓存和批处理后,每月成本不到 50 美元,与人工审查成本相比节省了数个数量级。

一个许多定价对比文章忽略的重要细节是搜索接地在 Gemini 3.1 Pro Preview 中的作用。Google 每月提供 5,000 次免费的搜索接地请求,之后每 1,000 次请求收费 14.00 美元(ai.google.dev,2026 年 2 月)。搜索接地允许模型在生成响应时访问实时网络信息,对于需要最新数据的应用非常有价值。如果你的用例涉及回答有关时事、最新产品发布或实时定价数据的问题,搜索接地能增加重大价值——但如果你预计会超过每月免费的 5,000 次请求,应该为此成本做好预算。对于大多数开发阶段的使用和许多生产应用来说,免费额度已经足够。

常见问题——关于 Gemini 3.1 Pro Preview API 的热门问答

Gemini 3.1 Pro Preview API 是免费的吗?

不是,Gemini 3.1 Pro Preview API 不提供免费层级。与其他一些 Gemini 模型(例如提供限速免费层级的 Gemini 2.5 Flash)不同,3.1 Pro Preview 从第一次 API 调用起就需要付费计费。不过,你可以在 Google AI Studio 的浏览器端 Playground(aistudio.google.com)中免费测试该模型——无需信用卡。Playground 允许你在承诺使用付费 API 之前,尝试提示词、上传文件并评估模型的能力。

每次 Gemini 3.1 Pro Preview API 调用大约需要多少钱?

成本取决于你的 token 使用量。按照每百万输入 token 2.00 美元、每百万输出 token 12.00 美元(包含思考 token)的标准定价,一次包含 500 个输入 token 和 1,500 个输出 token 的典型 API 调用成本约为 0.019 美元——不到两美分。你可以通过 Batch API(5 折优惠)、上下文缓存(缓存输入 token 节省 90%)和思考预算控制来进一步降低成本。大多数个人开发者在开发和测试阶段每月花费 5-50 美元。

Gemini 3 Pro 和 3.1 Pro Preview 之间有什么区别?

Gemini 3.1 Pro Preview 相比 Gemini 3 Pro 是一次重大飞跃,在 ARC-AGI-2 上得分 77.1%,而 3 Pro 为 31.1%——推理性能提高了一倍多。3.1 版本还增加了带有预算控制的改进思考能力、增强的代码生成(SWE-Bench 80.6% 对比之前的分数),以及在科学和数学基准测试上更好的表现。两个模型共享相同的 100 万 token 上下文窗口和多模态输入支持,但 3.1 Pro Preview 的推理改进使其在复杂分析任务上的能力显著增强。

我可以使用 Gemini CLI 来访问 Gemini 3.1 Pro Preview 吗?

可以,Gemini CLI 支持 Gemini 3.1 Pro Preview。你可以安装它,然后直接从终端使用该模型进行交互式编码辅助、文件分析和命令行工作流。CLI 需要一个已启用计费的有效 API 密钥,使用与标准 API 相同的定价。这对于希望在 Shell 工作流中集成 AI 辅助而无需构建自定义应用的开发者特别有用。

在编程任务方面,Gemini 3.1 Pro 与 Claude Opus 4.6 相比如何?

在 SWE-Bench Verified 基准测试(衡量实际软件工程能力的标准测试)上,Gemini 3.1 Pro Preview 得分 80.6%,而 Claude Opus 4.6 约为 78%(The Decoder,2026 年 2 月)。不过,实际差异是微妙的——Claude Opus 4.6 在智能体编码工作流的一致性和指令遵循精度方面广受好评,尤其是在模型需要在长对话中遵循复杂多步骤指令的场景。最显著的区别在于定价:Gemini 的成本为每百万 token 2/12 美元,而 Claude 为 15/75 美元,这使得 Gemini 在编程任务上的成本效率约为 Claude 的 6 倍。2026 年 2 月,许多开发者正在采用混合策略,将 Gemini 3.1 Pro Preview 用于高流量的代码分析、自动化测试生成和批量重构任务(成本效率至关重要的场景),而将 Claude Opus 4.6 保留给复杂的智能体编码任务(在这些场景中,指令遵循精度和长时间交互的一致性对成功至关重要)。