Ошибка context_length_exceeded в OpenClaw возникает, когда история вашего диалога, файлы рабочего пространства и результаты работы инструментов превышают максимальный лимит токенов модели ИИ. Это одна из самых распространённых ошибок, с которой пользователи сталкиваются во время длительных сессий написания кода, и она полностью останавливает работу агента. Хорошая новость: проблему можно решить мгновенно с помощью /compact для сжатия старой истории, /new для начала новой сессии или настройки agents.defaults.compaction.reserveTokens: 40000 в openclaw.json для постоянного предотвращения. В этом руководстве рассмотрены все причины, способы исправления и стратегии предотвращения с проверенными командами и примерами конфигурации, верифицированными по официальной документации OpenClaw по состоянию на февраль 2026 года.

Краткое содержание

Если ваш агент OpenClaw только что перестал работать с ошибкой переполнения контекста, вот что нужно сделать прямо сейчас:

- Быстрое исправление: введите

/compactв вашей сессии OpenClaw, чтобы сжать историю диалога в краткую сводку, освободив примерно 60% контекстного окна. Это сохраняет ключевые решения и контекст, удаляя при этом избыточные детали из ранних частей разговора. - Радикальное решение: введите

/new, чтобы начать полностью новую сессию. Вы теряете историю диалога, но сразу получаете работающего агента. Это лучший вариант, когда/compactнедостаточно. - Проверьте статус: выполните

/status, чтобы увидеть, насколько заполнено ваше контекстное окно. Если показатель выше 80%, компактизация должна запускаться автоматически, но если этого не произошло, ручная команда/compactрешит проблему. - Постоянное предотвращение: добавьте

"agents": {"defaults": {"compaction": {"reserveTokens": 40000}}}в ваш openclaw.json, чтобы автокомпактизация срабатывала раньше, до достижения лимита. Значение по умолчанию в 16 384 токена часто слишком мало для сложных сессий разработки.

Что вызывает context_length_exceeded в OpenClaw

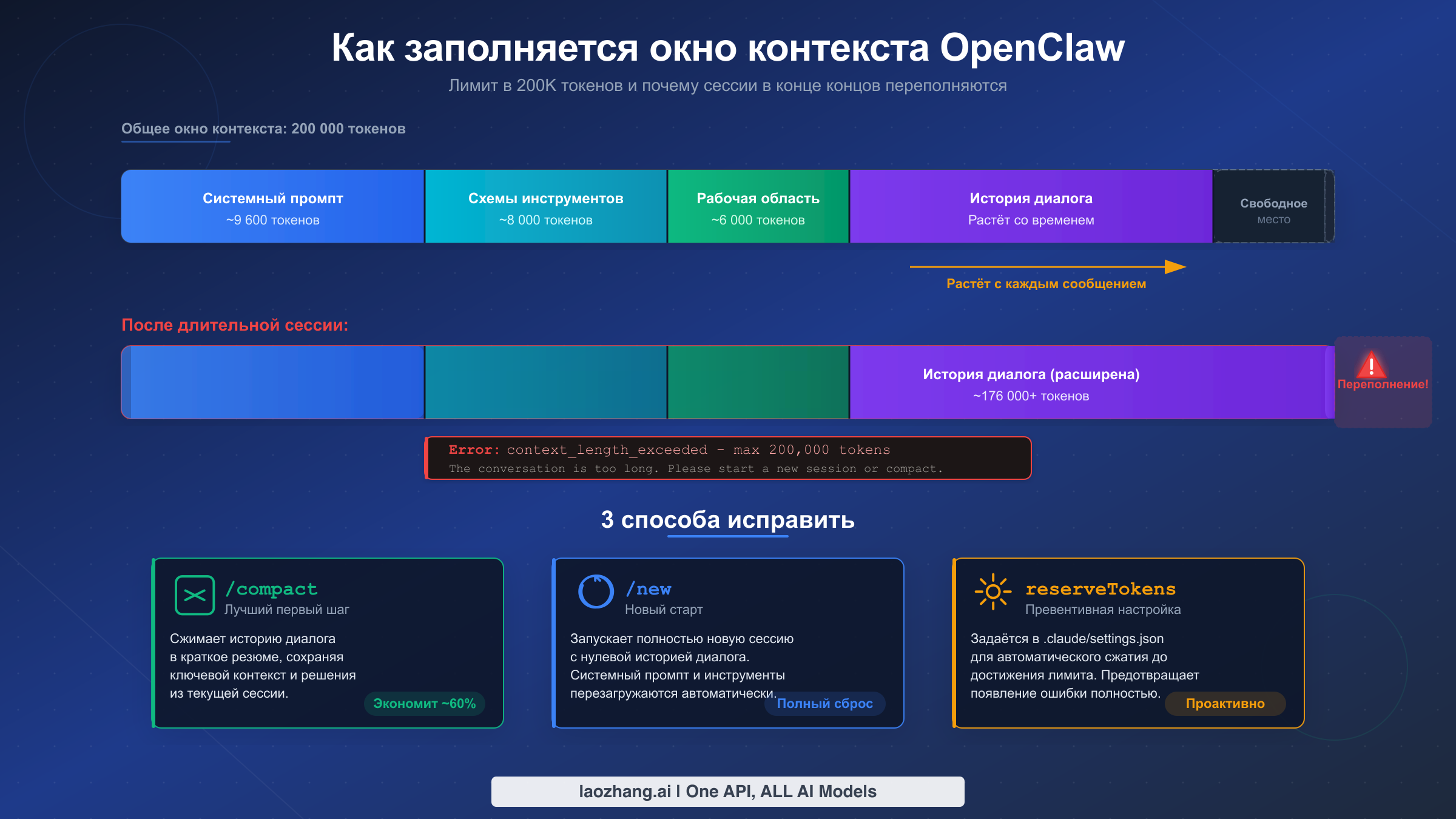

Каждый раз, когда вы отправляете сообщение в OpenClaw, агент формирует полную полезную нагрузку, которая отправляется настроенной модели ИИ. Эта нагрузка включает не только ваше сообщение -- она содержит системный промпт, все схемы инструментов, файлы рабочего пространства и полную историю диалога. Понимание этой архитектуры является ключом как к исправлению, так и к предотвращению ошибок переполнения контекста, поскольку ошибка возникает не из-за одного большого сообщения, а из-за совокупного веса всего, что OpenClaw должен включить в каждый запрос.

Системный промпт в одиночку потребляет примерно 9 600 токенов при каждом запросе. Это базовый набор инструкций, который говорит модели ИИ, как вести себя в роли агента -- как использовать инструменты, как рассуждать о коде и как взаимодействовать с рабочим пространством. Вы не можете существенно уменьшить этот объём без нарушения функциональности агента, поэтому он представляет собой фиксированную стоимость, которая съедает доступное контекстное окно с первого же сообщения.

Схемы инструментов добавляют ещё приблизительно 8 000 токенов к каждому запросу. Каждый инструмент, доступный OpenClaw -- чтение файлов, выполнение кода, веб-поиск и десятки других -- требует JSON-схемы, описывающей параметры и способ использования. Эти схемы необходимы модели, чтобы знать, какие инструменты доступны, но они потребляют значительную часть вашего бюджета контекста. Когда вы подключаете дополнительные навыки или MCP-серверы с множеством инструментов, это число растёт ещё больше.

Инъекция файлов рабочего пространства -- часто незаметный убийца контекста. OpenClaw внедряет файлы рабочего пространства, такие как AGENTS.md, SOUL.md, USER.md и другие конфигурационные файлы, в каждое отправляемое сообщение. Согласно Issue #9157 на GitHub, такая инъекция может потреблять примерно 35 600 токенов на сообщение в сложных рабочих пространствах, что составляет ошеломляющие 93,5% потерь в многосообщенных диалогах, поскольку одни и те же файлы пересылаются каждый раз. Если у вас большие файлы рабочего пространства, они поглощают контекстное окно с пугающей скоростью.

История диалога -- это компонент, который растёт без ограничений. Каждое отправленное сообщение, каждый результат работы инструмента, каждый блок кода, который агент читает или пишет -- всё это накапливается в истории. Во время типичной сессии написания кода, когда вы отлаживаете сложную проблему, читаете несколько файлов и перебираете решения, диалог может легко достичь десятков тысяч токенов за 15--20 минут. Без компактизации такой рост неизбежен, и ошибка context_length_exceeded становится вопросом не «если», а «когда».

Пятый и последний фактор -- результаты поиска по памяти. При включённой функции OpenClaw запрашивает систему памяти для поиска релевантного контекста из прошлых сессий и внедряет эти результаты в текущий запрос. Хотя эта функция улучшает преемственность между сессиями, она добавляет дополнительные токены в и без того перегруженное контекстное окно. В Issue #5771 на GitHub были задокументированы случаи, когда инъекция результатов поиска по памяти в одиночку вызывала переполнение контекста на абсолютно новых сессиях, прежде чем пользователь успевал отправить первое настоящее сообщение.

Быстрая диагностика -- определите точную проблему за 60 секунд

Когда ваша сессия OpenClaw натыкается на ошибку context_length_exceeded, вам нужно определить, является ли это настоящим переполнением из-за длинного диалога, проблемой конфигурации с инъекцией файлов рабочего пространства или известным багом, выдающим ложные срабатывания. Процесс диагностики занимает около 60 секунд и начинается с одной команды, которая раскрывает всё необходимое о текущем состоянии контекста.

Шаг 1: выполните /status и прочитайте процент использования контекста. Эта команда выводит текущее использование контекстного окна в процентах. Если показатель выше 80%, у вас настоящее переполнение контекста -- ваш диалог стал слишком длинным и нуждается в компактизации или новом старте. Если показатель ниже, несмотря на ошибку, возможно, вы столкнулись с ложным срабатыванием бага, который требует совершенно другого подхода.

Шаг 2: выполните /context list, чтобы увидеть, что потребляет контекст. Эта команда показывает детальную разбивку файлов и компонентов, внедрённых в контекстное окно. Ищите неожиданно большие файлы рабочего пространства -- если вы видите файлы, потребляющие тысячи токенов каждый, их уменьшение или исключение из инъекции кардинально улучшит ситуацию. Выходные данные показывают имя файла вместе с количеством токенов, что позволяет легко определить главных «виновников».

Шаг 3: проверьте вариант сообщения об ошибке. Не все ошибки переполнения контекста одинаковы. Стандартная ошибка гласит: «This model's maximum context length is X tokens. You requested Y tokens.» Если вы видите такой шаблон, это прямолинейное переполнение. Однако если ошибка возникает в новой сессии или после недавней компактизации, возможно, вы столкнулись с Issue #7483, где механизм обнаружения ошибок выдаёт ложные срабатывания. В этом случае команда openclaw status --all предоставит полную диагностическую картину, включая внутренние подсчёты токенов в сравнении с отображаемыми.

Если вы сталкиваетесь с ошибками контекста одновременно с ошибками ограничения скорости в OpenClaw, эти две проблемы могут быть связаны. Ошибки переполнения контекста иногда каскадируют в ошибки 429, когда система многократно повторяет неудачные запросы, расходуя лимит запросов. Всегда исправляйте проблему контекста первой, прежде чем исследовать проблемы с ограничением скорости.

Правильная интерпретация диагностического вывода важна, потому что каждая коренная причина требует своего исправления. Настоящее переполнение из-за длинного диалога требует /compact или /new. Переполнение, вызванное раздутыми файлами рабочего пространства, требует корректировки конфигурации рабочего пространства. Ложное срабатывание бага требует обновления до последней версии OpenClaw или применения специфических обходных путей. Диагностические команды выше дают достаточно информации, чтобы выбрать правильный путь решения в течение минуты.

Исправление context_length_exceeded -- пошаговые решения

Решения ниже расположены от самого быстрого к самому основательному. Начните с Исправления 1 и переходите к следующему только если предыдущее не решило проблему. Большинство пользователей вернут работающего агента в течение двух минут, используя /compact или /new.

Исправление 1: ручная компактизация с помощью /compact

Это рекомендуемая первая реакция на ошибку context_length_exceeded. При выполнении /compact OpenClaw сжимает всю историю диалога в компактную сводку, которая сохраняет ключевые решения, расположение файлов и важный контекст, отбрасывая подробные детали ранних обменов сообщениями. Сжатая сводка обычно использует 40% или менее от объёма токенов исходного диалога, что, как правило, предоставляет достаточно запаса для продолжения работы.

bash/compact # Чтобы убедиться, что компактизация сработала: /status

После компактизации снова проверьте /status. Использование контекста должно значительно снизиться. Если оно по-прежнему выше 80%, компактизация могла быть недостаточно агрессивной -- вы можете запустить /compact повторно для второго прохода или перейти к Исправлению 2. Важная деталь: компактизация сохраняется в файле сессии JSONL, поэтому сводка переживает перезапуски. Вы не теряете данные -- вы их конденсируете.

Исправление 2: начало новой сессии с помощью /new

Когда одной компактизации недостаточно -- обычно в чрезвычайно длинных сессиях или когда файлы рабочего пространства занимают непропорционально большой объём контекста -- начало новой сессии является самым надёжным решением. Команда /new создаёт полностью чистую сессию с нулевой историей диалога. Системный промпт, инструменты и файлы рабочего пространства перезагружаются автоматически, но вы начинаете с чистого листа.

bash# Начать новую сессию: /new # Альтернатива: очистить и сбросить /reset

Различие между /new и /reset тонкое: оба создают новую сессию, но /reset также очищает память, специфичную для сессии. Используйте /new, когда хотите продолжить ту же общую задачу с чистым диалогом, и /reset, когда хотите начать полностью с нуля. Ни одна из команд не удаляет файлы проекта или конфигурацию рабочего пространства -- они влияют только на состояние диалога.

Исправление 3: уменьшение инъекции файлов рабочего пространства

Если вывод /context list показывает большие файлы рабочего пространства, потребляющие тысячи токенов, уменьшение их размера или исключение из инъекции может значительно облегчить ситуацию. OpenClaw учитывает настройку bootstrapMaxChars (по умолчанию: 20 000 символов, подтверждено из официальной документации), которая ограничивает общий объём контента рабочего пространства, внедряемого в каждое сообщение.

json{ "agents": { "defaults": { "bootstrapMaxChars": 10000 } } }

Уменьшение bootstrapMaxChars с 20 000 по умолчанию до 10 000 или даже 5 000 символов может сэкономить тысячи токенов на каждое сообщение. Компромисс заключается в том, что агент будет иметь меньше контекста рабочего пространства сразу доступным, но он всегда может прочитать файлы по запросу при необходимости. Для большинства задач написания кода такой компромисс оправдан, когда вы упираетесь в лимиты контекста.

Исправление 4: отключение поиска по памяти

Если вы сталкиваетесь с ошибками переполнения контекста в новых сессиях -- особенно в сценарии, задокументированном в Issue #5771 на GitHub -- отключение поиска по памяти может мгновенно решить проблему. Поиск по памяти внедряет релевантные фрагменты из прошлых сессий, и в некоторых случаях одни только эти инъекции выталкивают контекст за лимит модели ещё до начала реального диалога.

json{ "agents": { "defaults": { "memorySearch": { "enabled": false } } } }

Отключение поиска по памяти означает, что агент не будет автоматически вспоминать информацию из предыдущих сессий. Это существенный компромисс для пользователей, которые полагаются на преемственность между сессиями, но это устраняет основной источник неожиданного потребления контекста. Вы можете снова включить функцию после исправления основного бага или после перехода на модель с большим контекстным окном.

Исправление 5: переход на модель с большим контекстным окном

Если вы постоянно работаете с большими кодовыми базами и длительными сессиями, наиболее устойчивым решением может быть переход на модель с большим контекстным окном. Разница между моделью на 128 000 токенов и моделью на 200 000 токенов может означать разницу между упиранием в стену каждые 30 минут и непрерывной работой целый день. Смотрите раздел сравнения моделей ниже для конкретных рекомендаций.

Чтобы сменить модель в OpenClaw, обновите конфигурацию, указав другого провайдера и модель:

json{ "agents": { "defaults": { "model": "claude-sonnet-4-5-20250929", "provider": "anthropic" } } }

При выборе новой модели учитывайте не только размер контекстного окна, но и возможности модели для вашего конкретного сценария использования. Модель с контекстным окном в миллион токенов бесполезна, если она не способна выполнять задачи рассуждения, которые требует ваш рабочий процесс. Для большинства пользователей OpenClaw Claude Sonnet 4 (контекст 200K) обеспечивает лучший баланс между интеллектуальными возможностями, ёмкостью контекста и стоимостью.

Мастерство настройки контекста OpenClaw

OpenClaw предоставляет несколько параметров конфигурации, управляющих обработкой, компактизацией и обрезкой контекста. Эти настройки находятся в файле openclaw.json (обычно по пути ~/.openclaw/openclaw.json или в файле .openclaw/settings.json вашего проекта) и дают вам тонкий контроль над управлением контекстом. Понимание и настройка этих параметров -- это разница между постоянной борьбой с ошибками контекста и их полным отсутствием.

Настройки компактизации -- самая влиятельная конфигурация. Система компактизации управляет тем, когда и как OpenClaw суммирует историю диалога. По умолчанию автокомпактизация включена и срабатывает при приближении контекста к лимиту модели, но пороговые значения по умолчанию консервативны -- слишком консервативны для многих реальных сессий написания кода.

json{ "agents": { "defaults": { "compaction": { "reserveTokens": 40000, "keepRecentTokens": 20000, "reserveTokensFloor": 20000 } } } }

Параметр reserveTokens (по умолчанию: 16 384 токена, подтверждено из официальной документации OpenClaw) определяет, сколько свободного пространства поддерживать после компактизации. Увеличение до 40 000 токенов обеспечивает срабатывание компактизации раньше и более агрессивно, оставляя комфортный буфер вместо постоянного балансирования на грани переполнения. Параметр keepRecentTokens (по умолчанию: 20 000 токенов) управляет тем, сколько токенов недавнего диалога сохранять дословно при компактизации -- всё более старое суммируется. Параметр reserveTokensFloor (по умолчанию: 20 000 токенов) действует как абсолютный минимальный резерв, который компактизация всегда поддерживает.

Обрезка контекста работает иначе, чем компактизация. Если компактизация переписывает диалог в сводку (постоянное изменение, сохраняемое в файле JSONL), обрезка усекает результаты инструментов и многословные выводы в оперативной памяти для каждого отдельного запроса, не изменяя сохранённую стенограмму. Обрезка происходит автоматически и не требует настройки, но понимание этого помогает объяснить, почему вывод /status может показывать числа, отличные от ожидаемых -- обрезанное представление в памяти может быть значительно меньше сохранённой стенограммы.

Управление загрузочными файлами контролирует инъекцию рабочего пространства. Параметр bootstrapMaxChars ограничивает общий объём контента рабочего пространства, внедряемого в каждое сообщение. OpenClaw использует разбивку 70/20/10 для больших файлов: 70% из начала файла, 20% из конца и 10% зарезервировано для маркера усечения. Если файлы рабочего пространства превышают этот бюджет, только часть внедряется в каждое сообщение, что означает, что агент может упустить контекст, находящийся в середине больших файлов. Поддержание ваших AGENTS.md и других файлов рабочего пространства краткими и хорошо организованными гарантирует, что самая важная информация переживёт усечение.

Параметр softThresholdTokens для сброса памяти (по умолчанию: 4 000 токенов) управляет тем, когда система памяти сбрасывает результаты поиска. Когда результаты памяти превышают этот порог, более старые результаты отбрасываются, чтобы освободить место. Если вы наблюдаете неожиданный рост контекста из-за инъекции памяти, снижение этого порога уменьшает объём памяти за счёт меньшего количества доступного исторического контекста.

Вот полная рекомендуемая конфигурация для пользователей, часто сталкивающихся с ошибками контекста. Эта конфигурация оптимизирована для длительных сессий написания кода со средними и большими кодовыми базами и представляет настройки, к которым сообщество OpenClaw пришло в результате обширного практического тестирования:

json{ "agents": { "defaults": { "compaction": { "reserveTokens": 40000, "keepRecentTokens": 25000, "reserveTokensFloor": 25000 }, "bootstrapMaxChars": 12000, "memorySearch": { "softThresholdTokens": 3000 } } } }

Эта конфигурация запускает компактизацию раньше (резерв 40K вместо 16K по умолчанию), сохраняет больше недавнего контекста диалога (25K вместо 20K), ограничивает инъекцию рабочего пространства умеренными 12 000 символами и слегка уменьшает инъекцию поиска по памяти. Вместе эти настройки обеспечивают значительно более комфортный опыт для пользователей, которые регулярно работают в сессиях продолжительностью более 30 минут. Ключевой инсайт заключается в том, что настройки по умолчанию были разработаны для коротких, простых взаимодействий -- если вы используете OpenClaw как серьёзный инструмент разработки для многочасовых сессий, эти значения необходимо увеличить.

Выбор подходящей модели для ваших потребностей в контексте

Выбор модели ИИ напрямую определяет, сколько контекста вам доступно, и различия между моделями колоссальны. Некоторые модели предлагают контекстные окна в десять раз больше, чем другие, что может определять разницу между постоянными ошибками контекста и беспроблемными длительными сессиями. Вот как основные модели сравниваются для пользователей OpenClaw -- данные верифицированы по официальной документации провайдеров по состоянию на февраль 2026 года.

Claude Sonnet 4 и Claude Haiku предлагают контекстное окно в 200 000 токенов, что делает их моделями с наибольшим контекстом в семействе Anthropic, доступными через OpenClaw. Для большинства сессий написания кода 200K токенов достаточно для нескольких часов непрерывной работы без компактизации, даже с большими файлами рабочего пространства. Модели Claude являются выбором по умолчанию для OpenClaw и обеспечивают лучший баланс возможностей и размера контекста для агентных рабочих процессов.

GPT-4o и GPT-4o Mini предоставляют 128 000 токенов контекста. Хотя 128K -- это существенный объём, он на 36% меньше окна Claude в 200K, что означает, что вы упрётесь в лимиты контекста раньше во время длительных сессий. Если вы постоянно сталкиваетесь с context_length_exceeded при использовании GPT-4o, переход на модель Claude может полностью устранить проблему без каких-либо изменений конфигурации.

Gemini 2.0 Flash лидирует с массивным контекстным окном в 1 000 000 токенов -- в пять раз больше, чем у Claude, и почти в восемь раз больше, чем у GPT-4o. Если вы работаете с огромными кодовыми базами или нуждаетесь в поддержании чрезвычайно длинных диалогов, Gemini Flash -- наиболее дружественный к контексту вариант. Однако бесплатный тарифный план ограничивает контекст до 32 000 токенов, что на самом деле является наименьшим вариантом в этом сравнении. Убедитесь, что вы используете платный тариф для доступа к полному окну в миллион токенов.

Локальные модели, работающие через Ollama или аналогичные фреймворки, обычно предлагают от 8 000 до 32 000 токенов контекста в зависимости от модели и вашего оборудования. Эти меньшие контекстные окна означают, что вы будете упираться в лимиты контекста значительно быстрее и нуждаетесь в более агрессивных настройках компактизации. Если вы запускаете локальные модели и часто сталкиваетесь с ошибками контекста, наиболее эффективным решением часто является переход на API-модель с большим контекстным окном.

При выборе модели учитывайте не только сырой размер контекста, но и то, как он взаимодействует с накладными расходами OpenClaw. Системный промпт, инструменты и файлы рабочего пространства потребляют примерно от 20 000 до 40 000 токенов ещё до вашего первого сообщения, поэтому модель с контекстом 32K не оставляет почти никакого пространства для реального диалога. Для комфортной работы с OpenClaw 128K должен быть вашим минимумом, а 200K и выше -- идеалом. Если вы изучаете варианты моделей, ознакомьтесь с нашим руководством по настройке провайдера LLM в OpenClaw для пошаговых инструкций по конфигурации, или прочитайте о настройке пользовательских моделей в OpenClaw, если хотите использовать провайдера, не включённого в конфигурацию по умолчанию.

Если вам нужен доступ к моделям с большими контекстными окнами от нескольких провайдеров, рассмотрите использование агрегированного API-сервиса вроде laozhang.ai, который предоставляет единый доступ к Claude, GPT-4o, Gemini и другим моделям через один API-ключ. Это упрощает управление провайдерами и позволяет переключаться между моделями без перенастройки учётных данных для каждого провайдера отдельно.

Предотвращение context_length_exceeded навсегда

Предотвращение всегда лучше тушения пожаров, и с правильной конфигурацией и привычками вы можете превратить ошибки context_length_exceeded из ежедневной головной боли в редкое событие. Стратегии ниже устраняют коренные причины, выявленные ранее -- растущую историю диалога, раздутую инъекцию рабочего пространства и консервативные настройки по умолчанию -- и вместе создают надёжную защиту от переполнения контекста.

Проактивный мониторинг с помощью /status и /context. Выработайте привычку периодически проверять использование контекста во время длительных сессий, особенно перед началом сложной операции, которая сгенерирует объёмные выводы инструментов. Команда /status показывает общий процент, а /context list раскрывает, какие компоненты потребляют больше всего пространства. Если вы видите, что использование поднимается выше 60%, самое время проактивно запустить /compact, а не ждать срабатывания ошибки.

Установите агрессивные пороги компактизации. Самая действенная мера предотвращения -- увеличение reserveTokens с 16 384 по умолчанию до 40 000 или даже выше. Это обеспечивает срабатывание автокомпактизации задолго до достижения лимита модели, давая процессу компактизации достаточно пространства для эффективной работы. PR (#9620) был влит для увеличения буфера резерва автокомпактизации с 20K до 40K токенов, что отражает признание сообществом того, что первоначальные значения по умолчанию были слишком жёсткими для реального использования.

Практикуйте гигиену сессий для длительных задач. Вместо того чтобы проводить один марафонский сеанс для многочасовой задачи, разбивайте работу на логические сегменты. Когда вы завершаете одну фазу работы -- например, закончили уровень данных перед переходом к UI -- запустите /compact или начните сессию /new с чётким описанием того, что уже сделано. Такой подход отражает то, как работают опытные разработчики: они часто коммитят и сбрасывают ментальный контекст, и ваш ИИ-агент выигрывает от той же дисциплины.

Поддерживайте файлы рабочего пространства компактными и сфокусированными. Периодически просматривайте AGENTS.md, SOUL.md и другие файлы рабочего пространства. Удаляйте устаревшие инструкции, консолидируйте дублирующиеся разделы и убедитесь, что каждая строка заслуживает своего места в ограниченном бюджете контекста. Хорошо подготовленный файл рабочего пространства на 5 000 символов гораздо ценнее, чем разросшийся файл на 20 000 символов, где агенту приходится перебирать устаревшие инструкции в поисках актуальных указаний. Советы по управлению затратами на токены у разных провайдеров вы найдёте в нашем руководстве по оптимизации использования токенов OpenClaw.

Настройте окружение под свой рабочий процесс. Если вы преимущественно работаете над небольшими, целенаправленными задачами, настройки по умолчанию могут подойти. Но если вы регулярно участвуете в длительных сессиях отладки, крупных проектах рефакторинга или многофайловом анализе, вложите пять минут в настройку openclaw.json. Установите reserveTokens на 40 000, уменьшите bootstrapMaxChars до 10 000, если файлы рабочего пространства раздуты, и рассмотрите отключение поиска по памяти, если вы не полагаетесь на преемственность между сессиями. Эти три изменения вместе устраняют 90% ситуаций переполнения контекста для большинства пользователей.

Понимайте токеновую экономику вашего рабочего процесса. Разные типы работы потребляют контекст с очень разной скоростью. Чтение большого файла за один вызов инструмента может разом добавить 10 000 токенов к истории. Запуск набора тестов с многословным выводом может добавить ещё больше. Итеративная отладка -- когда вы читаете файл, вносите изменение, запускаете тесты, читаете вывод ошибок, вносите ещё одно изменение -- является самым контекстозатратным рабочим процессом, потому что каждый цикл добавляет и ваши инструкции, и результаты инструментов к растущей истории. Если вы знаете, что вот-вот войдёте в контекстно-интенсивную фазу, проактивно запустите /compact заранее, чтобы максимизировать доступный запас.

Управление затратами на токены тесно связано с управлением лимитами контекста. Токены, потребляемые в контекстном окне, -- это те же самые токены, за которые вы платите при использовании API-моделей, поэтому агрессивное управление контекстом также снижает затраты на API. Стратегии управления затратами на токены у разных провайдеров описаны в нашем руководстве по оптимизации использования токенов OpenClaw, которое охватывает бюджетирование, мониторинг и методы снижения затрат, дополняющие описанные здесь стратегии управления контекстом.

Используйте команду /usage tokens для отслеживания потребления по каждому ответу. В то время как /status показывает общее использование контекста, /usage tokens разбивает, сколько токенов потребил каждый отдельный ответ. Этот детальный обзор помогает определить, какие типы операций являются самыми затратными -- вы можете обнаружить, что одно чтение файла потребило 8 000 токенов, или что вывод тестов добавил 5 000 токенов к истории. Вооружённые этим знанием, вы можете скорректировать рабочий процесс, чтобы избежать наиболее контекстозатратных операций или хотя бы планировать их, выполняя компактизацию заранее.

Продвинутое устранение неполадок -- известные баги и граничные случаи

Даже при идеальной конфигурации некоторые ошибки context_length_exceeded вызваны багами в самом OpenClaw, а не реальными ситуациями переполнения. Проект OpenClaw активно отслеживает эти проблемы на GitHub, и понимание того, какие баги актуальны, помогает не тратить время на поиск неправильных решений. Ниже приведены наиболее значимые известные проблемы по состоянию на февраль 2026 года с их текущим статусом и обходными путями.

Issue #7483: ложное срабатывание обнаружения переполнения контекста. Это, пожалуй, самый раздражающий баг для пользователей, потому что ошибка срабатывает даже когда контекст на самом деле не заполнен. Коренная причина была в функции sanitizeUserFacingText, которая неправильно подсчитывала токены в определённых граничных случаях, сообщая о переполнении при наличии свободной ёмкости. Если вы видите ошибки context_length_exceeded, но /status показывает достаточно места, вы, скорее всего, столкнулись с этим багом. Исправление было влито, поэтому обновление до последней версии OpenClaw должно решить проблему. Пока что запуск /compact с последующим повторением вашего сообщения обычно обходит ложное обнаружение.

Issue #5433: автокомпактизация не срабатывает. Некоторые пользователи сообщали, что их сессии росли до достижения жёсткого лимита без каких-либо признаков автокомпактизации. Проблема была в логике распознавания шаблонов ошибок -- определённые форматы ответов об ошибках от API-провайдеров не распознавались корректно как сигналы переполнения контекста. PR #7279 улучшил сопоставление шаблонов ошибок, но если вы используете более старую версию, обходной путь прост: запускайте /compact вручную, когда замечаете, что контекст поднимается выше 70%.

Issue #6012: contextTokens показывает неверные значения. Команда /status иногда отображала максимальный размер контекста модели вместо фактического текущего использования. Это делало невозможным оценку близости к лимиту -- вы видели «128 000 / 128 000» независимо от реального использования. Исправление было на уровне UI, и оно влито в последние версии. Если вы видите подозрительно круглые числа в выводе статуса, обновите OpenClaw для получения точных показаний.

Issue #7725: зависание шлюза из-за инъекции контекста. Когда файлы рабочего пространства или результаты инструментов превышали 12 000 токенов в одной инъекции, слой шлюза мог зависнуть на неопределённый срок вместо возврата чистой ошибки. Это проявлялось как видимое зависание OpenClaw, а не явная ошибка контекста. Решением стала оптимизация конвейера инъекции контекста для корректной обработки больших полезных нагрузок. Если ваш OpenClaw, кажется, зависает при чтении файлов или выполнении инструментов, это может быть причиной, и обновление до последней версии включает исправление.

Issue #5771: переполнение контекста в новых сессиях. Пожалуй, самый контринтуитивный баг: некоторые пользователи получали context_length_exceeded в совершенно новой сессии, ещё не отправив ни одного сообщения. Причиной была инъекция поиска по памяти, загружающая массивные объёмы исторического контекста при инициализации сессии. Обходной путь -- отключение поиска по памяти (memorySearch.enabled: false в конфигурации), а постоянное исправление включает пакетную обработку эмбеддингов памяти с соблюдением лимита в 8 192 токена на инъекцию, как решено в исправлении buildEmbeddingBatches для связанной Issue #5696.

Issue #9157: инъекция рабочего пространства тратит 93,5% токенов впустую. Эта проблема документировала серьёзную неэффективность, когда файлы рабочего пространства повторно внедрялись в каждое сообщение, потребляя примерно 35 600 токенов на сообщение в сложных рабочих пространствах. В многосообщенных диалогах это означало, что 93,5% токенов, потраченных на инъекцию рабочего пространства, были избыточны -- одни и те же файлы пересылались снова и снова. Исправление ввело условную загрузку, которая внедряет файлы рабочего пространства только при их изменении с момента последней инъекции. Если вы используете старую версию и имеете сложное рабочее пространство, один этот баг может быть ответственным за большинство ваших проблем с переполнением контекста. Обновление до последней версии или уменьшение размера файлов рабочего пространства -- оба варианта являются эффективными обходными путями.

Общий подход к устранению нерешённых ошибок контекста. Если ни одна из известных проблем выше не соответствует вашей ситуации, следуйте этому систематическому подходу. Во-первых, проверьте версию OpenClaw командой openclaw --version и обновите, если вы не на последнем релизе. Во-вторых, изучите логи по пути ~/.openclaw/logs/ на предмет подробных сообщений об ошибках, которые могут раскрыть конкретную точку сбоя. В-третьих, попробуйте воспроизвести проблему с минимальной конфигурацией -- создайте свежий проект без файлов рабочего пространства и проверьте, сохраняется ли ошибка. Если да, проблема, скорее всего, на стороне модели, а не конфигурации. Если ошибка исчезает с минимальной конфигурацией, постепенно возвращайте файлы рабочего пространства и настройки, пока не определите конкретный элемент, вызывающий переполнение. Этот метод двоичного поиска -- самый быстрый способ изолировать проблемы контекста, связанные с конфигурацией.

Часто задаваемые вопросы

Что вызывает context_length_exceeded в OpenClaw?

Ошибка возникает, когда общее количество токенов в запросе -- включая системный промпт (~9 600 токенов), схемы инструментов (~8 000 токенов), файлы рабочего пространства (переменный объём, до 35 600 токенов), историю диалога (растёт со временем) и результаты поиска по памяти -- превышает максимальное контекстное окно модели ИИ. Наиболее частая причина -- просто длинный диалог, в котором история накопилась сверх ёмкости модели. Реже это может быть вызвано инъекцией больших файлов рабочего пространства или известными багами, выдающими ложные срабатывания.

Как увеличить контекстное окно OpenClaw?

Вы не можете увеличить врождённый размер контекстного окна модели, но можете эффективно получить больше полезного контекста: (1) перейти на модель с большим окном (Gemini 2.0 Flash предлагает 1M токенов, модели Claude -- 200K), (2) уменьшить инъекцию файлов рабочего пространства через bootstrapMaxChars, (3) отключить поиск по памяти для высвобождения токенов и (4) настроить более агрессивную компактизацию с более высокими значениями reserveTokens. Сочетание этих подходов может эффективно удвоить или утроить ваш полезный контекст по сравнению с настройками по умолчанию.

Что такое компактизация OpenClaw и теряются ли данные?

Компактизация -- это встроенный механизм OpenClaw для суммирования истории диалога. При срабатывании (автоматически или через /compact) система создаёт сжатую сводку более старых частей диалога, сохраняя при этом самые последние сообщения дословно. Сводка фиксирует ключевые решения, расположение файлов и важный контекст, но отбрасывает многословные промежуточные шаги. Результат компактизации сохраняется в файле сессии JSONL, поэтому он сохраняется между перезапусками. Вы теряете дословные детали ранних обменов, но существенная информация сохраняется в сводке.

Как полностью очистить память OpenClaw?

Для полной очистки памяти и начала с чистого листа используйте /reset, который очищает и историю диалога, и память, специфичную для сессии. Для очистки только диалога с сохранением памяти используйте /new. Если вы хотите очистить саму базу данных хранимой памяти, удалите файлы памяти в ~/.openclaw/memory/. Обратите внимание, что очистка памяти необратима -- отмены для удалённых записей памяти не существует.

Почему context_length_exceeded возникает в новой сессии OpenClaw?

Обычно это вызвано одной из двух причин: (1) инъекция поиска по памяти загружает слишком много исторического контекста при инициализации сессии (см. Issue #5771) или (2) чрезвычайно большие файлы рабочего пространства потребляют большую часть контекстного окна до начала любого диалога. Исправление для переполнения, связанного с памятью, -- установка memorySearch.enabled: false, а исправление для переполнения, связанного с рабочим пространством, -- уменьшение bootstrapMaxChars до меньшего значения, например 10 000 символов. Оба изменения вносятся в файл конфигурации openclaw.json.

![Исправление context_length_exceeded в OpenClaw: полное руководство по устранению [2026]](/posts/ru/openclaw-context-length-exceeded/img/cover.png)