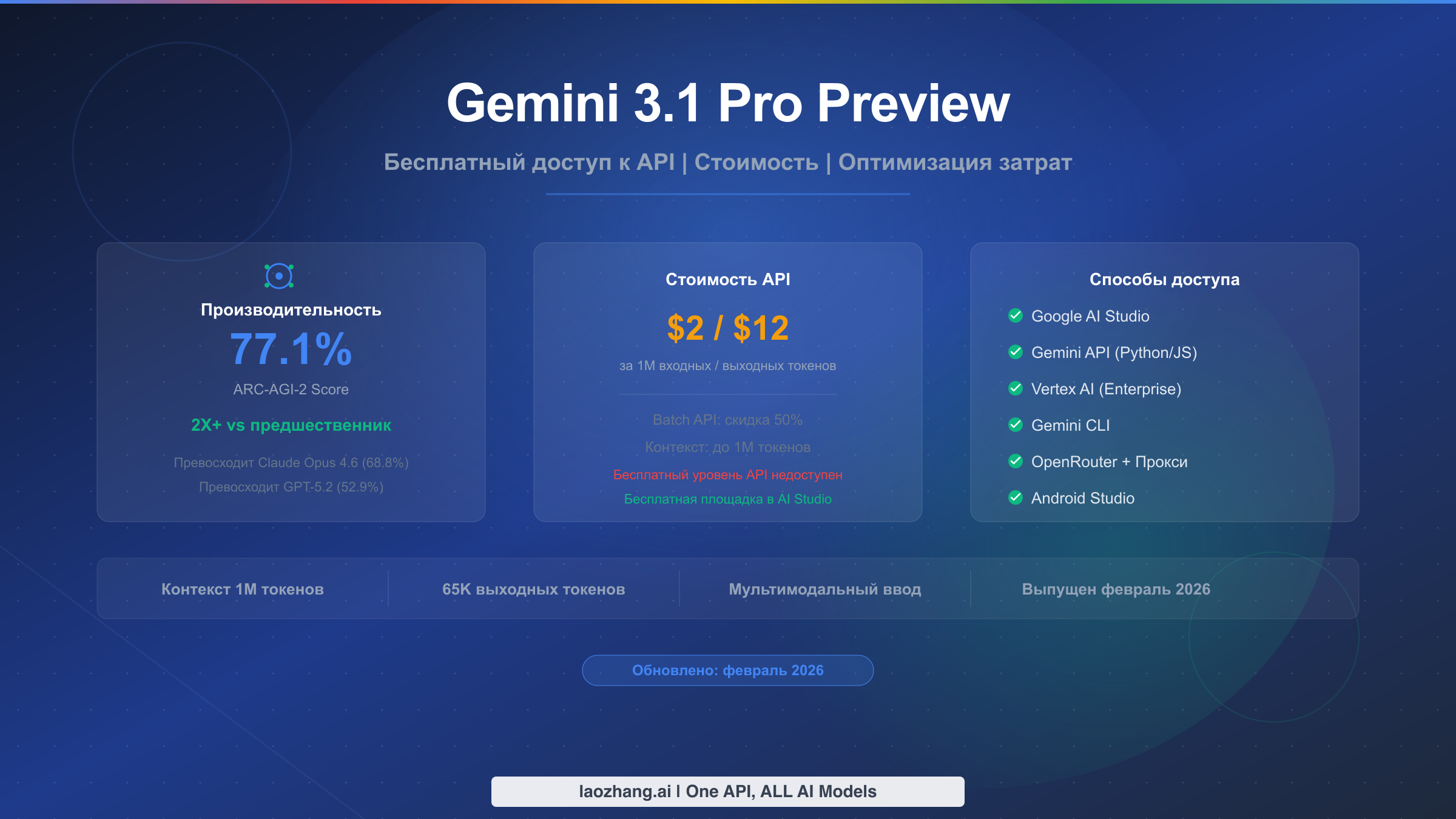

Gemini 3.1 Pro Preview — новейшая фронтирная модель рассуждений от Google, выпущенная 19 февраля 2026 года, — доступна для бесплатного тестирования в Google AI Studio, однако бесплатного API-уровня не предусматривает. Gemini API взимает $2,00 за миллион входных токенов и $12,00 за миллион выходных токенов для Gemini 3.1 Pro Preview. Модель достигает 77,1% на бенчмарке ARC-AGI-2, что более чем вдвое превышает показатель предшественника — 31,1%. В этом руководстве рассмотрены все способы доступа к 3.1 Pro — от бесплатного тестирования в AI Studio до настройки платного API и стратегий оптимизации расходов, позволяющих сократить ваш счёт на 50% и более.

Краткое содержание

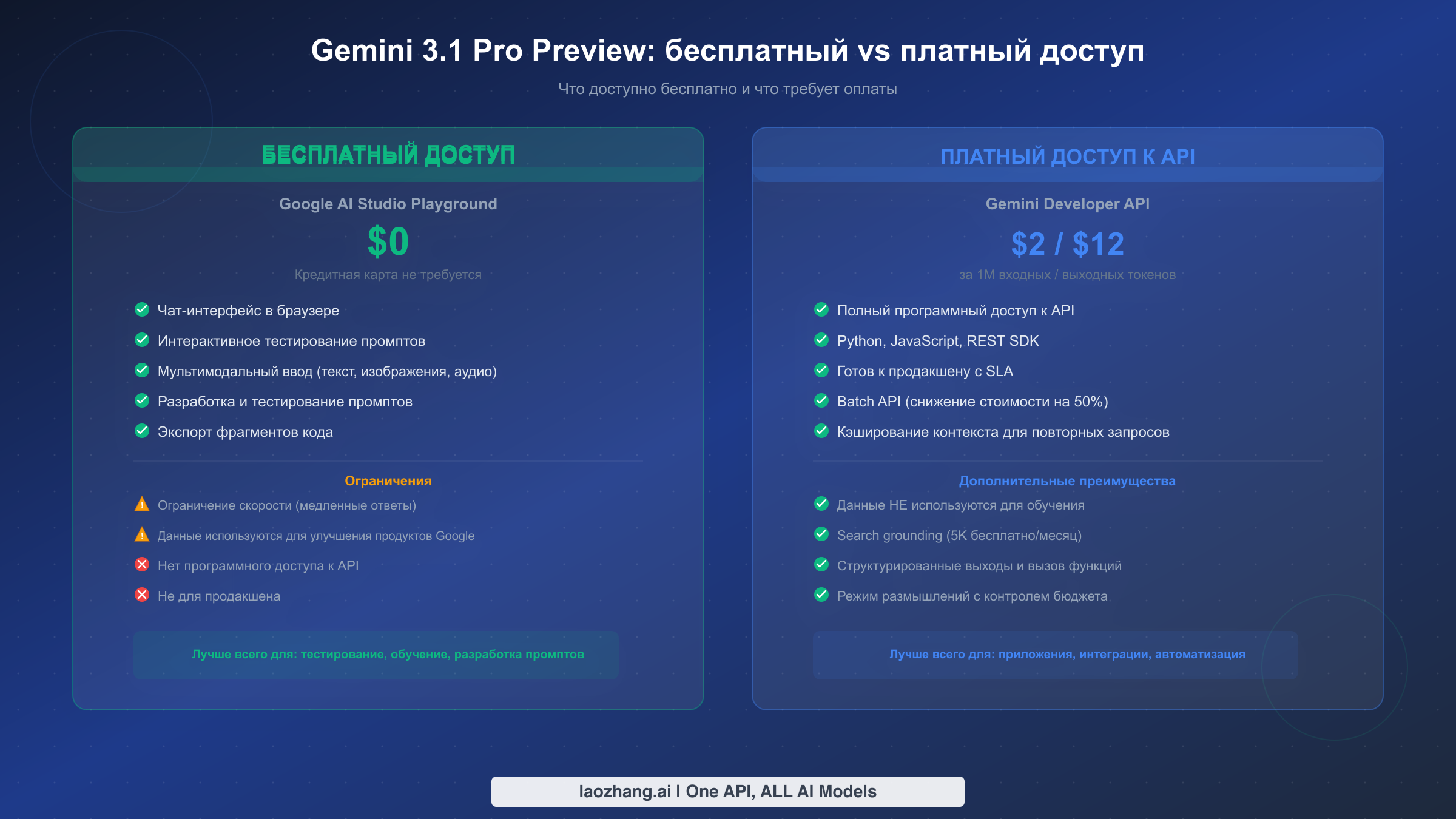

- Бесплатный доступ существует, но ограничен: вы можете тестировать Gemini 3.1 Pro Preview бесплатно в браузерной песочнице Google AI Studio. Кредитная карта не требуется, но программный API-доступ недоступен.

- Тарифы API: $2,00 за миллион входных токенов, $12,00 за миллион выходных токенов (включая токены «размышления»). Бесплатный API-уровень для этой модели отсутствует.

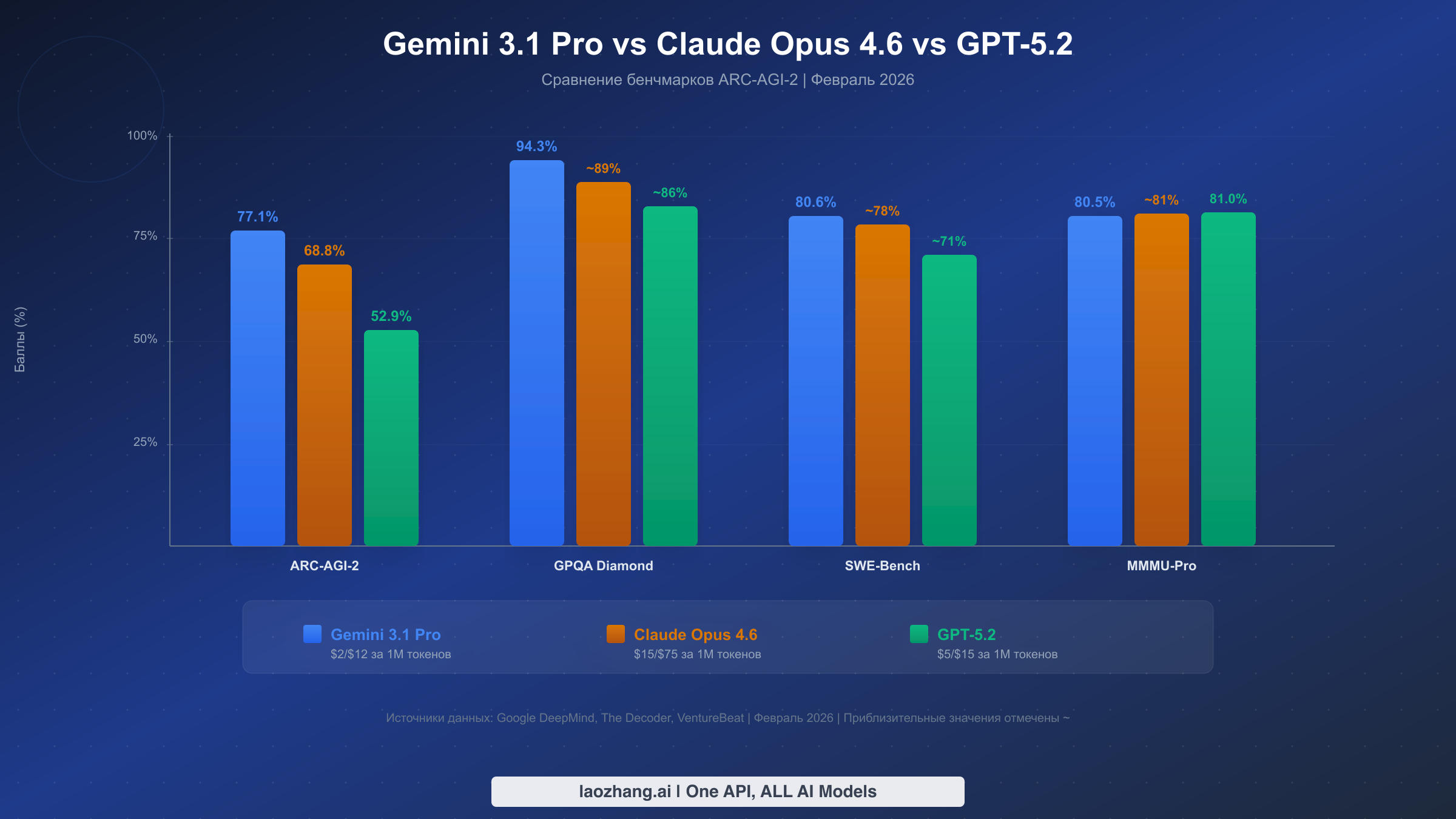

- Лидер по производительности: 77,1% на ARC-AGI-2, опережая Claude Opus 4.6 (68,8%) и GPT-5.2 (52,9%). Результат 94,3% на GPQA Diamond и 80,6% на SWE-Bench Verified.

- Оптимизация расходов: используйте Batch API для скидки 50%, кэширование контекста для экономии до 90% на повторяющихся запросах и управление бюджетом «размышлений» для контроля затрат на выходные токены.

- Несколько способов доступа: Google AI Studio (бесплатно), Gemini API (платно), Vertex AI (корпоративный), OpenRouter (агрегатор) и сторонние прокси-сервисы.

Что такое Gemini 3.1 Pro Preview и почему разработчики в восторге

Google DeepMind представил Gemini 3.1 Pro Preview 19 февраля 2026 года, позиционируя эту модель как наиболее мощную модель рассуждений в семействе Gemini. Релиз мгновенно вызвал ажиотаж в сообществе разработчиков, главным образом потому, что модель набрала 77,1% на бенчмарке ARC-AGI-2 — тесте, специально разработанном для измерения способности к общему рассуждению в AI-системах. Чтобы оценить значимость этого числа, достаточно сказать, что Gemini 3 Pro набрал на том же бенчмарке всего 31,1%, то есть версия 3.1 более чем удвоила результат предшественника в рамках того, что Google описывает как «скачок одного поколения». Такого рода улучшения редки в разработке AI, где прирост бенчмарков обычно измеряется однозначными процентными пунктами.

Результат ARC-AGI-2 имеет значение, поскольку он ставит Gemini 3.1 Pro Preview впереди обоих основных конкурентов. Claude Opus 4.6, флагманская модель рассуждений от Anthropic, набирает на том же тесте 68,8%, а GPT-5.2 от OpenAI — 52,9% (по данным The Decoder, февраль 2026). Помимо рассуждений, модель также демонстрирует выдающиеся результаты в области научных знаний с показателем 94,3% на GPQA Diamond и в программной инженерии с результатом 80,6% на SWE-Bench Verified (карточка модели Google DeepMind, февраль 2026). Эти цифры свидетельствуют о модели, которая не просто теоретически мощна, но и практически полезна для реальных рабочих процессов разработчиков, включая генерацию кода, отладку и технический анализ.

Что делает Gemini 3.1 Pro Preview особенно интересной с практической точки зрения — это сочетание производительности и объёма контекстного окна. Модель поддерживает контекстное окно в 1 048 576 токенов — это примерно эквивалентно обработке целой кодовой базы, книги объёмом в 700 страниц или нескольких часов аудио в одном промпте. Максимальный объём вывода составляет 65 536 токенов, а модель принимает мультимодальные входные данные, включая текст, изображения, видео, аудио и PDF-документы (ai.google.dev, февраль 2026). Для разработчиков, которые регулярно работают с большими коллекциями документов или анализируют обширные кодовые базы, это контекстное окно устраняет необходимость в сложных стратегиях разбивки на фрагменты, которые требуются другим моделям. Модель также оснащена режимом «размышления», при котором она пошагово рассуждает перед генерацией ответа — подход, аналогичный используемому Claude и моделями серии o от OpenAI, — однако реализация Google позволяет разработчикам устанавливать явные бюджеты размышлений для контроля расходов.

Время выпуска Gemini 3.1 Pro Preview примечательно в более широком контексте индустрии AI. Появившись всего через несколько недель после релиза GPT-5.2 от OpenAI и обновления цикла Claude Opus 4.6 от Anthropic, модель представляет собой агрессивный шаг Google по возвращению технического лидерства в области возможностей фронтирных моделей. Пометка «Preview» в названии модели указывает на то, что это ещё не финальный продакшн-релиз — Google обычно использует такое обозначение для моделей, которые функционально завершены, но могут получить дополнительную оптимизацию перед получением статуса стабильных. Для разработчиков это означает, что модель полностью функциональна для продакшн-использования уже сегодня, но следует отслеживать объявления Google об устаревании моделей и быть готовым обновить идентификатор модели при выходе стабильной версии. Судя по предыдущему опыту Google, переход от preview к стабильной версии обычно занимает 2-4 месяца и, как правило, включает лишь смену ID модели без критических изменений API.

Как бесплатно протестировать Gemini 3.1 Pro Preview в Google AI Studio

Самый распространённый вопрос, который задают разработчики, — можно ли использовать Gemini 3.1 Pro Preview бесплатно. Честный ответ требует разграничения, которое большинство статей не проводит достаточно чётко: вы можете взаимодействовать с моделью бесплатно через веб-песочницу Google AI Studio, но бесплатного API-уровня для программного доступа не существует. Понимание этого различия критически важно, прежде чем вы потратите время на какой-либо план интеграции. Google AI Studio на сайте aistudio.google.com предоставляет чат-интерфейс, где можно вводить промпты, загружать изображения и тестировать возможности модели без создания платёжного аккаунта или ввода данных кредитной карты. Эта среда-песочница действительно полезна для инженерии промптов, сравнения поведения модели при различных конфигурациях и практического знакомства с возможностями рассуждения модели перед переходом на платный доступ.

Чтобы начать бесплатно работать с Google AI Studio, перейдите на сайт и войдите в систему с любым аккаунтом Google. Выберите «Gemini 3.1 Pro Preview» из выпадающего списка моделей — она должна быть доступна с 19 февраля 2026 года. Вы можете сразу начать тестировать промпты, настраивать системные инструкции и экспериментировать с параметрами temperature и top-p. Песочница поддерживает мультимодальные входные данные, поэтому можно загружать изображения, документы и даже аудиофайлы для проверки возможностей понимания модели. Также можно экспортировать промпты в виде фрагментов кода на Python, JavaScript или в формате cURL, что даёт вам преимущество при переходе на платный API. Бесплатная песочница также включает кнопку «Get code», которая генерирует готовые к использованию API-вызовы на основе вашей текущей конфигурации промпта.

Однако бесплатный доступ через AI Studio имеет существенные ограничения, о которых следует знать, прежде чем на него полагаться. Ответы в бесплатном уровне ограничены по частоте запросов и могут быть медленнее, чем платные API-вызовы, особенно в периоды высокой нагрузки после недавнего выпуска модели. Что ещё более существенно, условия обслуживания Google гласят, что данные, отправленные через бесплатную песочницу AI Studio, могут использоваться для улучшения продуктов Google, а значит, вы никогда не должны вводить через этот канал конфиденциальную, проприетарную или секретную информацию. Программный API-доступ через бесплатный уровень невозможен — вы не можете выполнять HTTP-запросы к модели или интегрировать её в свои приложения без перехода на платный Gemini API. Для разработчиков, которым нужны варианты бесплатного уровня Gemini API, отметим, что хотя более старые модели, такие как Gemini 2.5 Flash, по-прежнему предлагают бесплатный API-доступ с ограничением по частоте запросов, модель 3.1 Pro Preview доступна только через платные тарифы. Если ваша цель — продакшн-интеграция, автоматизированные рабочие процессы или любой сценарий использования, требующий API-вызовов, вам потребуется настроить биллинг.

Один из практических рабочих процессов, который выбирают многие разработчики, — начать с AI Studio для инженерии промптов и оценки, а затем перейти на платный API, когда подход будет проверен. AI Studio позволяет сохранять и организовывать шаблоны промптов, сравнивать ответы при различных настройках temperature и экспортировать рабочие конфигурации в виде кода — и всё это бесплатно. Такой подход «тестируй бесплатно, развёртывай платно» особенно эффективен, поскольку позволяет итерировать системные промпты и примеры few-shot в среде песочницы, сокращая количество платных API-вызовов, необходимых на этапе разработки. Функция «Get code» в AI Studio генерирует полные фрагменты на Python или JavaScript, включающие вашу точную конфигурацию промпта, что делает переход от бесплатного тестирования к платной интеграции практически бесшовным.

Настройка API Gemini 3.1 Pro Preview — быстрый старт для разработчиков

Для начала работы с платным API Gemini 3.1 Pro Preview необходимы три вещи: API-ключ Google Cloud или AI Studio, SDK Google Generative AI, установленный в вашей среде разработки, и платёжный аккаунт, привязанный к вашему проекту Google Cloud. Процесс настройки прост и обычно занимает не более пяти минут у разработчиков, знакомых с API-интеграциями. Начните с перехода на aistudio.google.com, нажмите «Get API key» в верхней навигации и либо создайте новый API-ключ, либо выберите существующий проект Google Cloud. Убедитесь, что биллинг активен — в отличие от некоторых моделей Gemini, предлагающих бесплатные уровни, Gemini 3.1 Pro Preview требует биллинга с первого API-вызова.

Для разработчиков на Python установите официальный SDK командой pip install google-genai и настройте свой первый API-вызов с помощью следующего кода. Этот пример демонстрирует базовый запрос генерации текста с использованием модели Gemini 3.1 Pro Preview и включённой функцией «размышления»:

pythonfrom google import genai client = genai.Client(api_key="YOUR_API_KEY") response = client.models.generate_content( model="gemini-3.1-pro-preview", contents="Explain the key differences between TCP and UDP protocols, including when to use each one.", config={ "thinking_config": {"thinking_budget": 2048} } ) print(response.text)

Для разработчиков на JavaScript и Node.js установите SDK командой npm install @google/genai и используйте эквивалентную настройку. JavaScript SDK следует аналогичному паттерну, что упрощает переключение между языками, если вы работаете в полиглотной среде:

javascriptimport { GoogleGenAI } from "@google/genai"; const ai = new GoogleGenAI({ apiKey: "YOUR_API_KEY" }); async function main() { const response = await ai.models.generateContent({ model: "gemini-3.1-pro-preview", contents: "Explain the key differences between TCP and UDP protocols, including when to use each one.", config: { thinkingConfig: { thinkingBudget: 2048 } } }); console.log(response.text); } main();

При работе с API есть несколько практических деталей, которые стоит учитывать. Параметр thinking_budget контролирует, сколько токенов модель может использовать для внутреннего рассуждения перед генерацией ответа — слишком низкое значение может снизить качество рассуждений, тогда как слишком высокое увеличивает расходы на выходные токены, поскольку токены «размышления» тарифицируются по той же ставке, что и выходные токены ($12,00 за миллион, страница тарифов ai.google.dev, февраль 2026). Хорошей отправной точкой является 2 048 токенов для простых вопросов и 8 192 или выше для сложных задач рассуждения. Вам также следует учитывать ограничения по частоте запросов и квоты для модели 3.1 Pro Preview, которые могут отличаться от других моделей Gemini из-за статуса preview. Для обработки ошибок оборачивайте API-вызовы в блоки try-catch и реализуйте экспоненциальную задержку при ошибках 429 (превышение лимита запросов) и 503 (сервис недоступен), которые часто встречаются в периоды высокого трафика сразу после запуска модели.

Помимо базовой генерации текста, API поддерживает структурированный вывод через режим JSON, что критически важно для создания надёжных приложений. Указав JSON-схему в конфигурации запроса, вы можете заставить модель возвращать ответы в предсказуемом формате, что позволяет легко парсить вывод программно без ненадёжных регулярных выражений или строковых манипуляций. API также поддерживает вызов функций (function calling), когда вы определяете набор инструментов (функций), которые модель может вызывать в процессе генерации ответа. Это позволяет создавать агентов, способных выполнять поиск в базах данных, вызывать внешние API или производить вычисления в рамках процесса рассуждения. Для разработчиков, создающих продакшн-приложения, эти возможности превращают Gemini 3.1 Pro Preview из простого генератора текста в программируемый движок рассуждений, который можно интегрировать в сложные рабочие процессы. Вариант gemini-3.1-pro-preview-customtools специально оптимизирован для сценариев с вызовом функций и может обеспечивать более точный выбор инструментов по сравнению со стандартным идентификатором модели.

Gemini 3.1 Pro vs Claude Opus 4.6 vs GPT-5.2 — производительность и ценность

Выбор между тремя ведущими фронтирными моделями в феврале 2026 года требует рассмотрения не только отдельных результатов бенчмарков, но и полной картины: производительности при различных типах задач, структуры ценообразования и соотношения цены к производительности. Gemini 3.1 Pro Preview лидирует по общему рассуждению (77,1% ARC-AGI-2), научным знаниям (94,3% GPQA Diamond) и программной инженерии (80,6% SWE-Bench Verified). Claude Opus 4.6 лидирует на Humanity's Last Exam с результатом 53,1% против 44,4% у Gemini, что говорит о более сильной производительности на крайне сложных междисциплинарных вопросах. GPT-5.2 лидирует на MMMU-Pro (81,0% против 80,5% у Gemini), что указывает на небольшое преимущество в задачах мультимодального понимания. Различия на некоторых бенчмарках настолько малы, что реальная производительность может варьироваться в зависимости от конкретного сценария использования и подхода к инженерии промптов.

Сравнение тарифов рисует гораздо более чёткую картину того, где заключается ценность. Gemini 3.1 Pro Preview стоит $2,00 за миллион входных токенов и $12,00 за миллион выходных токенов (ai.google.dev, февраль 2026). Claude Opus 4.6 обходится в $15,00 за миллион входных токенов и $75,00 за миллион выходных токенов — то есть в 7,5 раз дороже на входе и в 6,25 раз дороже на выходе. GPT-5.2 занимает среднюю позицию — $5,00 за миллион входных токенов и $15,00 за миллион выходных токенов. Если рассчитать метрику «цена за единицу производительности» по результатам ARC-AGI-2, Gemini 3.1 Pro показывает примерно $0,18 за процентный пункт (при использовании стоимости выходных токенов как доминирующей), тогда как Claude Opus 4.6 стоит около $1,09 за процентный пункт — более чем в 6 раз дороже при более низкой производительности на задачах рассуждения. Для команд, выполняющих тысячи API-вызовов ежедневно, эта разница в стоимости оборачивается ощутимой экономией без потери качества.

| Характеристика | Gemini 3.1 Pro Preview | Claude Opus 4.6 | GPT-5.2 |

|---|---|---|---|

| ARC-AGI-2 | 77,1% | 68,8% | 52,9% |

| GPQA Diamond | 94,3% | ~89% | ~86% |

| SWE-Bench Verified | 80,6% | ~78% | ~71% |

| MMMU-Pro | 80,5% | ~81% | 81,0% |

| Стоимость входа / 1M | $2,00 | $15,00 | $5,00 |

| Стоимость выхода / 1M | $12,00 | $75,00 | $15,00 |

| Контекстное окно | 1M токенов | 200K токенов | 128K токенов |

| Максимальный вывод | 65K токенов | 32K токенов | 16K токенов |

| Batch API | скидка 50% | Недоступен | Скидка 50% |

Тем не менее, бенчмарки не рассказывают всю историю. Claude Opus 4.6 по-прежнему высоко ценится за точность выполнения инструкций, нюансированное поведение в области безопасности и стабильность в агентных рабочих процессах программирования. GPT-5.2 выигрывает от зрелой экосистемы OpenAI с обширными интеграциями сторонних инструментов и крупным сообществом разработчиков. Ваш выбор должен зависеть от конкретных требований: если для вас наиболее важны чистая производительность рассуждений и экономическая эффективность, Gemini 3.1 Pro Preview предлагает лучшую ценность в феврале 2026 года. Если вам нужны специфические качества, такие как надёжность Claude в сложных агентных задачах или экосистема GPT, премиальная цена может быть оправдана. Многие разработчики применяют мультимодельную стратегию, используя Gemini для чувствительной к стоимости массовой обработки и модель-конкурент для специализированных задач. Чтобы понять, как сравниваются модели Gemini 3 по всему семейству, включая варианты Flash, ознакомьтесь с нашим специальным руководством по сравнению.

Как сократить расходы на API Gemini 3.1 Pro на 50% и более

Хотя Gemini 3.1 Pro Preview и так является наиболее доступной фронтирной моделью рассуждений, вы можете значительно сократить расходы с помощью трёх официальных стратегий оптимизации: Batch API, кэширование контекста и управление бюджетом «размышлений». Эти техники можно комбинировать, и хорошо оптимизированный конвейер способен снизить эффективную стоимость на 60-80% по сравнению со стандартными тарифами, делая 3.1 Pro Preview конкурентоспособной с моделями среднего уровня, такими как Gemini Flash, в пересчёте на одну задачу.

Batch API — это простейшая оптимизация для внедрения. Вместо синхронной отправки запросов с мгновенными ответами вы объединяете несколько промптов в одно асинхронное задание и получаете результаты в течение 24 часов. Google вознаграждает такое терпение скидкой 50% на все затраты по токенам — ваша эффективная цена снижается до $1,00 за миллион входных токенов и $6,00 за миллион выходных токенов (ai.google.dev, февраль 2026). Batch API идеально подходит для любых рабочих нагрузок, не требующих ответа в реальном времени: конвейеры анализа документов, массовая генерация контента, разметка датасетов, проверка кода по крупным репозиториям и задания для ночной обработки. Реализация требует минимальных изменений кода — вы подготавливаете файл JSONL с запросами, отправляете его на пакетную конечную точку и опрашиваете статус завершения. Для многих команд перевод 40-60% рабочей нагрузки на пакетную обработку сокращает ежемесячный счёт почти вдвое без какого-либо снижения качества.

Кэширование контекста представляет ещё более значительную возможность для снижения затрат при повторяющихся рабочих нагрузках. Когда вы отправляете один и тот же объёмный системный промпт, документ или справочный материал в нескольких API-вызовах, кэширование контекста позволяет сохранить этот контент единожды и ссылаться на него в последующих запросах. Кэшированные входные токены стоят $0,20 за миллион (против $2,00 стандартных) — снижение на 90% (тарифы ai.google.dev, февраль 2026). Кэш имеет стоимость хранения $4,50 за миллион токенов в час, поэтому экономика наиболее выгодна при частых обращениях к одному и тому же контексту в короткий промежуток времени. Например, если вы создаёте бота поддержки клиентов, ссылающегося на 100-страничное руководство по продукту, кэширование этого руководства и выполнение 1 000 запросов к нему будет стоить примерно $0,02 за кэшированный контекст на запрос, против $0,20 без кэширования — десятикратная экономия только на стороне входных данных.

Третья и наиболее часто упускаемая из виду оптимизация — это управление бюджетом «размышлений». Поскольку стоимость выходных токенов Gemini 3.1 Pro Preview ($12,00 за миллион) включает токены «размышления», объём внутренних рассуждений модели напрямую влияет на ваш счёт. По умолчанию модель может использовать тысячи токенов «размышления» даже для простых вопросов. Установка параметра thinking_budget позволяет контролировать это: используйте 1 024-2 048 токенов для простых задач вроде форматирования или перевода, 4 096-8 192 для умеренного рассуждения и 16 384+ только для сложных многоэтапных задач. На практике большинство запросов не выигрывают от более чем 4 096 токенов «размышления», и снижение значения по умолчанию может сократить расходы на выходные данные на 30-50% при типичных нагрузках. Вы также можете комбинировать все три стратегии: пакетная обработка с кэшированным контекстом и контролируемыми бюджетами «размышлений» может снизить эффективную стоимость за запрос на 70-80%, делая Gemini 3.1 Pro Preview исключительно экономически эффективным для масштабных приложений.

Чтобы наглядно продемонстрировать эффективность этих оптимизаций, рассмотрим компанию, обрабатывающую 100 000 обращений в службу поддержки ежемесячно через Gemini 3.1 Pro Preview. При стандартных тарифах со средним показателем 800 входных токенов и 2 000 выходных токенов (включая «размышления») на обращение ежемесячная стоимость составила бы приблизительно $160,00 за входные данные плюс $2 400,00 за выходные, итого $2 560,00. Перевод 60% неприоритетных обращений на пакетную обработку экономит $768,00. Добавление кэширования контекста для общей документации по продукту (используемой для всех обращений) экономит ещё $120,00 на входных затратах. Снижение бюджета «размышлений» с настроек по умолчанию до 2 048 токенов для простых задач классификации (40% обращений) экономит примерно $480,00 на выходных затратах. Итоговая оптимизированная стоимость снижается примерно до $1 192,00 — сокращение на 53% от первоначальной оценки. Для команд, масштабирующихся до миллионов API-вызовов, эти оптимизации превращают Gemini 3.1 Pro Preview из «дорогой фронтирной модели» в «конкурентоспособную по стоимости альтернативу моделям среднего уровня».

Альтернативные способы доступа к API Gemini 3.1 Pro Preview

Помимо прямого API от Google, существует несколько альтернативных путей доступа к Gemini 3.1 Pro Preview, каждый с различными компромиссами по цене, конфиденциальности, сложности настройки и поддержке функций. Ваш выбор зависит от конкретной ситуации — нужна ли вам мультимодельная гибкость, соответствие корпоративным требованиям, региональный доступ или упрощённый биллинг. Понимание этих вариантов гарантирует, что вы выберете способ доступа, наилучшим образом отвечающий вашим техническим требованиям и организационным ограничениям.

Google AI Studio и Gemini API (прямой доступ) — рекомендуемая отправная точка для большинства индивидуальных разработчиков и небольших команд. Вы получаете официальный SDK, полную поддержку функций, включая режим «размышления» и кэширование контекста, официальные лимиты запросов и гарантию того, что ваши данные не используются для обучения при доступе через платный API. Настройка занимает менее 5 минут, и вы платите ровно по опубликованным тарифам без наценки. Основное ограничение — привязка к одному поставщику: если впоследствии вы захотите сравнить результаты Gemini с Claude или GPT, потребуются отдельные API-интеграции для каждого.

Vertex AI через Google Cloud — это корпоративный путь. Он предлагает ту же модель по тем же базовым тарифам, но добавляет корпоративные функции: гарантии SLA, изоляцию данных VPC-SC, управление доступом на основе IAM, шифрование CMEK и сертификаты соответствия SOC 2 / ISO 27001. Компромиссом является сложность настройки — необходим проект Google Cloud, правильная конфигурация IAM и знакомство с SDK Vertex AI. Для организаций, которым требуется документация соответствия, гарантии размещения данных или интеграция с другими сервисами Google Cloud (BigQuery, Cloud Storage, Cloud Functions), Vertex AI является подходящим выбором. Настройка обычно занимает от 30 минут до часа для новичков в Google Cloud.

OpenRouter — мультимодельный агрегатор, предоставляющий единый API для десятков AI-моделей, включая Gemini 3.1 Pro Preview. Тарифы обычно идентичны или очень близки к прямым тарифам Google (примерно $2/$12 за миллион токенов), при этом OpenRouter берёт небольшую маржу или пропускает по себестоимости. Основное преимущество — опыт разработчика: один API-ключ, один SDK и единообразное форматирование запросов/ответов для всех поддерживаемых моделей. Это делает переключение между Gemini, Claude и GPT в вашем коде тривиальным — достаточно изменить параметр модели. Для команд, оценивающих несколько моделей или создающих приложения с резервными поставщиками, OpenRouter устраняет необходимость поддерживать множественные интеграции SDK.

Мультимодельные сервисы-агрегаторы, такие как laozhang.ai, предоставляют ещё один вариант, особенно для разработчиков, которым нужен доступ к множеству AI-моделей через единую конечную точку API. Такие сервисы могут предлагать конкурентные цены и упрощённый биллинг, поддерживая десятки моделей, включая Gemini 3.1 Pro Preview. Для разработчиков, ищущих доступный Gemini API для изображений наряду с текстовыми моделями, платформы-агрегаторы часто объединяют обе возможности. Ключевой момент при работе с любым сторонним сервисом — проверка их политик обработки данных, гарантий доступности и того, передают ли они полные возможности модели (режим «размышления», кэширование контекста, стриминг) или работают с ограниченным набором функций. Для подробной документации по доступным моделям и примерам интеграции обратитесь к документации API.

При выборе между этими способами доступа решение обычно сводится к трём факторам: сколько моделей вам необходимо, какие требования к соответствию вы предъявляете и какой объём операционных накладных расходов вы готовы нести. Для индивидуального разработчика, создающего побочный проект, прямой API Google — самый простой выбор: один API-ключ, официальная документация и прозрачный биллинг. Для стартапа, оценивающего несколько моделей перед выбором одной, агрегатор вроде OpenRouter экономит значительное время интеграции, предоставляя единую API-поверхность для всех поставщиков. Для предприятия с регуляторными требованиями Vertex AI — единственный вариант, предоставляющий сертификаты соответствия и гарантии изоляции данных, которые требуют юридические отделы. Хорошая новость в том, что сама модель Gemini 3.1 Pro Preview идентична при всех способах доступа — вы получаете ту же производительность в 77,1% ARC-AGI-2 независимо от того, обращаетесь ли вы к ней через Google напрямую, Vertex AI или сторонний агрегатор.

Тарифы API Gemini 3.1 Pro Preview — полный разбор

Для полного понимания структуры ценообразования Gemini 3.1 Pro Preview необходимо выйти за рамки заголовочных цифр $2/$12. Модель использует многоуровневую систему тарификации в зависимости от длины контекста, с различными ставками для стандартных и кэшированных токенов, а также с важными нюансами относительно токенов «размышления», которые могут существенно повлиять на ваши фактические расходы. Все данные о тарифах, приведённые ниже, были верифицированы по официальной странице тарифов Google AI 20 февраля 2026 года.

| Категория тарификации | Стандартный (<=200k контекст) | Длинный контекст (>200k) |

|---|---|---|

| Входные токены | $2,00 / 1M | $4,00 / 1M |

| Выходные токены (вкл. «размышления») | $12,00 / 1M | $18,00 / 1M |

| Кэшированные входные токены | $0,20 / 1M | $0,40 / 1M |

| Хранение кэша | $4,50 / 1M токенов / час | $4,50 / 1M токенов / час |

| Batch API вход | $1,00 / 1M | $2,00 / 1M |

| Batch API выход | $6,00 / 1M | $9,00 / 1M |

| Поисковое заземление | 5 000 бесплатно/мес, далее $14/1 000 | Аналогично |

Многоуровневая тарификация по контексту означает, что промпты, превышающие 200 000 токенов, стоят вдвое дороже стандартной ставки — $4,00 за миллион входных и $18,00 за миллион выходных. Этот порог важен для планирования: если ваш сценарий использования предполагает обработку очень больших документов или кодовых баз, выходящих за 200k токенов, ваши фактические расходы будут выше заголовочных цифр. Большинство типичных случаев использования API укладываются в менее чем 200k токенов на запрос, но разработчикам, работающим с полным контекстным окном Gemini в 1M, следует планировать бюджет соответственно. Одна из практических стратегий — агрессивно использовать кэширование контекста при работе с большими документами: даже с учётом стоимости хранения $4,50 за миллион токенов в час, кэшированные токены по $0,20-$0,40 за миллион значительно дешевле, чем повторная обработка того же контента по $2,00-$4,00 за миллион при каждом запросе.

Для иллюстрации реальных затрат рассмотрим три типичных сценария использования разного масштаба. Чат-бот, обрабатывающий 10 000 диалогов в день со средним показателем 500 входных токенов и 1 000 выходных токенов (включая «размышления») на диалог, будет стоить примерно $10,00 за вход ($2,00 x 5M токенов) плюс $120,00 за выход ($12,00 x 10M токенов), итого около $130,00 в день или примерно $3 900 в месяц. Использование Batch API для диалогов, не требующих реального времени, сократит эту сумму примерно до $1 950 в месяц. Конвейер проверки кода, обрабатывающий 500 файлов в день с 2 000 входных токенов и 3 000 выходных токенов на файл, обойдётся примерно в $2,00 за вход плюс $18,00 за выход, итого около $20,00 в день или $600 в месяц — вполне в рамках бюджета большинства команд разработки. Система анализа документов, обрабатывающая 50 крупных PDF (50 000 токенов каждый) в день с кэшированным контекстом, будет стоить менее $50 в месяц при сочетании кэширования контекста с пакетной обработкой, что на порядки дешевле затрат на ручную проверку.

Одна важная деталь, которую многие сравнения тарифов упускают, — это роль поискового заземления (search grounding) в Gemini 3.1 Pro Preview. Google предоставляет 5 000 запросов заземления в месяц бесплатно, после чего дополнительные запросы стоят $14,00 за 1 000 запросов (ai.google.dev, февраль 2026). Поисковое заземление позволяет модели обращаться к актуальной веб-информации при генерации ответов, что ценно для приложений, которым нужны актуальные данные. Если ваш сценарий использования включает ответы на вопросы о текущих событиях, недавних выпусках продуктов или актуальных данных о ценах, поисковое заземление значительно повышает ценность — но вам следует запланировать бюджет на расходы, если вы ожидаете превышения бесплатных 5 000 ежемесячных запросов. Для большинства задач на этапе разработки и многих продакшн-приложений бесплатного лимита достаточно.

FAQ — частые вопросы о API Gemini 3.1 Pro Preview

Бесплатен ли API Gemini 3.1 Pro Preview?

Нет, API Gemini 3.1 Pro Preview не предлагает бесплатного уровня. В отличие от некоторых других моделей Gemini (например, Gemini 2.5 Flash, у которой есть бесплатный уровень с ограничением по частоте запросов), 3.1 Pro Preview требует платного биллинга с первого API-вызова. Однако вы можете бесплатно протестировать модель через браузерную песочницу Google AI Studio по адресу aistudio.google.com — кредитная карта не требуется. Песочница позволяет экспериментировать с промптами, загружать файлы и оценивать возможности модели перед подключением платного API.

Сколько стоит один API-вызов Gemini 3.1 Pro Preview?

Стоимость зависит от потребления токенов. При стандартных тарифах $2,00 за миллион входных токенов и $12,00 за миллион выходных токенов (включая токены «размышления») типичный API-вызов с 500 входными токенами и 1 500 выходными токенами будет стоить примерно $0,019 — менее двух центов. Вы можете снизить эту сумму ещё больше с помощью Batch API (скидка 50%), кэширования контекста (экономия 90% на кэшированных входных токенах) и контроля бюджета «размышлений». Большинство индивидуальных разработчиков тратят $5-50 в месяц на этапах разработки и тестирования.

В чём разница между Gemini 3 Pro и 3.1 Pro Preview?

Gemini 3.1 Pro Preview представляет собой значительный скачок по сравнению с Gemini 3 Pro, набирая 77,1% на ARC-AGI-2 против 31,1% у 3 Pro — более чем двукратное улучшение производительности рассуждений. Версия 3.1 также добавляет улучшенные возможности «размышления» с контролем бюджета, усовершенствованную генерацию кода (80,6% SWE-Bench по сравнению с предыдущими результатами) и улучшенную производительность на научных и математических бенчмарках. Обе модели имеют одинаковое контекстное окно в 1M токенов и поддержку мультимодального ввода, но улучшения рассуждений в 3.1 Pro Preview делают его значительно более способным для сложных аналитических задач.

Можно ли использовать Gemini CLI для доступа к Gemini 3.1 Pro Preview?

Да, Gemini CLI поддерживает Gemini 3.1 Pro Preview. Вы можете установить его и использовать модель напрямую из терминала для интерактивной помощи с кодом, анализа файлов и рабочих процессов командной строки. CLI требует действующий API-ключ с подключённым биллингом и использует те же тарифы, что и стандартный API. Это особенно полезно для разработчиков, которые хотят интегрировать AI-помощь в свои терминальные рабочие процессы без создания отдельного приложения.

Как Gemini 3.1 Pro сравнивается с Claude Opus 4.6 для задач программирования?

На бенчмарке SWE-Bench Verified (стандартном показателе реальных возможностей программной инженерии) Gemini 3.1 Pro Preview набирает 80,6% по сравнению с примерно 78% у Claude Opus 4.6 (The Decoder, февраль 2026). Однако практическая разница неоднозначна — Claude Opus 4.6 широко известен своей стабильностью в агентных рабочих процессах программирования и точностью выполнения инструкций, особенно в сценариях, где модели нужно следовать сложным многоэтапным инструкциям в продолжительных диалогах. Наиболее существенное различие — в ценообразовании: Gemini стоит $2/$12 за миллион токенов против $15/$75 у Claude, что делает Gemini примерно в 6 раз более экономически эффективным для задач программирования. Многие разработчики в феврале 2026 года применяют гибридный подход, используя Gemini 3.1 Pro Preview для массового анализа кода, автоматической генерации тестов и масштабных задач рефакторинга, где важна экономическая эффективность, а Claude Opus 4.6 оставляют для сложных агентных задач программирования, где критически важны точность выполнения инструкций и стабильность в продолжительных взаимодействиях.