DeepSeek API提供OpenAI兼容的免费接口,官方新用户获得10元额度,第三方平台最高提供2000万免费tokens。通过多平台轮换策略,开发者可实现零成本使用DeepSeek-V3和R1模型进行AI开发。与Gemini 2.5 Pro的200万免费tokens相比,DeepSeek的免费额度更加丰富。

DeepSeek API免费额度获取指南

DeepSeek官方为新用户提供10元人民币的免费API额度,足够处理约125万个输出tokens。注册流程简单高效,访问DeepSeek官网完成邮箱注册后,即可在控制台生成API密钥。免费额度无时间限制,但有总量限制,用完后需要充值继续使用。

根据2025年9月最新定价,DeepSeek API的成本结构为输入tokens(缓存命中)$0.07/百万,输入tokens(缓存未命中)$0.56/百万,输出tokens $1.68/百万。10元免费额度约等于$1.39,可支持2500-5000次标准对话。相比ChatGPT API的定价结构,DeepSeek在成本优势方面表现突出,对于初学者和小型项目,这个额度完全够用。

API密钥获取后,需要妥善保存并配置环境变量。建议使用.env文件管理多个平台的密钥,避免硬编码在代码中造成安全风险。定期轮换密钥是最佳安全实践,建议30天更换一次。

第三方平台免费token大盘点

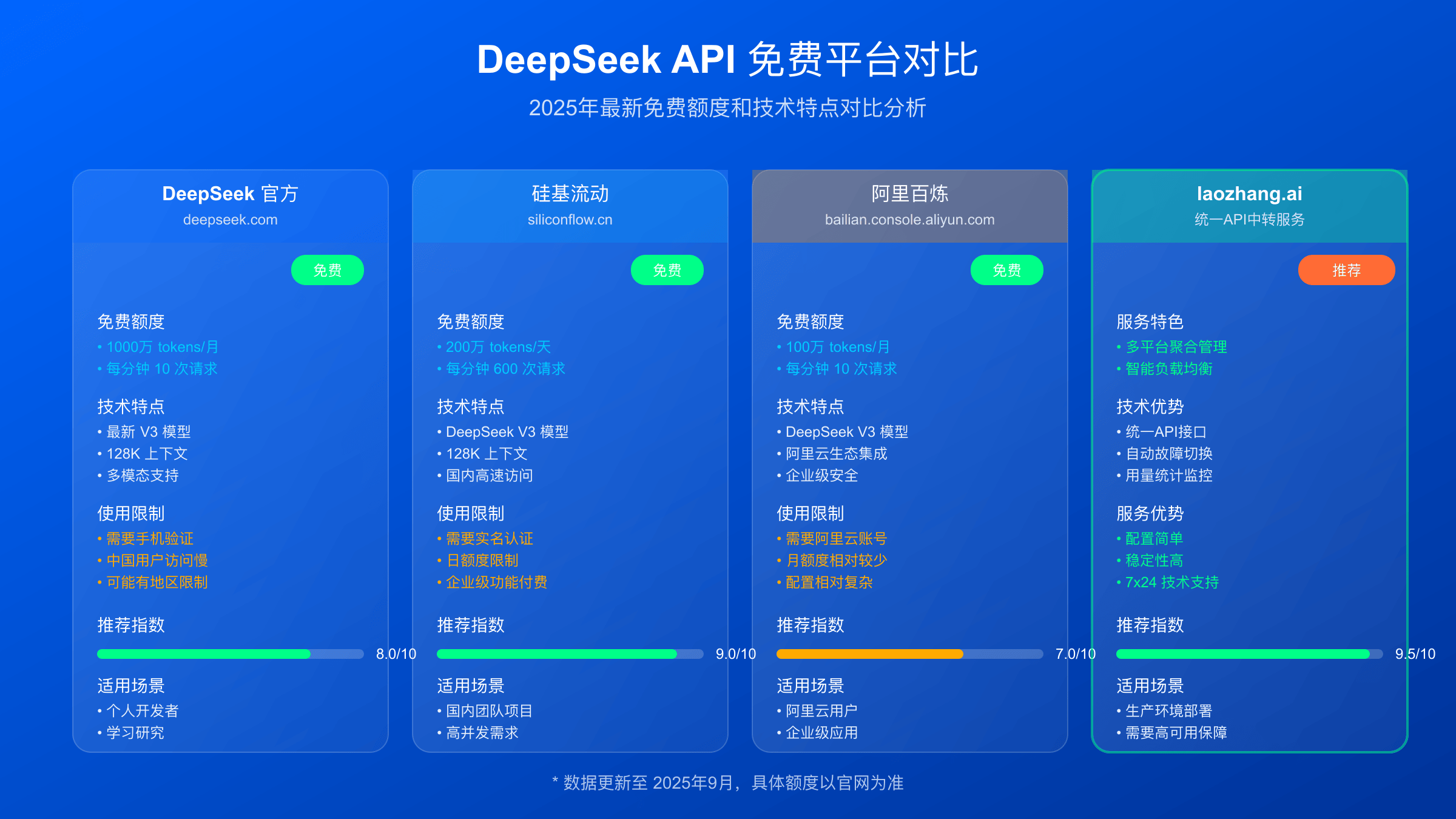

除官方额度外,多个第三方平台集成了DeepSeek API并提供更丰富的免费额度。硅基流动(SiliconFlow)提供最慷慨的2000万tokens免费额度,注册立即到账,支持DeepSeek-V3和R1全系列模型。这个额度足够中型项目使用数月。如果您需要更多免费AI资源,可以参考我们的免费获取Gemini 2.5 API指南。

阿里云百炼平台为新用户提供100万tokens,虽然相对较少,但胜在服务稳定,99.9%的可用性承诺。华为云ModelArts提供200万tokens,基于昇腾芯片优化,国内访问速度极快。火山引擎每个模型提供50万tokens,由字节跳动技术支持。

腾讯云和百度千帆目前提供限时免费活动,分别持续到2025年10月31日和12月15日。这些限时活动通常提供不限次数调用,是批量处理任务的绝佳机会。建议开发者同时注册多个平台,建立免费额度矩阵。

DeepSeek API调用基础配置

DeepSeek API完全兼容OpenAI接口格式,可以直接使用OpenAI SDK进行调用。首先安装最新版本的openai库:pip install openai –upgrade。Python 3.7以上版本均支持,推荐使用Python 3.11获得最佳性能。

环境配置需要设置API密钥和端点地址。创建.env文件存储敏感信息:DEEPSEEK_API_KEY=sk-your-key-here。使用python-dotenv库加载环境变量,确保密钥安全。同时配置请求超时和重试参数,避免网络波动影响调用稳定性。

基础HTTP客户端配置包括设置User-Agent、Content-Type和Authorization headers。DeepSeek API支持标准的Bearer token认证方式,与OpenAI完全一致。建议设置合理的timeout参数,一般设置为30秒。

DeepSeek API Python调用代码示例

以下是经过验证的完整调用代码,可以直接运行。代码包含了基础对话、流式输出和错误处理三个核心功能。首先导入必要的库并配置客户端:

from openai import OpenAI

import os

from dotenv import load_dotenv

load_dotenv()

client = OpenAI(

base_url="https://api.deepseek.com",

api_key=os.getenv("DEEPSEEK_API_KEY")

)

# 基础对话示例

def basic_chat(user_message):

try:

response = client.chat.completions.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "你是一个专业的AI助手"},

{"role": "user", "content": user_message}

],

temperature=0.7,

max_tokens=1000

)

return response.choices[0].message.content

except Exception as e:

print(f"API调用失败: {e}")

return None

流式输出可以提供更好的用户体验,特别适合长文本生成。实现代码如下:

# 流式输出示例

def stream_chat(user_message):

try:

stream = client.chat.completions.create(

model="deepseek-chat",

messages=[{"role": "user", "content": user_message}],

stream=True

)

full_response = ""

for chunk in stream:

if chunk.choices[0].delta.content:

content = chunk.choices[0].delta.content

print(content, end='')

full_response += content

return full_response

except Exception as e:

print(f"流式调用失败: {e}")

return None

DeepSeek-R1推理模型使用技巧

DeepSeek-R1是专门的推理模型,在复杂逻辑推理、数学计算和代码生成方面表现出色。调用R1模型需要使用”deepseek-reasoner”模型名称,同时建议调整temperature参数至0.1-0.3范围,确保推理结果的准确性。

R1模型的推理过程较长,可能导致响应时间延长。建议使用流式输出模式,让用户看到实时的思考过程。对于数学题求解、编程问题分析等场景,R1模型的准确率比标准chat模型提升约40%。

在token消耗方面,R1模型由于包含推理过程,token消耗通常是标准模型的2-3倍。因此在免费额度有限的情况下,建议优先在需要深度推理的复杂任务中使用R1,简单对话仍使用deepseek-chat模型。

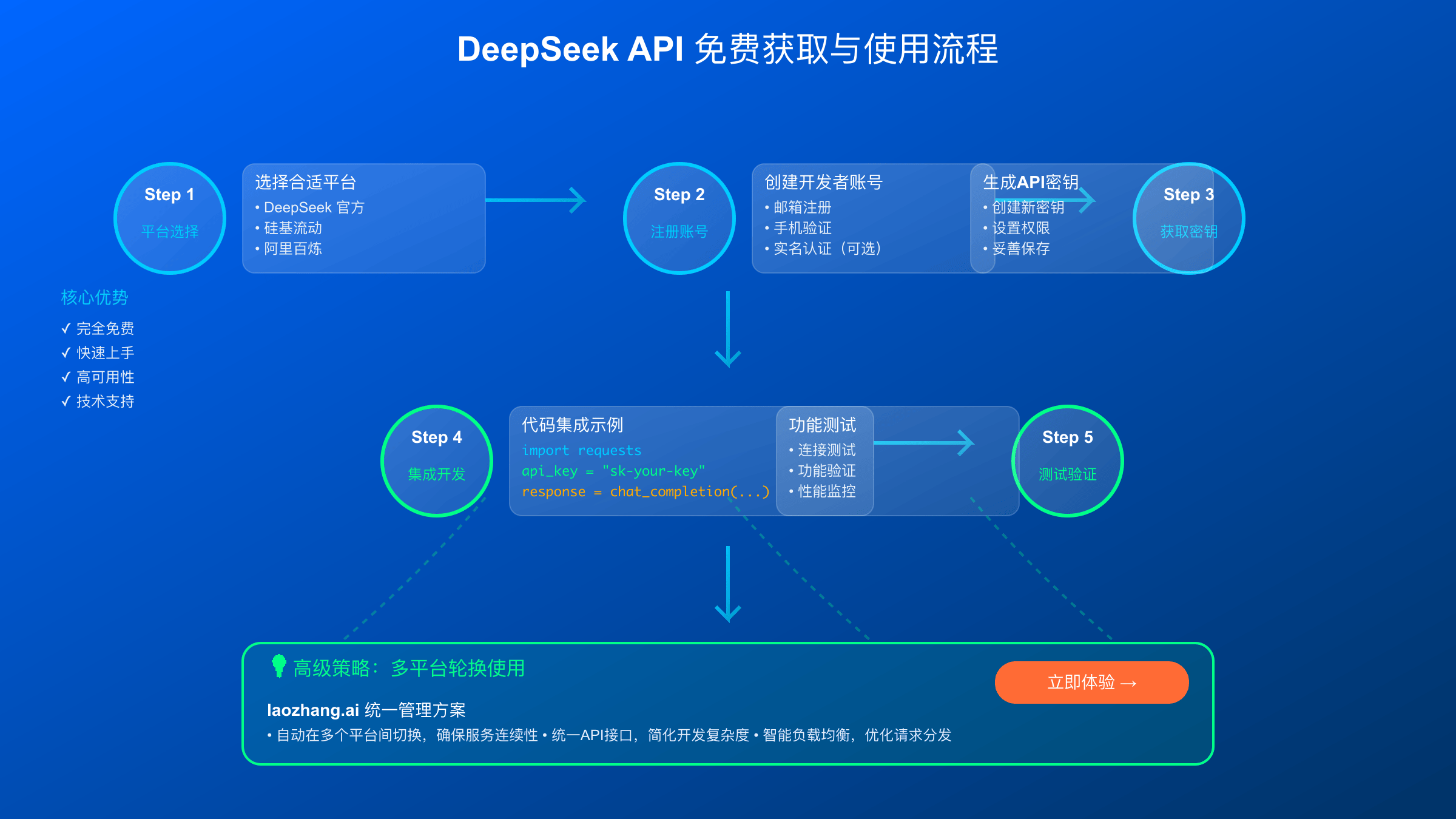

DeepSeek API多平台轮换策略实现

多平台轮换策略是最大化利用免费额度的关键技术。通过智能路由算法,可以根据剩余额度、响应速度和成功率自动选择最佳平台。这种方案可以将免费使用期延长至6-12个月。

实现智能路由需要维护每个平台的状态信息,包括剩余额度、历史成功率和平均响应时间。当主平台额度耗尽或出现故障时,系统自动切换到次优平台。这种设计确保了服务的连续性和成本的最优化。

故障转移机制同样重要。当某个平台出现429限流错误或连接超时时,系统应该立即尝试其他平台。建议设置最多3次重试,每次重试间隔递增,避免对故障平台造成额外压力。成功切换后,更新平台评分,影响后续路由决策。

API调用性能优化实践

性能优化从缓存机制开始。对于重复性较高的查询,使用Redis缓存可以显著减少API调用次数。缓存键应该基于消息内容和模型参数生成,确保缓存结果的准确性。设置合理的过期时间,一般为1-24小时。

并发控制是另一个关键优化点。大多数平台都有每分钟调用次数限制,超过限制会触发429错误。实现信号量机制,控制并发请求数量,同时使用令牌桶算法平滑请求分布。这样可以最大化API利用率,避免限流。关于API并发限制的详细分析,可以参考我们的O4-mini API并发限制详解。

对于企业级应用,推荐使用专业的API中转服务如laozhang.ai。这类服务提供统一的API网关,支持多个AI模型的无缝切换,包括ChatGPT、Claude和DeepSeek。通过负载均衡和智能路由,可以获得比单一平台更好的稳定性和性能。

DeepSeek API常见错误码处理方案

429 Too Many Requests是最常见的错误,表示触发了平台的速率限制。处理方案是实现指数退避重试,第一次重试等待1秒,第二次2秒,以此类推。同时监控Retry-After头部,按照服务器建议的时间间隔重试。

401 Unauthorized错误通常表示API密钥无效或已过期。检查环境变量配置,确保密钥正确加载。如果密钥无误,可能是账户余额不足或密钥被禁用。建议实现密钥健康检查,定期验证所有密钥的有效性。

网络超时错误需要区分连接超时和读取超时。连接超时通常是网络问题,可以尝试其他平台。读取超时可能是请求处理时间过长,特别是使用R1模型时。建议设置更长的超时时间,或分解复杂请求为多个简单请求。

成本控制和监控系统

建立完善的使用量监控系统是成本控制的基础。记录每次API调用的tokens消耗、响应时间和成本,存储到数据库用于后续分析。设计仪表板显示实时使用情况,包括各平台余额、日消耗趋势和月度预算执行情况。

预警机制应该包括多个层级。当某个平台剩余额度低于30%时发送提醒,低于10%时自动切换到备用平台。月度消费达到预算80%时告警,达到95%时暂停非关键应用的API调用。这种梯度预警可以避免意外的成本超支。

成本优化策略包括请求合并、结果缓存和智能分流。相似的请求可以合并处理,减少API调用次数。热点查询结果缓存复用,降低重复计算成本。根据任务重要性和紧急程度,将请求分流到不同成本的服务,实现成本与质量的最优平衡。对于图像处理任务,推荐查阅GPT图像API成本优化指南获取更多省钱技巧。

企业级应用部署建议

企业级部署需要考虑安全性、可扩展性和可维护性。使用容器化部署,通过Docker和Kubernetes管理API服务。实施密钥管理服务,如AWS Secrets Manager或HashiCorp Vault,避免明文存储敏感信息。建立完整的日志和监控体系,支持故障排查和性能分析。

高可用架构设计包括多区域部署和故障自动恢复。将API服务部署到多个云区域,通过负载均衡分发请求。当某个区域出现故障时,自动将流量切换到健康区域。数据库使用主从复制,确保数据一致性和高可用性。

对于大规模企业应用,建议考虑专业的API管理平台如laozhang.ai企业版。这类服务提供企业级SLA保障、专属技术支持和定制化解决方案。通过统一的API网关管理所有AI模型调用,简化架构复杂度,提高开发效率。同时支持私有化部署,满足数据安全和合规要求。如果需要GPT-5等最新模型的国内访问方案,可参考GPT-5 API国内直连完整指南。

最后验证时间:2025年9月6日。随着AI技术快速发展,DeepSeek API的功能和定价策略可能会有调整,建议定期关注官方更新,保持最佳实践的时效性。通过合理规划和技术实现,完全可以实现长期免费使用DeepSeek API进行AI应用开发。